Big was beautiful — Wie die Dampfkraft unsere Institutionen geprägt hat

Geschichte der Energietechnik (12) – Die Entdeckung der Nanowelten ermöglicht eine erneuerbare Energieversorgung für Alle

In Folge 9 dieser Serie hatte ich angekündigt, die vier fundamentalen Innovationen für eine nachhaltige Energieversorgung darzustellen, die sich aus der Entdeckung der Nanowelten vor etwa hundert Jahren ergeben haben. In den letzten beiden Folgen haben wir gesehen, wie die Photovoltaik gegen große Widerstände bisher grundlegende Annahmen des Energiesystems erschüttert. Bevor ich als nächste Innovation die Leistungselektronik und ihre Bedeutung für das gesamte Stromsystem eingehender darstelle, ist es hilfreich, zunächst einmal den Blick zurückzuwenden und genauer anzusehen, wie die etablierte Elektrizitätsversorgung eigentlich entstanden ist. Dabei werden wir feststellen, dass viele Annahmen und Strukturen, die heute in der Energiewelt und der Politik noch als weitgehend selbstverständlich gelten, historisch aufgrund von Voraussetzungen entstanden sind, die heute nicht mehr stimmen. In dieser Folge geht es um die Entwicklung bis zum zweiten Weltkrieg, in der nächsten vor allem um die zunehmenden Widersprüche seit den siebziger Jahren.

Die klassische Technik der Stromversorgung ist auf große zentrale Kraftwerke angewiesen

Das Stromsystem der meisten Länder beruht im Wesentlichen noch heute auf der klassischen elektromechanischen Starkstromtechnik:

Riesige Wasser- oder Dampfturbinen treiben auf der gleichen Achse sitzende Stromgeneratoren so gleichmäßig an, dass der erzeugte Wechselstrom immer genau die gleiche Frequenz hat. Die Frequenz – in deren Rhythmus der Wechselstrom hin und her fließt – muss im ganzen Netz synchron sein, denn größere Unterschiede verursachen ernsthafte Störungen. Ungleichgewichte zwischen Erzeugung und Verbrauch verursachen kleine Abweichungen von der Soll-Frequenz (im europäischen Netz 50 Hertz, d.h. Schwingungen pro Sekunde). Diese Abweichungen werden dazu genutzt, die Erzeugung so zu steuern, dass sie in jedem Zeitpunkt dem Verbrauch entspricht: der Dampfdruck an der Turbine wird so geregelt, dass die Frequenz wieder stimmt. Große schwere Turbinen sind dafür vorteilhaft, weil sie mit ihrer Trägheit kleine Verbrauchsschwankungen ausgleichen können.

Nach der Erzeugung im Kraftwerk wird der Strom für den Transport über längere Strecken mit haushohen Transformatoren auf hohe Spannungen transformiert, damit die Verluste in den Leitungen nicht zu hoch sind. Auf der Verbraucherseite wird der Strom wieder in mehreren Stufen heruntertransformiert. Wenn durch hohen Verbrauch die Spannung in einer Leitung zu sehr abfällt, muss sie – bei Verwendung herkömmlicher Technik – durch mechanisches Schalten der Transformatoranschlüsse korrigiert werden. Wegen des hohen Aufwandes gibt es in traditionellen Netzen nur wenige Mess- und Schaltpunkte, was durch erhebliche Reserven in der Leitungskapazität kompensiert wird. Durch die zentrale Steuerung einer überschaubaren Anzahl großer Kraftwerke können mit dieser Logik große Versorgungsnetze stabil betrieben werden.

Die Entwicklung dieses Systems hat nachvollziehbare historische Gründe und hat unser Denken, unsere Institutionen und unsere Wirtschaftsstrukturen stark geprägt. Aber jetzt bringt die zunehmende Stromerzeugung mit Hunderttausenden kleiner Solar- und Windkraftwerke diese Logik durcheinander. Sie gehorchen keinen festen Fahrplänen und speisen ihren Strom weit verstreut auf der Ebene der Verteilnetze ein. In manchen Leitungen fließt der Strom zeitweise sogar in die umgekehrte Richtung. Das einfache Muster der Verteilung von oben nach unten wird gestört. Ein ganz anderer Ansatz zur Steuerung des Gesamtsystems wird nötig. Oder ist die dezentrale Stromerzeugung eine Sackgasse? Wie und warum kam es überhaupt zu den heutigen Strukturen?

Die Entdeckung der Elektrizität als vielseitiger, sauberer Energieträger

Die heute noch dominanten Prinzipien und Komponenten des Elektrizitäts-Versorgungssystems wurden bereits im 19. Jahrhundert entwickelt. Bis zur vollen Herausbildung eines entsprechenden Versorgungssystems und der entsprechenden Institutionen in den wichtigsten Industrieländern brauchte es noch bis etwa 1930.

Seit Alessandro Volta um 1800 in Pavia mit der Volta’schen Säule die erste funktionierende Batterie entwickelt hatte, stand erstmals eine kontinuierliche Spannungsquelle für die elektrotechnische Forschung zur Verfügung. 1809 entwickelte Humphry Davy in London die Bogenlampe, die erstmals ein kontinuierliches, helles elektrisches Licht liefern konnte. 1820 entdeckte Hans Christian Oersted in Kopenhagen die magnetische Wirkung des elektrischen Stroms. Umgekehrt entdeckten 1831 Joseph Henry in New York und Michael Faraday in London die Erzeugung eines elektrischen Stroms durch ein veränderliches Magnetfeld. Ab 1832 erforschte Faraday die Elektrolyse. Damit waren die Grundprinzipien der Elektrotechnik gefunden, auch wenn man noch nicht so recht verstand, wie Elektrizität und Magnetismus zusammenhingen.

Dann folgten bald die ersten praktischen Anwendungen. 1834 baute Moritz Jacobi den ersten funktionierenden Elektromotor mit Gleichstrom und trieb damit auf der Newa in St. Petersburg ein Boot an. 1854 erfand Wilhelm Sinsteden den Bleiakkumulator, der später von Gaston Planté wesentlich verbessert wurde. Aufbauend auf verschiedenen Vorläufern entwickelten schließlich 1866 unabhängig voneinander Werner Siemens, Charles Wheatstone und Samuel Varley die ersten industriell nutzbaren Gleichstrom-Generatoren. Damit stand erstmals elektrische Energie in Mengen zur Verfügung, die eine breite Nutzung möglich machten.

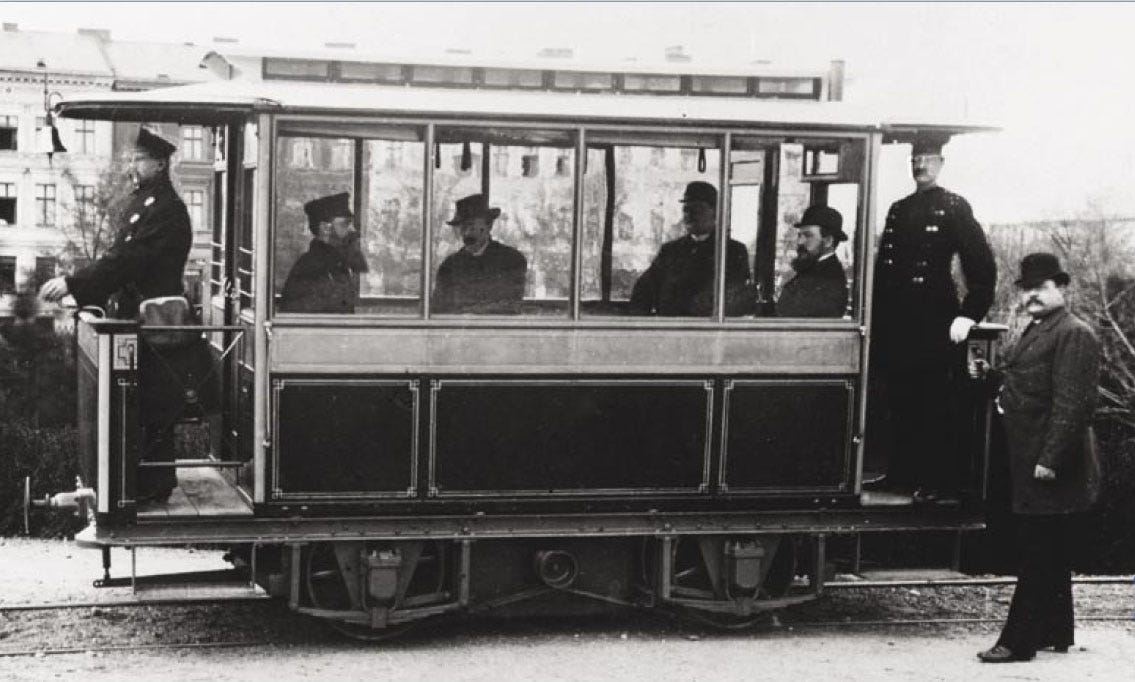

Das löste intensive erfinderische und industrielle Aktivitäten aus. Ab 1870 wurde mittels Elektrolyse Kupfer gewonnen. 1879 nahm Siemens in Berlin die erste elektrische Bahn in Betrieb. Im gleichen Jahr machte Edison mit der Erfindung der Kohlenfaden-Glühlampe die Nutzung der Elektrizität für eine breite Öffentlichkeit attraktiv. Ab 1880 fing er an, kleine Gleichstromnetze aufzubauen, zunächst in den USA, dann auch in Europa. In Deutschland entstand daraus später die Firma AEG, in den USA die General Electric.

Edison war ein überaus vielseitiger Erfinder und Unternehmer, der über tausend Patente anmeldete, nicht nur im Bereich der Elektrizität. Sein großes Verdienst waren jedoch nicht einzelne Erfindungen, sondern sein Denken in Systemen. Er entwickelte die Vision von vernetzten Versorgungssystemen von der Stromerzeugung bis zur Glühbirne in der Wohnung und dem Motor im Betrieb. Dafür musste er die Zusammenarbeit verschiedenster Spezialisten sowie von Industrie und Politik organisieren.

Mit der Wechselstromtechnik gelingt der Stromtransport über größere Entfernungen

Für die ersten Elektromotoren und für die Elektrolyse war Gleichstrom erforderlich. Deshalb musste in den ersten Generatoren die durch die Rotation entstehende Wechselspannung durch automatisches Umpolen mit Schleifkontakten in Gleichspannung verwandelt werden. Aber es wurde weiter mit Wechselspannung experimentiert. Wie schon Oersted und Faraday gezeigt hatten, erfolgte die Energieübertragung zwischen elektrischen und magnetischen Feldern nur dann, wenn die Stärke der Felder verändert wurde – sei es durch Bewegung oder Änderung der Stromstärke. Darauf beruhte ja die Funktionsweise von Elektromotoren und Generatoren.

1864 gelang es James Clerk Maxwell, diese Zusammenhänge in wenigen, für Laien kaum verständlichen Differentialgleichungen zu formulieren, und damit eine umfassende Theorie der Elektrodynamik aufzustellen, die der Ausgangspunkt für viele weitere Entwicklungen wurde.

Wegen der Leitungsverluste war die Reichweite der Edison‘schen Gleichstromnetze auf wenige Kilometer beschränkt. Weil Wasserkraft, die mitunter weiter entfernt war, zum Antrieb von Generatoren kostengünstiger war als der Betrieb von Dampfmaschinen, und weil größere Dampfmaschinen billiger zu betreiben waren als kleine, setzten intensive Bemühungen ein, diese Beschränkung zu überwinden.

1881 patentierten Gaulard und Gibbs in London einen Transformator, wie er im Prinzip noch heute gebaut wird. Auf einem Eisenkern, mit dem sich magnetische Felder besonders gut bündeln ließen, brachten sie zwei Spulen an. Schickte man Wechselstrom durch eine der Spulen, baute sich bei jeder Schwingung ein Magnetfeld auf, dessen Energie sich durch einen Stromfluss in der anderen Spule abgreifen ließ. War die Zahl der Windungen der zweiten Spule größer als in der ersten, war dort die Spannung entsprechend höher als auf der Eingangsseite, die Stromstärke hingegen entsprechend geringer. Das funktionierte auch umgekehrt. Bei gleicher Leistung (Spannung mal Stromstärke) konnte damit also elektrische Energie auf ein anderes Spannungsniveau „transformiert“ werden.

Eindrucksvoll demonstrierten sie 1884 mit der Stromübertragung aus einem 50 km entfernten Wasserkraftwerk zu einer Ausstellungshalle in Turin, dass durch die Erhöhung der Übertragungsspannung mit Wechselstrom auch größere Entfernungen überbrückt werden konnten. Während in Europa die ungarische Firma Ganz & Compagnie das Konzept verbreitete, ließ sich in den USA der Erfinder und Industrielle George Westinghouse von den Vorteilen der Wechselstromnetze überzeugen und kaufte 1885 die amerikanischen Rechte am Transformator-Patent. Schon zwei Jahre später hatte er Wechselstromnetze mit 130‘000 Glühlampen im Betrieb oder im Bau. Der vor allem in den USA ausgetragene Wettkampf mit den Gleichstromnetzen des Konkurrenten Edison dauerte viele Jahre. Denn die Reichweite der Gleichstromnetze war zwar begrenzt, aber Elektromotoren konnten damals nur mit Gleichstrom betrieben werden.

Seit der Erfindung des Transformators versuchten deshalb viele Erfinder, einen Wechselstrommotor zu entwickeln. In kaum zu entwirrender Parallelität, Konkurrenz und gegenseitiger Beeinflussung waren mehrere Erfinder an der Entwicklung des Mehrphasen-Wechselstroms sowie entsprechender Generatoren und Motoren beteiligt: Galileo Ferraris (Turin), Nikola Tesla (New York), Friedrich August Haselwander (Offenburg), Charles S. Bradley und andere. Das war nicht zuletzt eine anspruchsvolle mathematische Aufgabe.

Den Durchbruch brachte ab 1888 das Konzept des Dreiphasen-Wechselstroms (Drehstroms) mit entsprechenden Motoren und Generatoren, das Michail von Dolivo-Dobrovolski bei der Firma AEG in Berlin entwickelte. 1891 demonstrierte er in Zusammenarbeit mit Charles E. Brown von der Maschinenfabrik Oerlikon (später Brown Boveri & Cie) auf der Internationalen Elektrotechnischen Ausstellung in Frankfurt am Main, dass das vollständige System funktionierte: In einem Wasserkraftwerk wurde Strom von 50 Volt mit einer Frequenz von 40 Hertz erzeugt, auf 15‘000 Volt hochtransformiert, über 150 km nach Frankfurt übertragen und dort heruntertransformiert, um einen großen und mehrere kleine Motoren anzutreiben, sowie 1000 Glühbirnen zu versorgen. Das überzeugte. Auf der anderen Seite des Atlantiks triumphierte Westinghouse mit Tesla gegen Edison im Wettbewerb für die Beleuchtung der Weltausstellung in Chicago 1893: Die mit Wechselstrom und den von Tesla erfundenen Fluoreszenzlampen hell erleuchteten Hallen beendeten unter allgemeiner Bewunderung den „Battle of Currents“.

Mit diesen Erfindungen waren Anfang der 1890er Jahre alle grundlegenden Techniken für das heute weltumspannende Stromversorgungssystem entwickelt.

Die systemische Veränderung der technischen Energienutzung durch die Einführung der Elektrizität

Aus Sicht der Nutzer bot die Einführung der Elektrizität vielfältige Vorteile. Mit dem Strom aus der Leitung konnten ohne weiteren Aufwand für Transport und Speicherung, in kleinsten und größeren Mengen Licht, mechanischer Antrieb und Wärme erzeugt werden — ohne Abgase, Staub und Lärm, ganz einfach ein- und ausschaltbar. Das bedeutete einerseits Komfort im privaten Haushalt und einen wachsenden Absatzmarkt für elektrische Geräte. Andererseits, und das wurde immer wichtiger, einen riesigen Entwicklungssprung für Handwerk, Industrie und Dienstleistungen. Muskelkraft und zentrale Dampfmaschinen — von denen zuvor über aufwändige Riemenantriebe mechanische Energie zu einzelnen Produktionsmaschinen übertragen wurde — konnten durch Elektromotoren beliebiger Größe ersetzt werden, die dezentral, direkt am Arbeitsplatz gut steuerbar die Arbeit verrichteten. Das erlaubte die Konstruktion ganz neuartiger Maschinen, in denen auch ganz gezielt elektrisch erzeugte Wärme eingesetzt werden konnte. Damit eröffnete die Elektrizität auf der Nutzerseite ein riesiges Potential zum dezentralen Einsatz von technischer Energie. Was zuvor nur in Handarbeit oder in großen Fabriken möglich war, konnte teilweise in kleinen Betrieben oder zu Hause erledigt werden. Darüber hinaus eröffneten sich auch für die große Industrie ganz neue Möglichkeiten, z.B. mit der Elektrochemie.

Aus systemischer Sicht war die Elektrizität ein neuer, zwischengeschalteter Energieträger, der durch seine Vielseitigkeit, Sauberkeit, Transportierbarkeit und Steuerbarkeit ganz neue Flexibilität und damit neue Anwendungsmöglichkeiten in die technische Energienutzung einführte.

Wasserkraft, die bislang an den wenigen Orten, wo sie vorkam, nur ganz lokal als mechanische Energie eingesetzt werden konnte, ließ sich plötzlich in großem Maßstab mit immer effizienteren Turbinen in vielseitig nutzbare Elektrizität umwandeln, die mit geringen Verlusten über Hunderte von Kilometern zum Einsatzort transportiert werden konnte. Der größte Teil der Elektrizität musste jedoch in thermischen Kraftwerken aus Brennstoffen erzeugt werden.

Der zuvor in Gaslampen, Dampfmaschinen und Öfen stattfindende Verbrennungsvorgang wurde durch das Dazwischenschalten des Energieträgers Elektrizität in die Kraftwerke ausgelagert. Das hatte nicht nur den Vorteil, dass der Energieeinsatz auf der Nutzungsseite flexibler, kleinteiliger und sauberer wurde, sondern auch, dass die Brennstoffverwertung auf der Erzeugerseite in großen Kraftwerken effizienter ablaufen, sowie Abgase und Aschen besser abgefangen werden konnten.

Doch die zusätzlichen Umwandlungsschritte haben auch ihre Tücken: während Elektrizität mit hohen Wirkungsgraden in mechanische Energie und Wärme umgesetzt werden kann, geht im Wärmekraftwerk bei der Wandlung von Wärme in Elektrizität unweigerlich der größere Teil der Wärmeenergie verloren. Deshalb war und ist es nicht sinnvoll, Strom, der mit Kohle, Öl oder Gas hergestellt wurde, für die Erzeugung größerer Wärmemengen einzusetzen. Die direkte Verbrennung am Einsatzort der Wärme ist — soweit technisch realisierbar — viel effizienter.

Eine folgenreiche Eigenschaft des Drehstroms ist sein extrem dynamischer Charakter: er kann als solcher nicht gespeichert werden. Verbrauch und Erzeugung müssen sich immer genau die Waage halten. Das erfordert ein hohes Maß von Koordination und Normierung entlang der gesamten Kette von der Erzeugung über verschiedene Spannungsebenen der Netze bis hin zur Nutzung, synchron im gesamten Versorgungsgebiet. Wechselstrom kann nicht wie Holz, Kohle, Öl oder Gas in Pufferspeichern gelagert werden, um Schwankungen auszugleichen. Für eine Speicherung ist erst eine Umwandlung in andere Energieformen notwendig. Edisons Gleichspannungsnetze hatten teilweise noch Batteriespeicher, die halfen, Unregelmäßigkeiten und schwankende Auslastung der Leitungen auszugleichen. Aber Batterien blieben lange teuer und die dafür notwendige Umwandlung des Wechselstroms in Gleichstrom war lange sehr aufwändig (siehe nächste Folge dieser Serie).

An eine komplexe Steuerung, die eine große Zahl von Verbrauchern und Produzenten optimal „real-time“ koordiniert hätte, war mit den damaligen technischen Mitteln nicht zu denken. Für eine grobe Steuerung des Verbrauchs wurden daher Fahrpläne der industriellen Verbraucher festgelegt und Erfahrungswerte der Kleinverbraucher erhoben. Ansonsten wurde das System von der Produktionsseite her gesteuert: Wenige große Kraftwerke wurden mit den begrenzten Kommunikationsmitteln so gefahren, dass als Indikator für das Gleichgewicht zwischen Produktion und Verbrauch die Netzfrequenz konstant gehalten wurde. Dabei nahm man mangels besserer Steuerungsmöglichkeiten in Kauf, dass große Teile des Netzes während eines großen Teils der Zeit kaum ausgelastet waren. Zudem wurden insbesondere in großen Wasserspeicher-Kraftwerken beträchtliche Leistungsreserven vorgehalten, die kurzfristig einspringen konnten.

Wie wir noch sehen werden, hatte diese Anforderung an einen synchronen, weitgehend speicherlosen Betrieb des Gesamtsystems und die vereinfachte top-down-Steuerung durch Großkraftwerke beträchtlichen Einfluss auf die entstehende Struktur der Elektrizitätsversorgungs-Industrie.

Die unterschiedliche Entwicklung der Stromsysteme bis zum ersten Weltkrieg

Die Unterschiede in der Herausbildung der Stromversorgung in den verschiedenen Industrieländern zeigen deutlich, dass nicht nur die Technologien, sondern auch die unterschiedlichen kulturellen, wirtschaftlichen und politischen Bedingungen Einfluss auf die Entwicklung großer soziotechnischer Systeme haben – und dass umgekehrt die Entwicklung der Technik Einfluss auf die Herausbildung von Institutionen hat.

In den USA brachte vor allem der Bau des großen Niagara-Kraftwerks 1895 die Einigung auf ein „universales Stromsystem“ schnell voran. Bestehende Gleichstromnetze wurden über eine mechanische Kopplung integriert. Als Kompromiss aus vielfältigen Interessen einigte man sich auf eine Netzfrequenz von 60Hz. Die Konsensfindung wurde durch einen Generationswechsel erleichtert: Thomas Edison, der bis zuletzt mit der Wechselstromversorgung gehadert hatte, zog sich zurück, als aus seiner weltweit aktiven Firma der General Electric Konzern hervorging. An vielen Hochschulen waren Studiengänge für Elektrotechnik entstanden. Es wuchs eine neue Generation von Ingenieuren heran, die mit dem komplexen Konzept des Drehstroms besser zurechtkam. Aber Thomas Edison war der entscheidende Pionier gewesen, der den Übergang von der Entwicklung einzelner Apparate zur Konzeption und Realisierung von ganzen Systemen einleitete. Die erforderten ganz neue Formen der Zusammenarbeit, von verschiedensten Disziplinen und Gewerken, von Wissenschaft, Industrie und Politik. Schon zu Edisons Zeiten führte das zum Aufbau internationaler industrieller Imperien und einer engen Verflechtung von Industrie und Politik, wie es sie zuvor nicht gegeben hatte.

In seinem Vergleich der Entwicklungen in Chicago, London und Berlin stellte der amerikanische Technikhistoriker Thomas P. Hughes (Hughes 1993) sehr ausführlich dar, wie die unterschiedlichen wirtschaftlichen und politischen Bedingungen in den drei für die Elektrizitätswirtschaft damals wichtigsten Ländern die Entwicklung der Stromversorgungssysteme ganz unterschiedlich prägten – trotz gleicher technischer Grundlage.

Große Industriekunden und große Hersteller elektrischer Anlagen erlaubten es in Chicago und Berlin, schnell größere Netze zu entwickeln. Damit konnte man immer effizientere Kraftwerke einsetzen und durch eine diverse Kundschaft die Anlagen gut auslasten. Im von großen Industriebetrieben geprägten Chicago instrumentalisierte die sebstbewusste Elektroindustrie die Politik für ihre Ziele – im Zweifel auch mit fragwürdigen Methoden.

Im schnell wachsenden Berlin sorgte die zielstrebig regulierende, an der Entwicklung interessierte Politik für eine gute Zusammenarbeit mit den aufstrebenden Elektrokonzernen. Die Politik hatte schon die Einführung der ersten Gleichstromnetze durch Rathenaus Allgemeine Elektricitätsgesellschaft (AEG) mit überlegter Regulierung wohlwollend begleitet. Nachdem die gleiche AEG die Entwicklung der Drehstromtechnik entscheidend vorangebracht und in den Anlagenbau eingestiegen war einigten sich alle Beteiligten schnell auf ein Universalsystem mit 50 Hz. AEG und Siemens, die ursprünglich verschiedene Rollen hatten, wurden zu Konkurrenten, aber arbeiteten aus Interesse an einem gemeinsamen, standardisierten System auch immer wieder zusammen.

In London hingegen, das durch eine kleinteilige Wirtschaft geprägt war, deren Ausstattung mit Dampfmaschinen schon viel früher eingesetzt hatte, verhinderte die Politik die Entwicklung größerer Netze. In weiten Teilen Großbritanniens wollte jede Gemeinde ihre eigenen, individuell ausgestalteten Systeme haben. Die Elektroindustrie blieb kleinteilig. Noch 1914 gab es in London mit seiner komplexen kommunalen Struktur mindestens zehn verschiedene Netzfrequenzen und eine noch weit höhere Zahl von Netzspannungen, was die Entwicklung eines Marktes für Generatoren und elektrische Apparate erheblich behinderte.

Um 1911 betrug die durchschnittliche Kapazität der Kraftwerke in Chicago 37 Megawatt, in Berlin 23 Megawatt und in London 4,7 Megawatt. Der Wirkungsgrad der Kraftwerke in London war nur etwa halb so hoch wie in Berlin. In London wurden über 60% des Stroms für Beleuchtung verwendet, in Chicago und Berlin lediglich um die 20% - entsprechend war die Auslastung der Anlagen in London deutlich schlechter.

In atemberaubender Geschwindigkeit wuchsen die weitgehend heute noch bekannten großen Unternehmen der Elektroindustrie: Westinghouse, General Electric, Siemens, AEG, BBC (BrownBoveri&Cie). Vor dem Ersten Weltkrieg nahm die deutsche Elektroindustrie mit ca. 50 % der Weltproduktion die Führungsposition ein.

Die schnelle Entwicklung in Deutschland in Verbindung mit zunehmend aggressivem Nationalismus und Aufrüstung im Deutschen Reich führte zu wachsender Besorgnis in England, das am Anfang des Jahrhunderts im Zuge der ersten Industrialisierung einen schnellen Wachstumsschub erlebt hatte. Pro-Kopf-Einkommen und Bevölkerung wuchsen in Deutschland schneller als in England oder Frankreich — in den USA freilich waren die Wachstumsraten noch viel höher.

Koevolution von Technik und Institutionen

1926 stellte der Wirtschaftswissenschaftler Nikolai Kondratjew in seinem Aufsatz Die langen Wellen die These auf, dass technologische Innovationen 40 bis 60 Jahre dauernde Zyklen der Wirtschaftsentwicklung auslösen, die von kürzeren Konjunkturzyklen überlagert werden. Ein erster Zyklus wurde nach dieser einflussreichen Theorie am Ende des 18. Jahrhunderts durch die Dampfmaschine und den mechanischen Webstuhl ausgelöst, eine zweite um 1850 durch die Eisenbahn und die Stahlherstellung, eine dritte sah Kondratjew gerade auf dem Höhepunkt - ausgelöst durch die elektrotechnischen und chemischen Technologien. Parallel zur Elektroindustrie hatte es vor allem in den USA und Deutschland auch eine schnelle Entwicklung der industriellen Chemie gegeben. Diese technologiezentrierte Sichtweise - die in mitunter anderer Zählweise auch von industriellen Revolutionen sprach - hielt sich lange. Sie war mit der Vorstellung einer notwendigen Abfolge von technologischen und in der Folge auch gesellschaftlichen Entwicklungsstufen verbunden. Insbesondere nach der Katastrophe des zweiten Weltkriegs gab eine solche Sichtweise Hoffnung auf eine bessere Zukunft.

Aber diese Sichtweise konnte die unterschiedlichen Entwicklungen in verschiedenen Ländern nicht erklären. Deshalb interessierte sich die Wirtschaftsgeschichtsschreibung ab den 1960er Jahren zunehmend für den gesellschaftlichen Kontext technischer und industrieller Entwicklungen. Sie stellte fest, dass bereits im späten Mittelalter die kulturellen und institutionellen Voraussetzungen für die spätere „industrielle Revolution“ geschaffen wurden, und dass auch die wissenschaftlichen und technischen Vorläufer viel früher anzusetzen waren, als man lange Zeit angenommen hatte. Offenbar hatten die kulturellen und institutionellen Rahmenbedingungen einen größeren Einfluss auf die Entwicklung als bis dahin angenommen. Die gerade beschriebene unterschiedliche Entwicklung der Stromsysteme in verschiedenen Ländern war ein Beispiel dafür.

Das führte zu einer neuen Sicht auf die Entwicklung seit dem Mittelalter. Der Wirtschaftshistoriker Douglass C. North, der 1993 den Nobelpreis bekam, arbeitete über viele Jahrzehnte heraus, wie wichtig Institutionen für die wirtschaftliche und damit für die allgemeine Entwicklung sind. Dabei verstand North unter Institutionen sehr allgemein „die Spielregeln in einer Gesellschaft“. Als wesentliche Charakteristik der neuen Spielregeln, die seit dem 19. Jahrhundert zu immer schnelleren technischen und gesellschaftlichen Veränderungen führten, sieht man heute die immer engere Verbindung von wissenschaftlicher Erkenntnis und technisch-industrieller Entwicklung.

Anstatt von industriellen oder gar technischen Revolutionen spricht man inzwischen lieber von einer Neuen Wirtschaftsweise. Douglas C. North stellte der ersten wirtschaftlichen Revolution, bei der im Übergang von Jäger- und Sammlergesellschaften zur Landwirtschaft das Eigentum eingeführt wurde, die „zweite wirtschaftliche Revolution“ gegenüber, bei der wissenschaftliche Erkenntnis und wirtschaftliche Entwicklung eine enge Verbindung eingehen. Die Historikerin Margaret C. Jacob zeigte 1996 in einer vergleichenden Untersuchung wie stark die wissenschaftlichen Erkenntnisse von Kopernikus bis Newton in England auch im Handwerkermilieu rezipiert wurden und ganz konkret die Entwicklung der technischen Vorläufer der Dampfmaschine prägten. Sie stellte fest: Aus kultureller Sicht war die industrielle Revolution schon 1815 abgeschlossen. Dabei spielten die (relativ) demokratischen Interaktionsmuster in der englischen Gesellschaft eine entscheidende Rolle — im Gegensatz zu Frankreich, wo die absolutistische Regierungsform vor der französischen Revolution eine Kommunikation zwischen Ingenieuren der Armee und zivilen Initiativen weitgehend verhinderte.

Mit dieser seit den Siebzigerjahren aufkommenden Betrachtungsweise rückt ins Blickfeld, dass schon im neunzehnten Jahrhundert „immaterielle Produktion“ gegenüber „materieller Produktion“ an Bedeutung gewannen immer weiter gewinnt. Wissenschaftliche Erkenntnis, technische Innovationen, die Entwicklung eines förderlichen institutionellen Rahmens, der Aufbau entsprechender Dienstleistungsstrukturen und schließlich die Entwicklung von Software, die das alles unterstützen kann. Trotz einer schon lange währenden Diskussion über die Dienstleistungsgesellschaft und die Bedeutung von Innovationen fangen wir erst langsam an, zu begreifen, was das bedeutet. Zumal die materiellen Bedingungen unseres Lebensstils uns mit der ökologischen Krise wieder deutlicher ins Bewusstsein kommen. Die Rollen von Materie, Energie und Information verschieben sich.

Bemerkenswert ist, dass Dampfkraft und Elektrizität die Herausbildung unsere staatlichen Strukturen fast seit den Anfängen der modernen Staaten mit geprägt haben. 1830, zur Zeit der Entdeckung der elektromagnetischen Wechselwirkung, gärte es in Europa. In Frankreich verjagte die Juli-Revolution den letzten Bourbonen-König und etablierte ein bürgerliches Regime, das die Eroberung Algeriens fortsetzte. Die Polen revoltierten erfolglos gegen Russland, viele Emigranten, darunter Chopin, fanden Zuflucht in Paris. Die Belgier setzten gegen die Niederlande die Gründung eines eigenen Staates durch. Die auch als Reaktion auf die beginnende Industrialisierung entstandene Romantik gewann an Einfluss. 1832 ging mit dem Tod Goethes eine kulturelle Epoche zu Ende. 1837 bestieg Königin Viktoria den britischen Thron. Mit zunehmend aggressivem Kolonialismus expandierten die großen Imperien.

Nicht zuletzt die Nutzung der Kohle hat die Welt im Laufe des 19. Jahrhunderts grundlegend verändert und zu einer massiven Machtverschiebung geführt. Noch 1780 waren alle Länder im Wesentlichen auf Brennholz und Muskelkraft angewiesen. Im Jahr 1900 wurde weltweit noch etwas mehr traditionelle Biomasse als Kohle verbraucht. Aber 97% der Kohle wurde in Europa und Nordamerika produziert, 34% in den USA und 29% in Großbritannien (Öl, Erdgas und Wasserkraft machten zusammen im Vergleich zur Kohle nur fünf Prozent aus). Das hatte wirtschaftliche Folgen: Zwischen 1820 und 1900 stieg der Anteil der USA an der weltweiten Wirtschaftsleistung von 2% auf 17% (Großbritannien 6%→9%, Deutschland 3%→8%).

Bis heute unterschätzt: Wasser- und Wärmekraftwerke zwangen zur Zentralisierung

Seit den 1890er Jahren sind die Prinzipien und Technologien auf der elektrischen Seite der Stromversorgungssysteme bis vor wenigen Jahren im Wesentlichen die gleichen geblieben — gut hundert Jahre lang.

Aber bei der Antriebsenergie der Generatoren gab es technische Entwicklungen, die die Herausbildung der Stromsysteme wesentlich prägten.

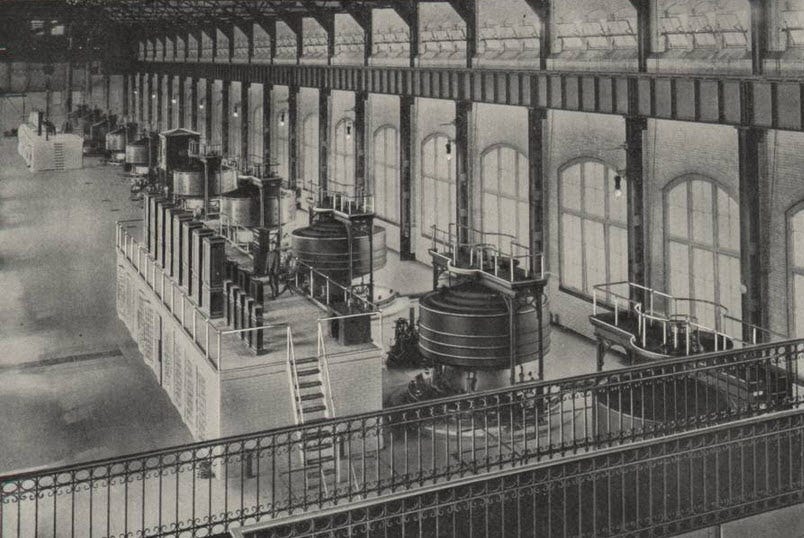

Die ersten Kraftwerke wurden mit Dampfmaschinen angetrieben. Nachdem mit Drehstrom größere Entfernungen überwunden werden konnten, führte die Erfindung effizienter Wasserturbinen ab 1890 zu einer relativ schnellen Entwicklung von Wasserkraftwerken. Vor allem in Kalifornien, in den Alpen, in Skandinavien, in Japan — aber wo keine Berge oder große Flüsse waren, blieb man auf Wärmekraftwerke angewiesen.

Bald setzte sich die Dampfturbine gegen die mit ihren Kolben und Getrieben aufwändige und anfällige Dampfmaschine durch. Der einströmende Dampf treibt hier Schaufelräder an, die auf einer rotierenden Welle sitzen. Diese kann ohne Getriebe direkt mit dem Generator verbunden werden. Bis heute wird weltweit der größte Teil der Elektrizität mit Dampfturbinen hergestellt. Dazu muss zunächst mit einer Wärmequelle Dampf erzeugt werden — ob durch Verbrennung von Kohle, Erdöl oder Erdgas, durch die Erhitzung von Wasser in Atomreaktoren, oder durch die Konzentration von Sonnenstrahlen mit Spiegeln.

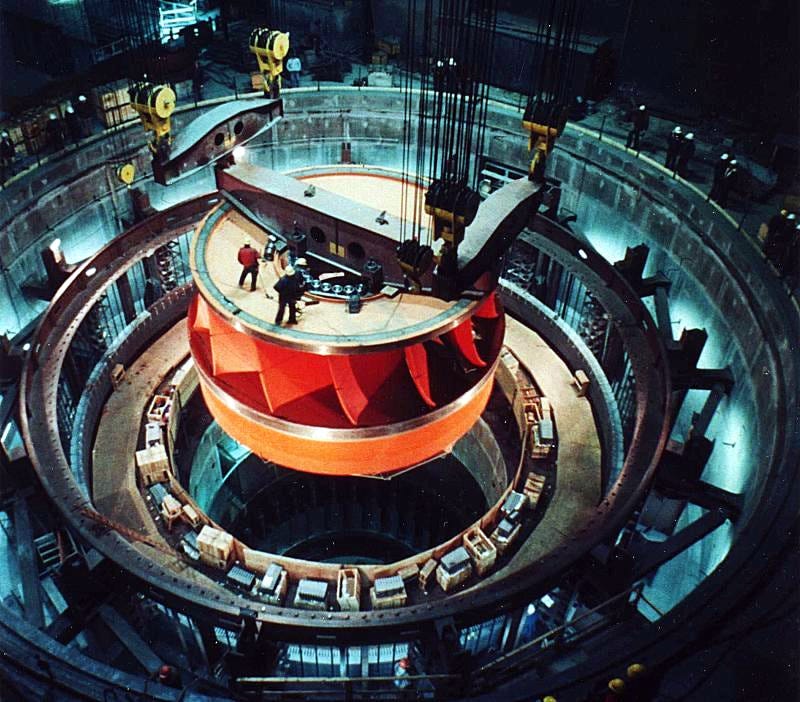

Ein erheblicher technischer und institutioneller Entwicklungsdruck ging davon aus, dass die Effizienz sowohl von Wasserkraftwerken als auch von Wärmekraftwerken mit ihrer Größe steigt. Das ist physikalisch bedingt.

Bei Wasserkraftwerken wirkt sich aus, dass der Rohrwiderstand für durchfließendes Wasser mit dem Durchmesser der Leitungen drastisch abnimmt: Bei einer Verdoppelung des Rohrdurchmessers sinkt der Widerstandswert des Rohres auf ein Sechzehntel! (Die Bremswirkung der Rohrwand nimmt mit dem Abstand von ihr ab. Bei turbulenter Strömung ist der Effekt sogar noch stärker.) Verdoppelt man hingegen den Durchmesser eines massiven Kupferkabels, so sinkt der elektrische Widerstand für Gleichstrom nur auf ein Viertel (proportional zum Querschnitt). Beim Wechselstrom sinkt der Widerstand sogar noch weniger, weil der Strom wegen der magnetischen Wechselfelder nur an der Oberfläche des Leiters fließen kann (deshalb verwendet man für Wechselstrom Kabel, die aus dünnen Litzen bestehen).

Bei Wärmekraftwerken gibt es gleich mehrere physikalische Gründe, warum größere Maschinen effizienter sind als kleine. Grundsätzlich ist der Wirkungsgrad von Wärme-Kraft-Maschinen — also der Umwandlung von thermischer in mechanische Energie — durch die genutzte Temperaturdifferenz begrenzt. Bei sehr heißem Dampf und Wasserkühlung beträgt sie weniger als 50%. Die Tatsache, dass die Oberfläche im Verhältnis zum Volumen bei größeren Einheiten abnimmt, hat mehrfache Folgen für den Wirkungsgrad: Die Wärmeverluste durch Wärmeabstrahlung sind kleiner; der Strömungswiderstand und die Reibungsverluste sind geringer; die längeren Turbinenblätter können die Energie des Dampfes besser aufnehmen; die robustere Konstruktion erlaubt höhere Dampfdrucke. Um das alles möglichst vollständig zu nutzen, mussten raffinierte mehrstufige Turbinen und neuartige Materialien entwickelt werden. Auch mit heutiger Ingenieurskunst sind die Wirkungsgrade von Dampfturbinen stark größenabhängig: 10 kW: 2%; 1 MW: 22%; 100 MW: 43%. Weil sie niedrigere Temperaturen als Kohlekraftwerke liefern, schaffen auch große Kernkraftwerke mit 1300 MW nur 35%. Ab den 1970er Jahren waren die Steigerungsmöglichkeiten bei der Dampfturbine weitgehend ausgereizt. Nur mit Gasturbinen ließen sich dank höherer Temperaturen noch Effizienzsteigerungen bis 60% erreichen.

Der erste Weltkrieg veranlasst die Politik, noch größere, effizientere Strukturen durchzusetzen

Die Beziehungen zwischen Institutionen und technisch-industrieller Entwicklung sind komplex. Von der früher dominierenden Vorstellung von Entwicklungsstufen hat man Abschied genommen. Aber weder die gesellschaftliche noch die technische Entwicklung verlaufen kontinuierlich. Disruptive Ereignisse können institutionelle Barrieren plötzlich überwindbar machen. So war das Wachstum von Kraftwerken und Stromversorgungsnetzen vor dem ersten Weltkrieg in Deutschland und den USA am weitesten fortgeschritten, konnte aber sein Potential angesichts des großen Kapitalbedarfs mit privaten Strukturen nicht voll nutzen. Das veränderte sich mit dem ersten Weltkrieg: die Staaten griffen ein und setzten größere, effizientere Strukturen durch, um die Rüstungsindustrie zu versorgen.

Für Deutschland wurde es im ersten Weltkrieg unmöglich, weiterhin Salpeter aus Südamerika zu importieren, was zu Engpässen nicht nur bei der Herstellung von Düngemitteln für die Landwirtschaft, sondern auch von Sprengstoff und Munition für die Rüstungsindustrie führte. Daraufhin finanzierte die Reichsregierung in Piesteritz eine riesige Ammoniakfabrik nach dem heute noch verwendeten Haber-Bosch-Verfahren, für deren Versorgung in nur 9 Monaten ein 180-Megawatt-Braunkohle-Kraftwerk gebaut wurde. Mit einer 110kV-Leitung nach Berlin wurde das Kraftwerk nach dem Krieg zum Ausgangspunkt eines großräumigen staatlichen Stromversorgungsnetzes.

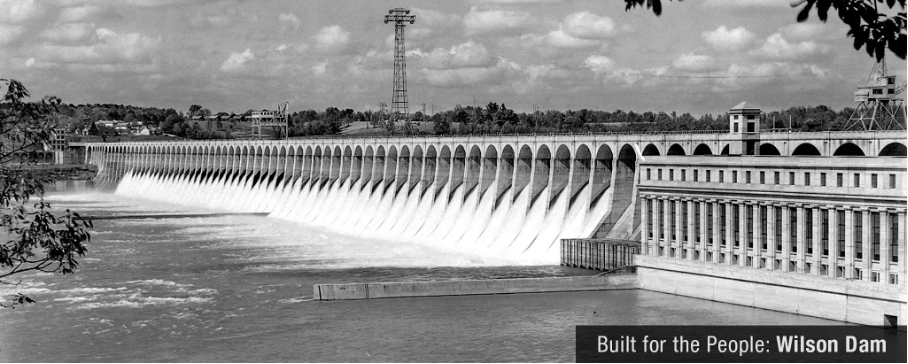

Ebenfalls um die Stickstoffversorgung für den Kriegsbedarf zu sichern, investierte die US-Regierung über 100 Millionen Dollar in eine Ammoniakfabrik (nach dem Cyanamid-Verfahren) und ein großes Flusskraftwerk am Tennessee (Wilson Dam). Nach dem Krieg wurde es zunächst kaum genutzt. Der visionäre Industrielle Henry Ford wollte es zum Ausgangspunkt eines großen Elektrifizierungsprojekts machen, das jedoch abgelehnt wurde. Erst 1933 griff Präsident Franklin Roosevelt mit der Schaffung der Tennessee Valley Authority (TVA) Fords Idee der regionalen Entwicklung durch Elektrifizierung auf und machte das Kraftwerk zum Ausgangspunkt des ambitioniertesten Projektes seines „New Deal“. Erst nach mehrjährigen Prozessen setzte sich die bundesstaatliche TVA gegen den hartnäckigen Widerstand der privaten Stromversorger durch.

In England war im Krieg die Schwäche der 600 unterschiedlichen Stromsysteme allzu offensichtlich geworden. Mit dem Electricity Supply Act von 1919 wurde eine Vereinheitlichung und Zentralisierung eingeleitet: Vier regionale Joint Electricity Authorities übernahmen weitgehend die großen Kraftwerke, 1926 wurde das Central Electricity Board gegründet, das bis 1938 mit dem National Grid das erste synchronisierte englische Übertragungsnetz aufbaute. 1947 wurde die britische Stromversorgung vollständig verstaatlicht.

Auch in Frankreich dominierten bis zum ersten Weltkrieg kleine, private Elektrizitätsunternehmen und entwickelten sich relativ langsam: Während der jährliche Stromkonsum 1913 in den USA bei 121 kWh pro Kopf lag, betrug er in Frankreich nur 30. Der Verlust von zwei Dritteln der Kohlenproduktion am Anfang des Krieges führte zu einer verstärkten Aufmerksamkeit für die Vorteile der Elektrizität, zu einem entschlossenen Ausbau der Wasserkraft in ganz unterschiedliche Klimazonen und dem Aufbau eines Leitungsnetzes für den Energietransport. Der Staat stellte Kredite zur Verfügung, koordinierte die Planung und nahm private Unternehmungen in die Pflicht. Die Kapazität der Wasserkraftwerke wurde innerhalb von fünf Jahren verdoppelt. Von 1910 bis 1938 stieg der Anteil der Wasserkraft an der Stromproduktion von 30% auf 55%. Angetrieben von einer neuen Generation von Managern, die vielfach aus dem Staatsdienst kamen, wuchsen die kleinen Versorgungsunternehmen in der Zwischenkriegszeit zu immer größeren Regionalversorgern heran. Die immer größeren Kraftwerke und Transportleitungen wurden häufig mit staatlicher Beteiligung errichtet. Der wachsende Staatseinfluss führte dann 1945 konsequent zur Verstaatlichung fast der gesamten Elektrizitätsindustrie unter dem Dach der EdF.

So sind seit den Anfängen der Stromnutzung, also seit bald zweihundert Jahren, die Technik und die gesellschaftlichen Institutionen in gegenseitiger Beeinflussung gewachsen: die wissenschaftlichen Erkenntnisse, die technischen Infrastrukturen, die privaten Unternehmen, der rechtliche Rahmen, die staatliche Energiepolitik, die industrielle und private Stromnutzung. Die Ko-Evolution von Technik und Institutionen führte in verschiedenen Ländern immer wieder zu verschiedenen Ergebnissen. Aber der internationale Austausch wurde gleichzeitig immer intensiver, so dass die wissenschaftlich-technischen Voraussetzungen überall ähnlich blieben.

In der nächsten Folge werden wir sehen, wie sich die großen monopolistischen Stromversorger auch nach dem zweiten Weltkrieg noch lange halten konnten. Ab den 1970er Jahren gerieten sie zunehmend in eine Legitimationskrise. Die Liberalisierung der Strommärkte um die Jahrtausendwende und der darauf folgende Umbau der Versorgungsindustrie waren aber erst der Anfang eines Transformationsprozesses, in dem neue Technologien die Steuerungs- und Wachstumslogik des in bald zweihundert Jahren gewachsenen Stromsystems fundamental in Frage stellen. Angesichts der in dieser Folge dargestellten engen Verknüpfung der Entwicklungslogiken des Stromsystem und unserer Industriegesellschaften ist es nicht verwunderlich, dass Änderungen — so logisch sie technisch, ökonomisch und ökologisch gesehen auch sein mögen — auf massive Widerstände derer stoßen, die mit dem bisherigen System gut gelebt haben. Nicht nur finanzielle Interessen, politischer Einfluss und pure Bequemlichkeit stehen auf dem Spiel. Photovoltaik, Leistungselektronik und der Klimawandel stellen lange gewachsene Organisationsstrukturen, Besitzverhältnisse, Entscheidungsmechanismen und Denkmuster in Frage, die unsere demokratischen Governance-Strukturen seit ihrem Entstehen begleitet haben.