Umbau des Stromsystems seit 50 Jahren – Von der Zentrale zum Netzwerk

Geschichte der Energietechnik (13) – Die Entdeckung der Nanowelten ermöglicht eine erneuerbare Energieversorgung für Alle

In der vorigen Folge dieser Serie ging es um die lange Entstehungsgeschichte des Stromsystems bis zum zweiten Weltkrieg. Darin wurde deutlich, wie stark die Wärme- und Wasserkraftwerke mit ihrer Tendenz zu immer größeren Einheiten unsere Institutionen geprägt haben. In den Aufbaujahren nach 1945 ging es zunächst so weiter und auch die Kernenergie passte in das alte Schema. Aber ab den 1970er Jahren begannen sich die technischen, wirtschaftlichen und gesellschaftlichen Rahmenbedingungen des Stromsystems zu ändern. Zuerst brach die Wärme-Kraft-Kopplung die alten Monopolstrukturen auf und führte zur Liberalisierung der Strommärkte. Dann fing der immer schneller steigende Anteil “systemwidriger” dezentraler und fluktuierender Stromerzeugung mit Windkraft und Photovoltaik das System unter Druck zu setzen. Er konnte bisher mit einem widersprüchlichen Patchwork aus Zusatzregeln und neuen Netztechnologien bewältigt werden. Die Beharrungskräfte des alten Systems versuchen die zentralistische Steuerungslogik zu retten. Das verzögert den notwendigen Wandel. Eine neue Steuerungslogik ist unvermeidlich…

Artikelserie zur Technikgeschichte:

Die Entdeckung der Nanowelten ermöglicht eine erneuerbare Energieversorgung für Alle

Die bisherigen Folgen:

Kernspaltung: Frühe, verführerische Frucht einer wissenschaftlichen Revolution

Wo die sinnliche Erfahrung versagt: Neue Methoden erlauben die Entdeckung von Nano-Welten

Virtuelle Welten auf Siliziumbasis: Nanowissenschaften revolutionieren die Informationstechnik

Die Entzauberung des biologischen Informationssystems – kein dauerhafter Beitrag zur Energietechnik

Die Geschichte der fossilen Energieversorgung, Grundlage der Industrialisierung

Die Klimakrise stellt die industrielle Zivilisation in Frage: Welche Optionen haben wir?

Dank Nanowissenschaften: Strom direkt aus Sonnenlicht wird unschlagbar günstig

PV: Zunehmende Kostenvorteile durch nanotechnische Dematerialisierung

Big was beautiful — Wie die Dampfkraft unsere Institutionen geprägt hat

Kontinuität nach dem zweiten Weltkrieg

Der zweite Weltkrieg brachte keine grundlegenden Änderungen in den Stromsystemen – außer Ausbauten für die Rüstungsindustrien und erhebliche Zerstörungen.

Wie wir in der zweiten Folge dieser Serie gesehen haben, setzten Ende der vierziger Jahre die Bemühungen ein, die Energie der gerade entwickelten Atombomben für zivile Zwecke nutzbar zu machen. Dafür wurde die Wärme aus Kernreaktoren mit Turbinen und Generatoren in Strom umgewandelt. Eine immer wieder erwogene Nutzung der Wärme für industrielle oder Heizungszwecke scheiterte daran, dass die Kernkraftwerke aus Effizienzgründen möglichst groß sein mussten (bis zu dreimal so groß wie übliche Kohlekraftwerke) und aus Sicherheitsgründen nicht in dicht besiedelten Gegenden gebaut werden konnten.

Im Vergleich zu fossil beheizten thermischen Kraftwerken führten zwei Eigenschaften von Kernkraftwerken zu einer weiteren Zentralisierung der Stromsysteme: erstens ihre Größe und zweitens die Notwendigkeit, sie mit relativ konstanter Leistung zu betreiben. Die geringere Regelbarkeit rührt vor allem daher, dass Temperaturänderungen Materialermüdungen zur Folge haben – und die will man in nuklearen Anlagen wegen der Sicherheitsrisiken und wegen des hohen Zeit- und Kostenaufwands für Arbeiten an radioaktiv belasteten Anlagenteilen möglichst vermeiden. Wegen des geringen Kostenanteils der Brennstoffe wird zudem eine hohe Auslastung angestrebt. Das Ausfallrisiko der großen Einheiten und ihre Unflexibilität konnten im Endeffekt nur mit größeren Verbundsystemen aufgefangen werden. Ansonsten hatte die Kernkraft keine grundlegenden Auswirkungen auf das Stromsystem. Ohnehin war ihr Beitrag zunächst noch sehr gering: 1973 betrug Ihr Anteil an der weltweiten Primärenergie erst 0,76%. Bis 1978 — als die Kernschmelze in Harrisburg zu einem Ende der Kraftwerksbestellungen führte — stieg ihr Anteil auf 2,07%.

Auch die Anwendungsbereiche der Elektrizität blieben zunächst weitgehend die Gleichen. Bei den stark zunehmenden Straßenfahrzeugen dominierten nach wie vor Erdölprodukte. Die Elektrifizierung der Eisenbahn machte langsame Fortschritte. Dampflokomotiven wurden vielfach durch Diesellokomotiven ersetzt. In der Wärmeerzeugung für Gebäude und Industrie dominierte zunächst noch die Kohle. In der Gebäudeheizung wurden zunehmend Einzelöfen durch Zentralheizungen ersetzt. Dann gewann Erdöl als Brennstoff an Boden. Aus Kohle gewonnenes Stadtgas war für die Beleuchtung schon lange weitgehend durch Strom ersetzt worden, hielt sich aber, wo es auf eine relativ saubere und kleinteilige Wärmeerzeugung ankam: in der Küche, in Industrie und Handwerk, für die Warmwassererzeugung. Erdgas kam (siehe Folge 8) erst langsam ab den Fünfzigern in den USA und ab den Sechzigern in Europa auf. Gegenüber der direkten Verfeuerung fossiler Brennstoffe war Elektrizität für die Wärmeerzeugung im Allgemeinen nach wie vor zu teuer, denn in den meisten Ländern wurde sie vorwiegend — mit unvermeidlichen Verlusten von etwa zwei Dritteln — in thermischen Kraftwerken aus ebensolchen fossilen Brennstoffen gewonnen.

In den USA bildete sich — nach Darstellung des amerikanischen Technikhistorikers Richard F. Hirsh — im ersten Jahrzehnt des zwanzigsten Jahrhunderts ein „Stromkonsens“ zwischen den Stromversorgern und der Politik heraus, der die Elektrizitätsversorgungsunternehmen als natürliche Monopole betrachtete, die von den Regulierungskommissionen in den einzelnen Bundesstaaten weitgehend in Ruhe gelassen wurden, solange sie den wachsenden Strombedarf mit immer niedrigeren Tarifen befriedigen konnten. Dank immer größerer Einheiten und effizienterer Technik konnten die Stromversorger die Erwartungen bis in die siebziger Jahre weitgehend erfüllen.

In Deutschland gab es seit dem Anfang des Jahrhunderts ein ähnliches System wie in den USA mit großen regionalen Versorgern, die jeweils ein Monopolgebiet bedienten. International beachtet wurde die ab 1920 gebaute Nord-Süd-Leitung des RWE, die einen idealen Ausgleich zwischen Wasserkraftwerken in den Alpen und Kohlekraftwerken im Ruhrgebiet ermöglichte. Allerdings spielten unterhalb dieser Ebene seit jeher kommunale Strukturen sowie eigene Kraftwerke der Industrie eine wichtige Rolle. Mit dem Energiewirtschaftsgesetz von 1936 schrieben die Nationalsozialisten diese Struktur fest - sie wollten vermeiden, dass allzu große Kraftwerke Deutschland militärisch verletzlicher machen könnten. Bis 1998 blieb das Gesetz weitgehend unverändert in Kraft.

In Frankreich verfügte die staatliche EdF über ein nach einheitlichen Grundsätzen durchgeplantes Monopol. In den Nachkriegsjahren wurden vor allem große Staudämme gebaut. Gedrängt durch das CEA (Commissariat à l’Energie Atomique), das auch für die Entwicklung von Atombomben zuständig ist, ließ sich die EdF dann auf die Kernenergie ein. Heute hat die Atomkraft mit 70% einen so hohen Anteil an der Stromerzeugung wie sonst in keinem anderen Land. Anfangs bildeten die gut regulierbaren Staudamm-Kraftwerke eine ideale Ergänzung zur kontinuierlichen Erzeugung in den Kernkraftwerken, später wurde zum Ausgleich auf elektrische Nachtspeicher-Heizungen gesetzt (heute 14% der Heizenergie elektrisch).

Auch in anderen Ländern blieb die Struktur der Elektrizitätsversorgung bis Anfang der siebziger Jahre weitgehend stabil — wobei sich meine Darstellung hier im Wesentlichen auf die westlichen Industrieländer beschränkt. Große Monopole, vom Staat wohlwollend überwacht, versorgten wachsende Gebiete mit bewährter Technik.

Ab den Siebzigern: Legitimationskrise

der Strom-Monopole

Anfang der siebziger Jahre aber änderten sich die technischen, gesellschaftlichen und politischen Rahmenbedingungen. Studentenunruhen und Streiks in den großen Industrien hatten angefangen, den gesellschaftlichen Konsens der Aufbaujahre nach dem Krieg zu erschüttern. Die Naturschutzbewegung, der Club of Rome, die erste Umweltkonferenz der Vereinten Nationen, die Anti-Atomkraft-Bewegung stellten immer eindringlicher die Frage, ob es mit dem Wachstum so weitergehen könne.

In den USA geriet dem Technikhistoriker Hirsh zufolge der von ihm beschriebene „Strom-Konsens“ in eine Legitimationskrise, weil die technische Effizienz sich nicht mehr weiter steigern ließ. Größere Kraftwerke schafften neue Probleme. Zu alledem kam dann die Energiekrise von 1973, die zu einer drastischen Verteuerung der fossilen Brennstoffe führte (siehe Folge 8 dieser Serie). Das hatte plötzlich steigende Strompreise und gesellschaftliche Kritik sowohl am Stromsystem als auch am verschwenderischen Umgang mit Strom zur Folge, an dem die Elektrizitätsgesellschaften nicht ganz unschuldig waren. Die Legitimationskrise der Strom-Monopole war Teil einer grundlegenderen Legitimationskrise des industriellen Wachstumsmodells und der Dominanz der Industriestaaten. Sehr beunruhigt durch die Energiekrise, brachte der demokratische Präsident Jimmy Carter nach langen Verhandlungen 1978 ein umfangreiches Gesetzespaket durchs Parlament, das einen sparsameren Umgang mit Energie und einen vermehrten Einsatz nationaler Ressourcen bringen sollte.

Von Spezialisten aus der Umweltbewegung und akademischen Forschern waren immer stärker neue Planungsmethoden wie Least Cost Planning (LCP), Integriertes Ressourcen-Management (Integrated Resource Management IRM) und verbrauchsseitige Steuerung (Demand Side Management DSM) eingefordert worden. „Energy Strategy: The Road not Taken“ hieß ein legendär gewordener Aufsatz von Amory Lovins in Foreign Affairs 1976 . Die Regulierungskommissionen in den US-Bundesstaaten, die schon immer für die Beaufsichtigung der Elektrizitätswirtschaft zuständig waren, wurden aktiver und zeitweise sah es nach einem neuen Konsens für ein Systemmanagement aus, in dem Versorger und Regulierer enger kooperieren.

Dann aber, Anfang der achtziger Jahre (siehe Folge 10), als sich die Energiekrise entspannte und billiges Fracking-Gas verfügbar wurde, begann man unter Präsident Reagan verstärkt auf Marktkräfte zu setzen und die Elektrizitätsmärkte zu deregulieren. Die Entwicklung in den verschiedenen Bundesstaaten war und ist uneinheitlich.

In Westeuropa verlief die Entwicklung ähnlich. Insbesondere in Deutschland, den Niederlanden, Skandinavien und Italien stellte eine wachsende Umwelt- und Anti-Atom-Bewegung ähnliche Fragen. Von ihr gingen auch wesentliche Impulse für die angewandte Forschung aus. Insbesondere aus den Ländern, wo die Bewegung stark war, kommen bis heute viele fundierte Entwürfe und Szenarien für eine nachhaltige Energiepolitik.

Trotz recht unterschiedlicher Ausgangssituationen und Interessenlagen in den Ländern Europas gewann die Europäische Union zunehmend Einfluss auf die Stromsysteme der Mitgliedsländer. Obwohl die Energiepolitik seit den Anfängen der EU mit der Gemeinschaft für Kohle und Stahl und EURATOM eine zentrale Rolle im europäischen Einigungsprozess spielte, liegt die Zuständigkeit für die Energiepolitik vor allem bei den Mitgliedsländern.

In Osteuropa verschärfte sich die Energieknappheit in den achtziger Jahren zu einer veritablen Energiekrise. Die Sowjetunion hatte seit den Siebzigern zunehmend Schwierigkeiten, den steigenden Energiedarf der energiearmen Mitgliedsländer des COMECON zu decken, den sie seit Anfang der sechziger Jahre mit subventionierten Lieferungen befriedigt, und damit den Zusammenhalt des Blocks gefestigt hatte. Die Finanzierung gemeinsamer Gas-Pipelines wurde immer problematischer. 1969 griff Kossygin die schon ältere Idee für ein gemeinsames Comecon-Elektrizitäts-System wieder auf. 1976 wurde im Comecon-Rat ein Plan beschlossen, der ein weitgespanntes 750kV-Hochspannungs-Netz und eine Reihe neuer Kraftwerke vorsah — nicht nur Kernkraftwerke wie ursprünglich vorgesehen. Auch die Realisierung des Elektrizitätsplans verzögerte sich erheblich (wobei der Tschernobyl-Unfall 1986 nur eine untergeordnete Rolle spielte). Zurückgehende Energielieferungen aus der Sowjetunion trugen wesentlich zum ökonomischen Niedergang, zur zunehmenden Desintegration und schließlich 1991 zum Zusammenbruch des Comecon bei.

Wie die Kraft-Wärme-Kopplung die Monopole sprengte

Weitgehend unbemerkt, aber sehr folgenreich war eine Regelung in Präsident Carters Energiegesetz, die es unabhängigen Stromproduzenten ermöglichte, Elektrizität an die Monopolunternehmen zu verkaufen. Sie wurde in den nachfolgenden Liberalisierungsschüben, die in den Bundesstaaten unterschiedlich ausgestaltet wurden, beibehalten.

Ausgangspunkt für die neuen Konkurrenten waren die riesigen, ungenutzten Abwärmemengen in den thermischen Kraftwerken.

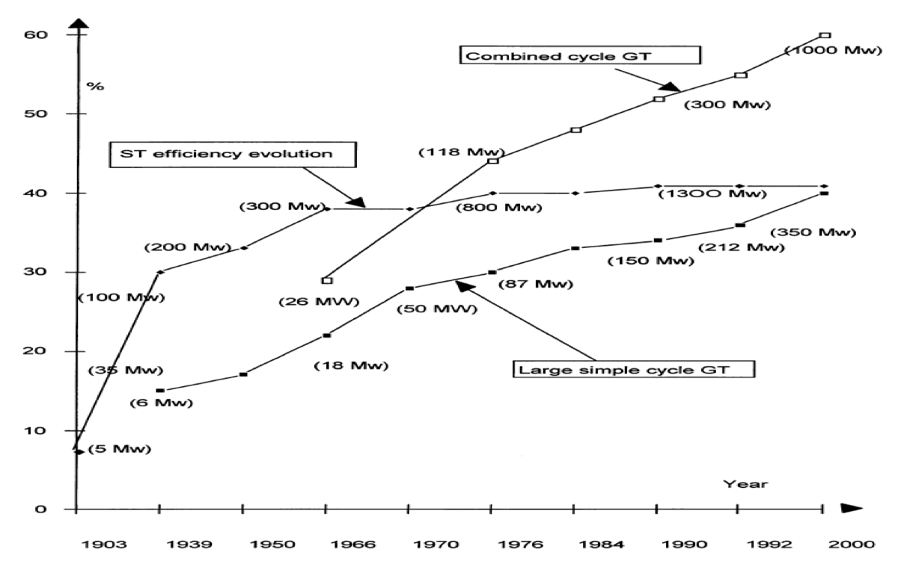

Es zeigte sich, dass kleine Kraft-Wärme-Kopplungs-Anlagen, die primär Wärme für die Industrie erzeugten, insbesondere seit dem Aufkommen effizienter kleiner Gasturbinen billigeren Strom liefern konnten als die herkömmlichen Großkraftwerke. Denn sie nutzten sowohl den Strom als auch die Abwärme, die bei Großkraftwerken nutzlos in die Umwelt abgegeben wurde. Erdgas war in zunehmenden Mengen billig verfügbar, es verbrannte relativ sauber und konnte mit sehr heißen Verbrennungsabgasen direkt Turbinen bei höheren Temperaturen antreiben als der Dampf aus Kohlekesseln. Die gleichen Firmen, die seit dem Weltkrieg den Düsenantrieb für Flugzeuge weiterentwickelt hatten, nutzten ihre Kenntnisse für die Entwicklung von Gasturbinen. Auch erste, noch recht ineffiziente Windkraftwerke wurden zunehmend interessant. Das unterminierte die Monopolstellung der alten Player.

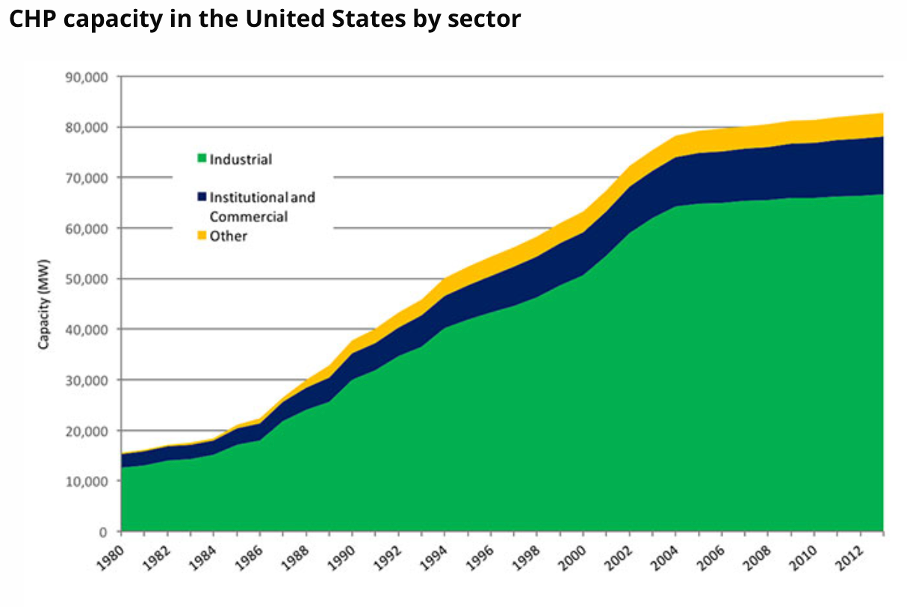

Die Nutzung der Abwärme aus Kraftwerken ist im Grunde eine uralte Technik. Schon Edison lieferte aus seinem ersten Elektrizitätswerk in New York heißen Dampf. Das wurde mit den aufkommenden Großkraftwerken dann aber schwierig. Auch im nach 1980 einsetzenden Boom der „co-generation“ wurde die Wärme in den USA vor allem für industrielle Zwecke und nicht zum Heizen genutzt. Das war in Europa anders.

Der entschiedenste Vorreiter bei der Entwicklung der Kraft-Wärme-Kopplung (KWK) war Dänemark. Insbesondere in Nordeuropa wurden schon seit den dreißiger Jahren Fernheizsysteme gebaut, die mit Wärme aus Heizkraftwerken gespeist wurden. Ihr Anteil an der Stromproduktion blieb jedoch gering. Mit der Ölkrise und der Kritik der Umweltbewegung am ineffizienten Einsatz fossiler Brennstoffe nahm das Interesse an der kombinierten Nutzung zu und neue Techniken wurden entwickelt. Aufbauend auf den Erfahrungen mit Fernheizsystemen wurde nach der Ölkrise in Dänemark eine flächendeckende Wärmeplanung eingeführt, mit der städtische Gebiete konsequent an Fernheiznetze mit größeren Heizkraftwerken angeschlossen wurden. In einer zweiten Phase wurden ab Mitte der achtziger Jahre in weniger dicht besiedelten Gegenden Nahwärmenetze gebaut, die von den inzwischen entwickelten kleineren KWK-Anlagen gespeist wurden: kompakten, in Serie gefertigten Kleinkraftwerken mit Gasturbinen – auch Blockheizkraftwerke genannt. Die oft genossenschaftliche Organisationsform der Nahwärmenetze führte zu einer optimalen Betriebsführung: um eine kostensparende Absenkung der Vorlauftemperatur zu ermöglichen, achteten die Mitglieder auf eine verbesserte Wärmedämmung der Gebäude. Die Fernwärme-Kosten sind je nach Versorgungsgebiet unterschiedlich, im Durchschnitt liegen sie weit unter den Fernwärme-Kosten in Deutschland. Erst in einer dritten Phase spielte die Wärme-Kraft-Kopplung in der Industrie eine größere Rolle – Dänemark hat kaum energieintensive Industriebetriebe. 1999 kamen in Dänemark bereits über 50% der Stromproduktion aus der Kraft-Wärme-Kopplung. Entscheidend für diese Entwicklung war eine aufmerksame, laufend verbesserte staatliche Regulierung. Nach der Ölkrise war sie zunächst darauf ausgerichtet, die Abhängigkeit von Öl- und Gasimporten zu vermeiden – nach einigen Jahren konnte man den Bedarf mit der eigenen Öl- und Gasförderung decken. In den Achtzigern überwog dann das Bestreben, klimaschädliche Emissionen zu vermeiden. Zunehmend wurden dann – viel früher als anderswo – Biomasse, Solarthermie und Windstrom für die Wärmeerzeugung eingesetzt, was durch große Wärmespeicher erleichtert wird.

Auch in den Niederlanden, die eigene Gasvorkommen haben, trug das Aufkommen neuer Technologien für die Kraft-Wärme-Kopplung ganz entscheidend dazu bei, die Monopolstruktur der Elektrizitätswirtschaft aufzubrechen. Zunächst wurde die Gasturbinen-Technologien zunehmend von den traditionellen Stromproduzenten genutzt. Ab den Siebzigern fing die Industrie an, intern KWK-Anlagen einzusetzen. Als sich dann ab den späten Achtzigern die gesetzlichen Rahmenbedingungen änderten, fingen die Verteilnetzbetreiber an, mit der Industrie zu kooperieren und den traditionellen Kraftwerksmonopolen Konkurrenz zu machen. Sie waren in den Niederlanden ab 1989 die eigentlichen ‘change agents’, die die alte Versorgungsstruktur aufbrachen. 2007 betrug der KWK-Anteil an der Stromerzeugung knapp 30%.

In Deutschland gab es seit jeher Heizkraftwerke in der Industrie und in städtischen Fernwärmenetzen – der Anteil an der gesamten Stromerzeugung blieb jedoch lange gering. Mit dem Aufkommen neuer KWK-Technologien stieg das Interesse daran. Ab den Neunzigern wurde immer mehr über Blockheizkraftwerke und Nahwärmenetze diskutiert. Eine öffentliche Förderung gab es ab 2000. Mit ca. 12 % im Jahr 2007 lag der KWK-Anteil in Deutschland über dem internationalen Durchschnitt von etwa 9%, jedoch deutlich unter den Werten von Dänemark, Russland, Skandinavien — und etwa gleichauf mit China.

In Frankreich, das auf Kernkraft setzte, und im individualistischen Großbritannien spielten Fernheizungen keine und Kraft-Wärme-Kopplung nur eine geringe Rolle.

Erst nach der Jahrtausendwende, als die Dänen schon anfingen, fossile KWK durch Biomasse-KWK, Solarthermie und Windstrom zu ersetzen, begannen die EU und die Internationale Energie-Agentur, Kraft-Wärme-Kopplung mit Erdgas als Beitrag zur Reduktion von CO2-Emissionen zu propagieren.

Auf die Organisationsstruktur der Elektrizitätswirtschaft hatte das Aufkommen der Kraft-Wärme-Kopplung und kleiner, unabhängiger Stromproduzenten eine disruptive Wirkung. Konkurrenz wurde möglich. Man experimentierte mit Strommärkten. Es wurde deutlich, dass unterschiedliche Rollen auf diesen Märkten definiert werden mussten. Die alten Monopolunternehmen der Elektrizitätswirtschaft mussten ihre Strategien überdenken. Technische Innovation wurde zum Wettbewerbsvorteil. Aber das ging zunächst alles langsam. Für die Steuerungslogik der Stromnetze war die Wärme-Kraft-Kopplung noch keine große Herausforderung, denn sie konnten auf Fahrpläne verpflichtet und fest eingeplant werden. Die Steuerungs- und Ausgleichsfunktion der Großkraftwerke wurde nicht infrage gestellt, zumal verbesserte Kommunikationstechniken die zentrale Verwaltung von Fahrplänen vereinfachten.

Seit den Achtzigern: die Windkraft lässt ganz neue Anforderungen erahnen

Schon in den achtziger und neunziger Jahren, als man sich über die Liberalisierung der Strommärkte Gedanken machte, wurde allerdings absehbar, dass eine andere Stromerzeugungstechnik bald viel größere Herausforderungen an die Steuerungstechnik stellen würde: die Windkraft. Denn sie konnte nicht verpflichtet werden, sich an Fahrpläne zu halten.

Windkraft wurde schon seit dem Altertum genutzt. Vor allem für Mühlen und Pumpen. Elektrische Windkraftwerke zur Stromerzeugung waren den Wasser- und Dampfkraftwerken lange ökonomisch und technisch unterlegen. Aber Ende des 19. und Anfang des 20. Jahrhunderts wurden sie vor allem in Nord- und Südamerika in großen Stückzahlen in entlegenen Farmen eingesetzt, bis auch in ländlichen Regionen Stromnetze gebaut oder Dieselgeneratoren verfügbar wurden.

Seit der Ölkrise war das Interesse an dieser Energiequelle wieder erwacht und man versuchte, effizientere Anlagen zu bauen. Auch hier war Größe von Vorteil (siehe dazu auch Folge 12) — aber die Leistung der Windturbinen beträgt doch nur etwa ein Hundertstel der Leistung thermischer Kraftwerke. 1978 ging in Dänemark das erste moderne Windkraftwerk mit einer Leistung von 1MW in Betrieb. Ab 1991 wurde in Deutschland die Stromeinspeisung aus Windkraft mit festen Sätzen vergütet. 1995 stammten in der EU erst 0,15% der Stromerzeugung aus Windkraft (USA 0,09%). Im Jahr 2000 waren es schon 0,81% (USA: 0,15%, Welt: 0,21%). Und erstmals mussten Windkraftwerke, um die Netzfrequenz einzuhalten, nicht mehr mit gleichbleibender Drehzahl betrieben werden, sondern konnten dank elektronischer Umrichter (siehe nächste Folge dieser Serie) mit variabler Drehgeschwindigkeit der Rotoren die Energie des Windes wesentlich besser nutzen.

Erst am Anfang unseres Jahrtausends machte sich die Windkraft in der Steuerungslogik der Netze bemerkbar – mit Tausenden von Anlagen, die in die unteren Spannungsebenen der Netze schwer vorhersagbare Strommengen einspeisen: 2010 lieferte die Windenergie in Dänemark 20% der Stromproduktion (EU: 4,7%, DK 2022: 55%). Aber da war man institutionell schon einen ganzen Schritt weiter.

Die Liberalisierung der Strommärkte in Europa —Anfang des Umbaus von Märkten und Netzen

Seit den neunziger Jahren ist in Europa der weltweit größte liberalisierte Strommarkt geschaffen worden. Das Aufkommen von Gasturbinen, Kraft-Wärme-Kopplung und den ersten Windenergieanlagen, in Kombination mit der stärker werdenden Umweltbewegung einerseits und dem einflussreicher werdenden Neoliberalismus andererseits, führten in Europa ganz ähnlich wie in den USA dazu, dass in den achtziger Jahren die Monopolstellung der großen Kraftwerksbetreiber als immer unhaltbarer angesehen wurde. Inzwischen waren die westeuropäischen Strommärkte durch zunehmenden Stromaustausch immer mehr verflochten. Außerdem stand nach der Öffnung des Eisernen Vorhangs 1989 die Integration mittel- und osteuropäischer Länder in den europäischen Binnenmarkt an. Das führte ab Ende der Neunziger Jahre zu einer schrittweisen Liberalisierung der europäischen Strommärkte und der Einführung von nationalen und europäischen Aufsichtsbehörden.

Die konkrete Ausgestaltung der EU-Vorgaben für die neuen Strommärkte obliegt den Mitgliedsländern und hat sich unterschiedlich, jedoch nach weitgehend einheitlichen Regeln entwickelt. Grundsätzlich wurde das Monopol für die Stromproduktion aufgehoben, für die Netze auf den verschiedenen Spannungsebenen aber beibehalten.

Auch wenn die Liberalisierung der Strommärkte in Europa im Vergleich zum alten Monopol-System alternativen Stromanbietern und unabhängigen Stromhändlern neue Möglichkeiten bot, orientierte sie sich im Wesentlichen an der gewachsenen Struktur der konventionellen Stromversorgung. Und die über ein Jahrhundert gewachsenen Stromversorgungsunternehmen wehrten und wehren sich mit allen Kräften gegen Bedrohungen ihrer Dominanz. Das sogenannte „unbundling“ von wettbewerblichen Geschäften (Stromproduktion und -handel) und regulierter Wahrnehmung öffentlicher Aufgaben (Netzbetrieb) fürte zur Gründung separater Unternehmen, die jedoch oft unter einem gemeinsamen Konzerndach blieben. Der Durchbruch der Windenergie und der Photovoltaik kam daher auch nicht mit der Deregulierung, sondern mit staatlich garantierten Einspeisetarifen für kleine, innovative Stromerzeuger, die eigentlich dem liberalisierten Stromhandel und der zentral gesteuerten top-down-Verteilung zuwiderliefen.

Im Jahr 2000 war der Anteil von Wind- und Sonnenenergie an der Stromproduktion in der heutigen EU mit 0,8 % noch gering (Deutschland: 1,6%, Frankreich: 0,0%) und konnte mit der konventionellen Technik problemlos bewältigt werden. 2022 aber machten Wind- und Solarstrom in Dänemark 60% aus, in Spanien 33%, in den Niederlanden und Deutschland 32%, in Großbritannien 29%. In der gesamten EU waren es 22%, in Frankreich 17%.

Noch vor wenigen Jahren war für einen Anteil an fluktuierenden Erneuerbaren, der über 10 Prozent hinausging der Zusammenbruch der Systeme vorausgesagt worden. Tatsächlich war das Verkraften hoher Anteile flutuierender Einspeisung in einem Marktdesign und einem Netz, die eigentlich für regelbare Großkraftwerke, zentrale Steuerung und Verteilung von oben nach unten geschaffen wurden, nur mit vielfältigen Zusatzregeln, Ausgleichsmärkten, nachträglichen Korrekturen, viel neuartiger Technik, großem digitalen Aufwand und viel Unzufriedenheit zu schaffen.

Auf der technischen Seite waren erhebliche Anstrengungen für eine digitale Steuerung des Netzes erforderlich, auf die wir in der nächsten Folge näher eingehen werden. Nach rund hundert Jahren wurde es unumgänglich, die alte, elektromechanische, auf einfache Verteilungsströme ausgerichtete Technik nach und nach zu ergänzen. Noch ist man aber weit davon, sie zu ersetzen und das Potential der neuen Technologien wirklich zu nutzen. Auch die Marktmechanismen und die administrative Nachsteuerung blieben im Kern die gleichen. Aber mit der Einbindung von Millionen PV-Anlagen, Windkraftwerken, Ladestationen und Wärmepumpen hat die administrativ zu bewältigende Komplexität massiv zugenommen, während die zentral steuerbaren Großkraftwerke wegfielen. Deshalb werden die Steuerungskapazitäten auf den unteren und mittleren Netzebenen ausgebaut, was auch eine Verschiebung von Verantwortungen zur Folge hat, die nicht ohne Konflikte zwischen Unternehmen und Institutionen auf verschiedenen Ebenen abgeht. Als Moderator eines nationalen Verteilnetz-Dialogs in Deutschland habe ich direkt erfahren, wie intensiv die in diesem Transformationsprozess aufkommenden Spannungen sind.

Die neuen Aufsichtsbehörden, die Politik und die Öffentlichkeit, aber auch die Techniker in den Versorgungsunternehmen lernen erst langsam, wie sehr die neuen Energiequellen die alten Strukturen in Frage stellen. Das ganze Elektrizitäts-System ist im Umbau, und muss trotzdem jede Sekunde zuverlässig funktionieren, während sich hinter den Kulissen unerbittliche Machtkämpfe abspielen.

Ungereimtheiten in einer veralteten Marktordnung

Ein immer schwerer wiegendes Problem der geltenden Marktordnung ist das weitgehende Ignorieren der räumlichen Dimension. Um trotz der nach wie vor in Monopolen organisierten Netze einen liberalisierten Stromhandel zu organisieren, wird der Strom innerhalb von räumlich abgegrenzten „Gebotszonen“ (Marktgebieten) ganz unabhängig von den konkreten Leitungskapazitäten an Strombörsen nach einheitlichen Regeln gehandelt. Innerhalb einer Gebotszone ist der Großhandelspreis überall gleich. Man tut so, wie wenn alle Punkte des Gebiets durch eine Kupferplatte verbunden wären. Netzengpässe kommen im europäischen Strommarkt nur beim Handel zwischen den Gebotszonen zum Tragen, und sorgen da auch für deutliche Preisunterschiede. Erst nach den Handelsabschlüssen greifen die Übertragungsnetzbetreiber — die Akteure auf der höchsten Spannungsebene — falls nötig in die durch den Handel entstehenden Erzeugungs-Fahrpläne ein, um sie administrativ den Leitungskapazitäten anzupassen (Redispatch).

Am Anfang waren solche administrativen Eingriffe selten nötig, denn die alten Monopolunternehmen hatten ihre Kraftwerke und Netze gut aufeinander abgestimmt. Inzwischen aber haben sich — wegen des schwer überschaubaren Nebeneinanders von Marktsignalen an den Strombörsen, Fördermaßnahmen für den Ausbau der Erneuerbaren und der Regulierung des monopolistischen Netzausbaus durch die Aufsichtsbehörden — die geographischen Muster der Erzeugung, des Verbrauchs und der Netzkapazitäten auseinander entwickelt. Deshalb entstehen durch den Redispatch immer höhere Mehrkosten, die auf alle Nutzer umgelegt werden.

Die Zahl der Gebotszonen ist in den EU-Mitgliedsländern sehr unterschiedlich: Deutschland hat nur eine, Schweden vier, Italien fünf. Würde Deutschland in zwei Marktgebiete aufgeteilt, wären die Strompreise im industriereichen Süden wesentlich höher als im Norden, wo mehr Solar- und Windenergie zugebaut wurden — weil es erhebliche Leitungsengpässe gibt. Die politische Auseinandersetzung darum wird schärfer. Die zweitweise beträchtlichen Preisunterschiede zwischen den europäischen Gebotszonen sind ein Indikator für Leitungsengpässe — die norwegischen Verbraucher waren gar nicht begeistert über den Preisanstieg nach der kürzlichen Eröffnung einer neuen großen Leitung nach Deutschland. In den USA und anderswo gibt es Marktmodelle, die durch geographisch differenzierte Preise für eine bessere geographische Steuerung sorgen. So werden in mehreren US-Bundesstaaten jeweils Strompreise für mehrere Hundert Netzknoten errechnet.

Einfach alle Leitungsengpässe zu beseitigen, um der “Kupferplatte” wieder näher zu kommen — der häufig geforderte massive Netzausbau — und weiterhin alles zentral zu regeln ist aber eine unnötig teure Lösung. Es braucht wieder Anreize dafür, dass der Strom genau zur richtigen Zeit in der Nähe des Verbrauchs erzeugt wird — sonst wachsen die Netzkosten weiter. Wie wir noch sehen werden, wurden in den letzten Jahren vielfältige Ansätze dafür entwickelt und ausprobiert: lokale Strombörsen, Konzepte für “zelluläre Systeme”, größere Verantwortung für lokale Netzbetreiber, die Erlaubnis zur direkten Belieferung von Nachbarn. Alles Konzepte, die eigentlich “systemwidrig” sind und hier und da Elemente einer dezentrale “bottom-up” Steuerungslogik in das System einbringen…

Ein weiteres Symptom für die Widersprüchlichkeiten des gegenwärtigen Systems sind die in vielen Ländern endlosen Verzögerungen und Querelen bei der Einführung intelligenter Stromzähler: Da geht es nicht wirklich um technische Schwierigkeiten, sondern um die heiße Frage, wer Zugriff auf welche Daten hat, und wer — wenn überhaupt — das Recht bekommt, privaten Verbrauch von außen zu steuern.

Eine grundlegende Herausforderung für das mit der Strommarktliberalisierung eingeführte und seither verfeinerte Marktsystem sind die ganz unterschiedlichen Kosten- und Zeitstrukturen der alten und der neuen Kraftwerke. Der einfachste Aspekt davon sind die unterschiedlichen Realisierungszeiten: Planung und Bau einer Fabrik für Solarmodule brauchen zwei Jahre, große Solarkraftwerke ein Jahr, Dachanlagen wenige Monate. Und mit jeder Fabrikgeneration purzeln die Preise. Das ist für die Repräsentanten des alten Systems unfassbar. Die über Jahrzehnte entwickelten Planungsmechanismen mussten für Großkraftwerke mit Jahrzehnten rechnen.

Schwerwiegender ist die andersartige Kostenstruktur: Wind- und Solarkraftwerke haben keine Brennstoffkosten. Die marginalen Kosten der Stromerzeugung sind Null: die Anlagen kosten gleichviel, ob sie Strom erzeugen oder nicht. Darin sind sie den Netzen ähnlich. Außerdem ist die Erzeugung mit Sonne und Wind von natürlichen Zyklen und dem Wetter abhängig. Zur Kompensation müssen zusätzliche Flexibilitäten im Verbrauch, in der Erzeugung und mit Speichern mobilisiert werden. Nicht nur der kurzfristige Abgleich ganz verschiedenartiger Erzeugungsarten, sondern insbesondere auch die langfristige Steuerung der Investitionen wird mit den bisherigen Marktmechanismen immer schwieriger, denn die Entwicklung des Risikoprofils ist schwer abschätzbar. So versucht man mit separaten Märkten und Sonderregelungen nachzubessern — oft ohne zu wissen, wohin die Reise wirklich gehen soll…

Inzwischen bekennen sich fast alle zum Wandel des Stromsystems — aber wie schnell und wohin?

So ist aus einem übersichtlichen, zentralistisch gesteuerten System ein Flickenteppich aus komplizierten Regeln und widersprüchlichen Logiken entstanden. Nicht wenige trauern alten Zeit nach. Aus Bequemlichkeit, oder weil ihnen droht, Pfründe zu verlieren. Um gleichzeitig Konkurrenz und Versorgungssicherheit zu gewährleisten, unterscheiden die EU-Marktregeln über 70 verschiedene Rollen, die ein Unternehmen im Geflecht der Strommärkte einnehmen kann — und trotzdem kontrollieren in vielen Ländern immer noch einige wenige große Player das Geschehen.

Die Ungereimtheiten sind Ausdruck eines tiefgreifenden Wandlungsprozesses des Stromsystems, der einerseits institutionelle Fragen betrifft (Marktdesign, Regulierung, Unternehmensstruktur, Steuerungslogik, Rolle der Prosumenten) und andererseits die technische Infrastruktur, in der neue Technologien (wenn sie denn eingesetzt werden) ganz neue Flexibilitäten und Steuerungslogiken ermöglichen. Beide Dimensionen sind eng verknüpft.

Ganz unterschiedliche Akteure bringen neue Regelungsansätze, Handelsplattformen, Überwachungssysteme, Kommunikationsmodelle, Speicher, Energiewandler und flexible Verbraucher in das System ein — mit ganz unterschiedlichen Steuerungslogiken. Trotz aller Widersprüchlichkeiten haben sie in beiden Dimensionen — der institutionellen und der technischen — dazu beigetragen, dass das System auch mit einem hohen Anteil “systemwidriger” Stromerzeugung nicht kollabiert ist.

Dass ein Wandel des Stromsystems unausweichlich ist, wird inzwischen weitgehend anerkannt. Auch von den meisten Unternehmen. Aber wie schnell? Und in welche Richtung? Die gesellschaftliche Auseinandersetzung, in der verschiedene Interessen aufeinanderprallen, dreht sich vor allem um vier Fragenkomplexe:

Die Notwendigkeit, den CO2-Ausstoß auf Null abzusenken, wird gesellschaftlich und politisch inzwischen akzeptiert und als immer dringender wahrgenommen. Aber über das einzuschlagende Tempo gehen die Meinungen auseinander.

Die wachsende Konkurrenzfähigkeit der erneuerbaren Energien ist nicht mehr zu leugnen — auch wenn sie durch vielfältige Vorschriften, Marktregeln und Subventionen in unterschiedlicher Weise benachteiligt werden. Aber auf welche Quellen und Akteure soll man beim Lichten des Regel-Gestrüpps vor allem setzen? Photovoltaik auf allen Dächern? Riesige Offshore-Windfarmen? Wasserstoff aus Solarkraftwerken in sonnenreichen Ländern? Kleine Prosumenten? Nachbarschaften? Kommunen? oder große Konzerne?

Die neuen technischen Möglichkeiten der Umwandlung von Energie, der Steuerung der Energieflüsse und der Flexibilisierung des Verbrauchs brechen abgeschottete Märkte auf und erleichtern das Vordringen der Erneuerbaren. Wie gut schaffen es die alten Platzhirsche den Prozess zu verlangsamen? Wie schnell schaffen sie es, Geschäftsmodelle zu entwickeln, die ihnen bei aller Flexibilität weiterhin eine zentrale Kontrolle ermöglichen? Wie schnell schaffen es andere Unternehmen und kleine Versorger, mit den neuen Technologien die Effizienzvorteile lokaler Märkte und netzförmiger Steuerungslogiken zur Geltung zu bringen?

Hohe Energiepreise sind im internationalen Wettbewerb ein Nachteil. Welche Industriebranchen, welche Länder können es sich leisten, im großen Umbruch zu den Nachzüglern zu gehören, um einige Privilegien nicht aufzugeben? Während noch um die Jahrtausendwende eine Handvoll großer Konzerne in Europa, Amerika und Japan die technologische Entwicklung vorgeben konnten, verderben inzwischen vor allem China aber auch weitere Kräfte das alte Spiel. Es gibt ernsthaften Wettbewerb. Nicht nur um einzelne Produkte, sondern um Systeme. Welche Art von Energiesystem wollen wir? Wer soll darin das Sagen haben?

Die Bedeutung dieser Auseinandersetzungen ist nicht zu unterschätzen. Das Elektrizitätssystem wird zum Kern des künftigen Energiesystems. Es geht nicht mehr nur um die Versorgung der traditionellen Stromkunden: auch die Wärmeversorgung und der Verkehr müssen weitgehend elektrifiziert, bzw. mit dem Stromsystem gekoppelt werden. Millionen von Elektrofahrzeugen und Gebäudesystemen, die Strom aus dem Netz beziehen und einspeisen, lassen die Anzahl der flexibel agierenden Systemteilnehmer und das Volumen der Stromproduktion explodieren.

Eine grundsätzliche Auseinandersetzung um die Steuerungslogik, um die Governance unserer immer mächtigeren sozio-technischen Systeme

Die Auseinandersetzungen um die Steuerungslogik und damit über die Macht der unterschiedlichen Player im Stromsystem dauern an und werden an Heftigkeit zunehmen — von der Öffentlichkeit bisher weitgehend unverstanden. Die Frage der Steuerungslogik betrifft sowohl die institutionelle als auch die technische Dimension.

Dabei schaffen, wie ich im Laufe dieser Serie zu zeigen versuche, neue technische Entwicklungen ganz neuartige Möglichkeiten: Die aus physikalischen Gründen ökonomisch und technisch immer dominantere Photovoltaik (siehe Folge 12) erlaubt eine immer dezentralere und günstigere nachhaltige Stromerzeugung. Leistungselektronik (demnächst Folge 14) und neuartige Speicher (Folge 15) erhöhen die Flexibilität des Systems massiv, erlauben eine weitgehende Elektrifizierung und Kopplung aller Sektoren und legen eine möglichst dezentrale, vernetzte Mehrebenen-Steuerung nahe. Neue Techniken zur Umwandlung von Strom in Strahlung schließlich (Folge 16) ermöglichen unerhörte Energie- und Materialeinsparungen. Das hat Folgen in allen Lebensbereichen.

Um den Verlust von Kontrolle zu vermeiden, versuchen die alten Stromversorger die alte zentrale Steuerungslogik, trotz massiver Zunahme der zu steuernden Anlagen, durch die Nutzung neuer Möglichkeiten zur zentralen Verarbeitung riesiger Datenmengen aufrechtzuerhalten. Deshalb wird gleichzeitig zur erwähnten Entwicklung von lokalen Strombörsen und zellulären Systemen, in denen autonome lokale Akteure interagieren, von anderen Einrichtungen auch an zentralen Kontrollsystemen gearbeitet: Am zentralen Durchgriff auf die Steuerung privater Anlagen, an Geschäftsmodellen auf der Grundlage von Smart-Meter-Daten, oder einem digitalen Zwilling der europäischen Stromnetze, der eine zentrale Übersicht ermöglichen soll. Der Öffentlichkeit sind diese verschiedenen Konzeptionen kaum bewusst. Es wird einfach mehr “Digitalisierung” gefordert.

Die sich aus der Entwicklung des Stromnetzes ergebende Auseinandersetzung ist grundsätzlicher Art. Denn es geht zunehmend nicht mehr nur um das traditionelle Stromsystem, sondern um das Energiesystem als Ganzes, um die Hoheit über Daten und den Zugriff auf die Steuerung von Prozessen in allen Lebensbereichen. So treibt zum Beispiel China die Integration verschiedenster sozialer und technischer Überwachungssysteme zu KI-gestützten „city-brains“ voran, die eine „one screen social governance“ erlauben sollen und später zu „nation brains“ und auch darüber hinaus zusammengeschaltet werden sollen. City brains werden nicht nur in China installiert, sondern auch entlang der neuen Seidenstraße in andere asiatische und afrikanische Großstädte exportiert. Sie basieren auf einer eindeutig zentralistischen Kontrollvision, der Europa nicht nur Angebote westlicher Hersteller für Smart-city-Systeme, sondern eine explizit andere Governance-Logik entgegensetzen sollte.

Die zentralistische Kontroll-Logik, die sich aus der Geschichte unserer Stromsysteme ergeben hat, müsste in demokratischen Gesellschaften vor dem Hintergrund neuer technischer Entwicklungen ganz explizit in Frage gestellt werden. Dem Durchgriff von Netzbetreibern auf alle möglichen Produktionsanlagen und Heizungssysteme — so abgeschwächt und differenziert diese Ansätze inzwischen auch formuliert werden — ist eine autonome Steuerung lokaler Systeme, die auf Preissignale reagieren, aus meiner Sicht auf alle Fälle vorzuziehen. Denn es geht um mehr. Es geht um die Steuerungslogik unserer immer mehr auf Technik angewiesenen Gesellschaft, um Selbstbestimmung und Demokratie.

Die technischen Möglichkeiten zur infrastrukturellen Durchsetzung von Entscheidungsmechanismen und Steuerungslogiken sind um Größenordnungen gewachsen. Aber die physikalischen und technischen Gründe für eine zunehmende Zentralisierung, die in der herkömmlichen thermischen und hydraulischen Energiegewinnung bestimmend waren, gelten in der neuen Energiewelt nicht mehr. Wir werden frei von Zwängen, die uns zweihundert Jahre begleitet und unser Denken geprägt haben. Dezentrale Steuerung wird eine ernsthafte Option.

Wir stehen also erstens vor der Aufgabe, den Wandel des Stromsystems weg von den fossilen Brennstoffen und hin zu den Erneuerbaren so schnell zu bewerkstelligen, dass eine Klimakatastrophe, unter denen unsere Kinder und Enkel schwer zu leiden hätten, weitgehend vermieden werden kann.

Wir stehen zudem zweitens vor der Herausforderung, die neue Steuerungslogik des Energiesystems so zu wählen, dass Selbstbestimmung und Demokratie gestärkt und nicht durch eine immer zentralistischere, hochtechnisierte Kontroll-Infrastruktur eingeschränkt werden. Autoritäre Lösungen lägen durchaus in der Logik der bisherigen Entwicklung des Stromsystems. Aber mit der andersartigen technischen Logik der Nanowissenschaften und der Abkehr vom Feuer (siehe Folge 9) haben wir eine riesige Chance.

Dass die neuen technischen Entwicklungen eine nachhaltige, dezentrale, selbstbestimmte Energieversorgung ermöglichen, die auch ökonomisch am vorteilhaftesten wäre, sollte spätestens am Ende dieser Serie deutlich werden.