Emanzipation von der Mechanik – der lange Weg zur modernen Leistungselektronik

Geschichte der Energietechnik (14) – Die Entdeckung der Nanowelten ermöglicht eine erneuerbare Energieversorgung für Alle

Die Bedeutung der Leistungselektronik für den Umbau des Energiesystems wird massiv unterschätzt. Sie ist dabei, unseren Umgang mit Strom grundlegend zu revolutionieren. Bilder von Solarzellen, Windturbinen, Atomkraftwerken, LEDs, Wärmepumpen und Mikrochips kennt jeder. Aber unter Ladereglern, Frequenzumrichtern, IGBTs oder MOSFETs kann sich kaum jemand etwas vorstellen. Dabei steckt Leistungselektronik heute in jedem Ladegerät, in jeder LED-Lampe und natürlich in jedem Elektroauto. Die moderne Leistungselektronik entwickelte sich nach verschiedenen Vorläufern erst mit der quantentheoretisch basierten Halbleitertechnik. Ihre Bedeutung liegt erstens darin, dass sich damit Strom fast beliebig umwandeln lässt, so dass seine Kenngrößen mit sehr geringen Verlusten dem jeweiligen Bedarf angepasst werden können. Zweitens ist es damit möglich, diese Wandlungen und das Schalten mit geringem Aufwand digital zu steuern. Diese beiden Aspekte eröffnen im Vergleich zur vorherigen elektromechanischen Technik ganz neue Möglichkeiten bei der Erzeugung, dem Transport und der Anwendung von Strom, die noch lange nicht ausgeschöpft sind.

Artikelserie zur Technikgeschichte:

Die Entdeckung der Nanowelten ermöglicht eine erneuerbare Energieversorgung für Alle

Die bisherigen Folgen:

Kernspaltung: Frühe, verführerische Frucht einer wissenschaftlichen Revolution

Wo die sinnliche Erfahrung versagt: Neue Methoden erlauben die Entdeckung von Nano-Welten

Virtuelle Welten auf Siliziumbasis: Nanowissenschaften revolutionieren die Informationstechnik

Die Entzauberung des biologischen Informationssystems – kein dauerhafter Beitrag zur Energietechnik

Die Geschichte der fossilen Energieversorgung, Grundlage der Industrialisierung

Die Klimakrise stellt die industrielle Zivilisation in Frage: Welche Optionen haben wir?

Dank Nanowissenschaften: Strom direkt aus Sonnenlicht wird unschlagbar günstig

PV: Zunehmende Kostenvorteile durch nanotechnische Dematerialisierung

Big was beautiful — Wie die Dampfkraft unsere Institutionen geprägt hat

Umbau des Stromsystems seit 50 Jahren – Von der Zentrale zum Netzwerk

In dieser Folge geht es zunächst um die Geschichte der Leistungs-Elektronik bis zur Jahrtausendwende, die sich zeitversetzt aus der Signal-Elektronik entwickelte und mit ihr eng verknüpft ist. Ohne die wesentlichen Elemente dieser Geschichte sind die heutige und die künftige Bedeutung der Leistungselektronik kaum zu verstehen.

Erst in der nächsten Folge dieser Serie geht es dann um die atemberaubende Entwicklung der Leistungselektronik seit der Jahrtausendwende: Drastische Miniaturisierung, dramatische Kostensenkung und schnelle Verbreitung schaffen in allen Bereichen der Elektrizitätserzeugung, -nutzung und -verteilung mit wesentlich höhere Flexibilität und Effizienz ganz neue Möglichkeiten. Erst damit wird die Elektrizität zur flexiblen Universal-Energie, die ein neues Zeitalter der Energietechnik eröffnet.

Leistungselektronik – das elektrische Pendant zum mechanischen Getriebe

In der Mechanik verwendet man Hebel und Getriebe, um mechanische Energie umzuwandeln: geringe Kraft mit langem Weg in große Kraft mit kurzem Weg, schnelle Drehung in langsame mit umso größerer Kraft, langsame Schwingungen in schnelle Schwingungen — alles in beiden Richtungen. Zahnräder und Seilwinden gab es schon im Altertum. Getriebe in Mühlen dienten dazu, die mechanische Energie des Windes oder eines Flusses in brauchbare Formen umzuwandeln, Leistung zu übertragen.

Mit Mechanik konnten aber auch Informationen übertragen und verarbeitet werden. Mit mechanischen Stellhebeln, Gestängen und Zahnrädern wurden Mühlen, Nähmaschinen, Sägewerke oder Webstühle gesteuert. Getriebe in mechanischen Uhren und mechanischen Rechenmaschinen dienten nicht der Leistungsübertragung, sondern der Übertragung und Verarbeitung von Signalen. Aber die mechanische Signalverarbeitung war immer hochspezialisiert, wenig flexibel und meist eng mit mechanischer Energieübertragung und Kraftanwendung verknüpft.

Mit der Entwicklung der Elektrotechnik hat sich die Signal- und Informationsverarbeitung immer stärker von der Leistungsübertragung gelöst. In Folge 5 haben wir im groben Überblick gesehen, wie die klassische Physik der Elektrodynamik zunächst die Entwicklung der Elektronenröhren und damit eine nichtmechanische Signalverarbeitung erlaubte, dann mit Hilfe der Quantentheorie die Halbleitertechnik entstand, die ihrerseits die digitale Mikroelektronik hervorbrachte, und schließlich darauf aufbauend, auf einer ganz anderen Abstraktionsebene, zur Entwicklung der Informatik führte.

In dieser Folge werden wir diese Geschichte noch einmal aus einer anderen Perspektive betrachten, denn die Leistungselektronik ist das rein elektrische Pendant zum mechanischen Getriebe für die Leistungsübertragung. Signalverarbeitung ist nicht ihre Aufgabe, aber sie beruht zu einem beträchtlichen Teil auf Technologien, die zunächst für die Signalverarbeitung entwickelt wurden.

Bis zu ihrem heutigen Entwicklungsstand, der ganz neue Möglichkeiten eröffnet, war es ein langer Weg. Die Leistungselektronik hat sich im Laufe der Zeit aus anderen Bereichen der Elektrotechnik und Elektronik heraus entwickelte und wurde lange gar nicht als separate Technik wahrgenommen — das ist wohl auch ein Grund für die geringe Bekanntheit ihrer Bedeutung.

Um den heutigen Umbruch in unserem Umgang mit Energie zu verstehen, scheint es mir wichtig, zunächst die verschiedenen Etappen dieser Entwicklung in ihrer Bedeutung für die explosiv gewachsenen Möglichkeiten der Energieumwandlung und -steuerung nachzuvollziehen. Auch hier zeigt sich wieder – wie schon mehrfach in diesem Blog – wie fundamental die Rolle der Revolution in der Physik vor hundert Jahren und der Bedeutungsgewinn von Information im Verhältnis zu Energie und Material für die Bewältigung der existenzbedrohenden Wachstumskrise unserer Zivilisation sind.

Die Anfänge der Elektronik –

Emanzipation von der Mechanik

Die systematische Erforschung der Elektrizität begann mit Gleichstrom aus Alessandro Voltas Zink-Kupfer-Batterie um 1800. In den zwanziger und dreißiger Jahren entdeckten Oersted, Henry und Faraday Zusammenhänge zwischen elektrischem Strom und Magnetfeldern. Maxwell gelang es dann 1864, die Zusammenhänge zwischen elektrischen und magnetischen Feldern mathematisch zu fassen (Elektrodynamik). Daraus entwickelte sich einerseits, wie in den letzten Folgen beschrieben, die Erzeugung von elektrischer Energie aus mechanischer Energie (Dampf-, Wind- und Wasserkraft), sowie umgekehrt die weitverbreitete Erzeugung mechanischer Energie aus elektrischem Strom. Andererseits wurden auf Grundlage der Maxwell’schen Erkenntnisse ganz neuartige Technologien entwickelt, bei denen mechanische Bewegung keine Rolle spielte. Für diese neuartigen Entwicklungen waren elektro-magnetische Schwingungen von zentraler Bedeutung.

Schon der 1881 erfundene Transformator beruhte auf der Wechselwirkung von elektrischen und magnetischen Wechselfeldern: Ohne den Umweg über mechanische Energie können große Mengen elektrischer Energie zwischen zwei Spannungsniveaus übertragen werden — ein erstes elektromagnetisches „Getriebe“, bei dem Spannung und Stromstärke eines Wechselstroms verändert werden, aber die Frequenz gleichbleibt. Für die Umwandlung von Wechselstrom in Gleichstrom – der auch nach der Umstellung der Versorgungsnetze von Gleichstrom auf Wechselstrom (siehe Folge 12) für viele Anwendungen wichtig war – musste man allerdings noch den Umweg über mechanische Energie nehmen: ein mit der Wechselspannung synchron rotierender Schleifkontakt mit mehreren Polen (Kommutator) sorgte für eine regelmäßige Umpolung. Eine solche Vorrichtung war fester Bestandteil der Edison’schen Gleichstromgeneratoren, von verschiedenartigen elektromechanischen Umformern zwischen verschiedenen Stromarten und lieferte bis in die 1970er Jahre den Ladestrom für Autobatterien. Damit konnte jeweils nur eine, relativ niedrige Wechselstromfrequenz gleichgerichtet werden.

Für die weitere Entwicklung der Strom-Umformung ohne Mechanik spielte zunächst die Nachrichtentechnik, d.h. eine Signalverarbeitungs-Technik, die entscheidende Rolle. Bereits im 18. Jahrhundert gab es Bestrebungen, Signale mit Stromimpulsen durch Leitungen zu übertragen. Ab 1830 entwickelte sich die Telegraphie mit brauchbaren Techniken, die insbesondere von den Eisenbahngesellschaften vorangetrieben wurden. Ab 1850 wurden dafür auch Seekabel verlegt. 1870 waren alle Kontinente verbunden. Die schnelle Kommunikation über große Entfernungen veränderte Handel und Politik. Ein eindrucksvolles Beispiel ist das Vorgehen des englischen Imperiums in Indien, nachdem Nachrichten zwischen Delhi und London nicht mehr mehrere Wochen, sondern nur noch wenige Minuten brauchten: an der kurzen Leine aus der Zentrale geführt, wurde die Kolonialpolitik deutlich rücksichtsloser.

1888 gelang es Heinrich Hertz — nach dem die Einheit für die Frequenz benannt ist — die von Maxwell vorhergesagten elektromagnetischen Strahlen in Form von (ultrakurzen) Radiowellen zu erzeugen. Dazu regte er mit einem Hochspannungspuls einen elektrischen Schwingkreis an, der aus einer Spule (aufgewickeltem Draht) und einem Kondensator (zwei dicht aneinanderliegenden, aber voneinander isolierten Metallflächen) bestand, mit deren Größen sich die (hohe) Frequenz des Hin- und Herschwingens zwischen elektrischem Feld (Kondensator) und magnetischem Feld (Spule) einstellen ließ. Durch die offene Konstruktion des Schwingkreises als Antenne wurde die Energie nach und nach als Radiowelle abgestrahlt. Damit war nachgewiesen, dass elektromagnetische Energie als Strahlung unabhängig von elektrischen Leitern existieren und übertragen werden kann.

Ganz praktisch waren damit die Grundlagen für die Funktechnik gelegt, die man nicht nur für die Übertragung von Telegraphensignalen, sondern auch von Tönen zu nutzen hoffte. Schon seit der Entdeckung der Induktion durch Faraday hatte es verschiedene Überlegungen und Versuche gegeben, die mechanischen Schwingungen von Schall in elektrische Schwingungen zu verwandeln und dann über längere Strecken zu übertragen. 1876 schließlich stellte Graham Bell an der Weltausstellung in Philadelphia ein brauchbares Telefon vor. Er verbesserte auch den von Edison erfundenen Phonographen, der die dauerhafte Aufzeichnung und Wiedergabe von Tönen erlaubte. Damit entstand ein riesiges Interesse an der Erkundung und Verarbeitung elektrischer Schwingungen verschiedenster Frequenzen.

Lange Zeit konnten mit auf dem Hertz’schen Schwingkreis basierenden Sendern nur Impulse übertragen werden, was allerdings die zunehmend weitreichende Übertragung von telegraphischen Signalen erlaubte. Erst 1904 gelang Valdemar Poulsen mit dem Lichtbogensender, der kontinuierliche Radiowellen abstrahlen konnte, die Übertragung von Tönen. Dazu wurden die Intensität (Amplitude) der schnell schwingenden Radiowellen (Trägerfrequenz) mit den wesentlich langsameren Schwingungen der Töne (Signalfrequenz) „moduliert“, was mit einer einfachen Spulenkonstruktion (Transduktor) bewerkstelligt wurde.

Zum Empfang der Morse-Impulse und später der Töne war es erstens notwendig, die Radiowellen mit einer Antenne und einem Schwingkreis, die auf die Radiofrequenz des Senders abgestimmt waren, einzufangen, und zweitens die Intensitätsschwankungen hörbar zu machen. Dazu diente ein „Kristall-Detektor“, der als Gleichrichter der hochfrequenten Wechselspannung wirkte, so dass nur die aufmodulierte Tonfrequenz übrigblieb und in einem Kopfhörer hörbar wurde. Diese Kristall-Detektoren waren die ersten Halbleiter-Dioden. 1874 hatte Ferdinand Braun entdeckt, dass Punktkontakte von Metallspitzen auf Bleisulfid-Kristallen Strom nur in einer Richtung durchlassen – aber die Physik hinter diesem Effekt war noch nicht verstanden. Zehn Jahre später nutzte dann erstmals Jagadish Chandra Bose diesen Effekt für den Rundfunk-Empfang mit einem Kristall-Detektor.

Kurz zuvor (1883) erhielt Edison ein Patent auf einen Gleichspannungsregler, der den von ihm wiederentdeckten Effekt nutzte, dass zwischen dem glühenden Draht einer Glühbirne und einem zusätzlichen Kontakt in der Birne ein Strom fließen kann (Glühemission), der von der Spannung des Heizstromes abhängt. Edisons Vorrichtung kann man als die erste elektronische Schaltung bezeichnen. Aber es dauerte dann noch gut zwanzig Jahre bis John Ambrose Fleming die Tatsache, dass Edisons Glühemissions-Vorrichtung nur eine Stromrichtung zuließ, zum Bau eines Detektors für den Empfang von Radiosignalen nutzte. 1904 patentierte er eine weiterentwickelte „Vakuum-Diode“, in der Strom – inzwischen physikalisch erklärbar – in Form von negativ geladenen Elektronen durch das Vakuum von einer glühenden Kathode zu einer kalten Anode fließen konnte.

Diese grundlegende technische Erfindung war vor dem Hintergrund einer längeren wissenschaftlichen Entwicklung möglich geworden: Schon 1834 hatte Faraday aufgrund von elektrochemischen Experimenten vermutet, dass es eine elektrische Elementarladung geben müsse. Seit den 1860er Jahren wurde auf der Suche danach mit Gasentladungsröhren experimentiert. In den 1870er Jahren entstand die Bezeichnung „Elektron“ und erst in den Neunzigern wurde nachgewiesen, dass in Vakuumröhren entstehende Kathodenstrahlen als Teilchen, als Elektronen angesehen werden können. Mit den Röhren-Dioden kam deshalb der Begriff „Elektronik“ auf.

Mit Kristall-Detektoren und Röhrendioden waren die ersten elektronischen Gleichrichter verfügbar. Während der Halbleiter-Effekt der Kristalldetektoren noch unverständlich war, konnte die Funktionsweise der Röhrendiode mit der damaligen Physik gut beschrieben werden.

Schon 1906 meldeten dann parallel und fast gleichzeitig Robert von Lieben (Österreich) und Lee de Forest (USA) Patente für Elektronenröhren an, bei denen der Elektronenstrom zwischen Kathode und Anode gesteuert werden konnte. Dazu wurde an ein dazwischenliegendes Metallgitter eine geringe, gegenüber der Kathode negative Spannung angelegt, die die Elektronen mehr oder weniger bremste. Damit wurde es möglich, elektrische Ströme ohne mechanische Vorrichtungen mit schwachen elektrischen Signalen fast ohne Verzögerung präzise zu steuern. Das war die Geburt des elektronischen Verstärkers und – als Sonderfall – auch des elektronischen Schalters.

Damit eröffnete sich in den ersten Jahren des letzten Jahrhunderts ein riesiges Feld technischer Anwendungen. Die beliebige Verstärkung und Filterung elektrischer Signale unterschiedlichster Frequenzen – mit immer raffinierteren elektronischen Schaltungen aus zunehmend genormten Kondensatoren, Spulen, Widerständen und Röhren – erlaubte die Verarbeitung von Tonsignalen (Audiotechnik), von Trägerfrequenzen (Rundfunk- und Nachrichtentechnik), von Messsignalen aller Art (Messtechnik), und bald auch von Bildsignalen (Fernsehtechnik).

Im ersten Weltkrieg wurden Hunderttausende von Soldaten als Funker ausgebildet und kamen mit der neuen Technik in Berührung. Das trug anschließend erheblich zur breiten Beschäftigung mit den neuen Möglichkeiten der Elektronik bei. Ab den zwanziger Jahren entstanden weltweit öffentliche Radioprogramme, meist versuchte der Staat sie zu kontrollieren. Politiker aller Couleur entdeckten das Radio als ein neues Medium, mit dem sie die Bevölkerung direkt erreichen konnten. Die Anzahl der privaten Radiogeräte nahm rasant zu. 1932 hatten in Deutschland 4 Millionen Hörer eine Lizenz der Reichspost. 1935 wurde geschätzt, dass 60 Prozent aller US-Haushalte ein Radio hatten und diese 40 % der weltweit existierenden Radiogeräte ausmachten. Die Massenproduktion von Radios führte zu einer Standardisierung und Verbilligung elektronischer Komponenten, was auch industriellen Anwendungen zugutekam (so wie in den letzten Jahren die massive Nachfrage nach Sensoren für den Einbau in Smartphones ganz erheblich bei der Entwicklung und Kostensenkung von Industrie-Robotern geholfen hat). Mit immer zuverlässigeren Röhren wagte man sich ab den vierziger Jahren auch daran, große Stückzahlen als digitale Schalter in den ersten Computern zu verbauen, was sich allerdings als sehr aufwändig erwies (siehe Folge 5) – vorerst dominierte die analoge Elektronik.

Mit diesen Erfolgen in der Signalverarbeitung entstand also ein eigenständiger Technikzweig, die Elektronik, mit der unabhängig von mechanischer Energie große Mengen nicht zweckgebundener Information leitungsgebunden oder drahtlos übertragen werden konnten.

Mit der Elektronenröhre stand zudem nun ein Verstärker zur Verfügung, mit dem elektrische Ströme durch beliebige schwache elektrische Signale mit großer Geschwindigkeit präzise gesteuert werden konnten. Eine solche Steuerung war mit den bis dahin verfügbaren Energieformen (mechanischer, chemischer, thermischer Energie) weder in dieser Allgemeinheit noch in dieser Geschwindigkeit möglich. Mit den verfügbaren Leistungen konnte man zwar keine großen Maschinen steuern, aber für die Signalübertragung über beliebige Distanzen, für die analoge Analyse von Signalen mit Filtern, für die Realisierung digitaler logischer Schaltungen, sowie für die Signal-Ausgabe über Lautsprecher und Bildschirme waren sie ausreichend.

Erste Elektronik für größere Leistungen – gleichrichten und verlustlos regeln

Um all diese elektronischen Geräte zu betreiben, waren verlässliche Gleichstromquellen verschiedener Spannungen erforderlich. Dazu wurde der Wechselstrom aus der Steckdose mit Transformatoren auf das erforderliche Spannungsniveau gebracht und anschließend mit leistungsfähigen Röhren-Dioden gleichgerichtet. Diese lieferten eine pulsförmige „Halbwelle“, die mit geeigneten Schaltungen aus Kondensatoren, Spulen und Widerständen noch „geglättet“ werden musste, damit der „Brumm“ der Netzfrequenz nicht in den Tonsignalen zu hören war. Transformatoren, Gleichrichter und Glättungsschaltungen zusammen nannte man Netzteile – man kann sie als Anfang der Leistungselektronik betrachten.

Für größere Leistungen allerdings waren Vakuum-Dioden mit Glühkathoden zu schwach. Für hohe Spannungen kam bald der 1902 von Peter Cooper-Hewitt entwickelte Quecksilberdampfgleichrichter zum Einsatz, bei dem ein Lichtbogen in Quecksilberdampf als Elektronen emittierende Kathode diente (positiv geladene Quecksilberionen in der Röhre sorgen für eine Kompensation der Raumladung der stromführenden Elektronen und erlauben dadurch hohe Leistungen). In der Industrie wurden für den Betrieb von elektrochemischen Anlagen, Straßenbahnen und anderen Gleichstrom-Großverbrauchern meterhohe Anlagen gebaut. Bis 1975 wurden Quecksilbergleichrichter für Hochspannungs-Gleichstrom-Übertragungen (siehe unten) eingesetzt.

Lange suchte man nach Möglichkeiten, um in Analogie zur Elektronenröhre in der Signal-Elektronik die Leistung der Quecksilber-Gleichrichter zu steuern. Das war aber nicht so einfach, denn einmal „gezündet“ war der Strom im Lichtbogen nicht mehr zu steuern. Erst in den dreißiger Jahren gelang es der Firma Westinghouse, bei Quecksilber-Gleichrichtern die Leistung mit einem anderen Ansatz zu beeinflussen. Dazu machte man sich die Tatsache zunutze, dass die Stromleitung bei jeder Schwingung der gleichzurichtenden Wechselspannung mit einer Hilfsspannung (wie bei Leuchtstofflampen) neu „gezündet“ werden musste. Indem man die Zündung leicht verzögerte, konnte man den durchschnittlichen Stromfluss verkleinern. Dieses Prinzip des „Phasenanschnitts“ wird bis heute z.B. zum Dimmen von Lampen verwendet, aber mit anderen Bauteilen realisiert. Diesen weiterentwickelten Quecksilbergleichrichter nannte man Ignitron, er konnte Leistungen bis zu mehreren Megawatt verarbeiten. Ab 1954 wurden elektrische Lokomotiven mit Ignitrons gebaut. Damit war eine verlustarme stufenlose Regelung möglich, die ein ruckfreies Anfahren ermöglichte.

Quantensprung – neue Physik eröffnet mit Halbleitern neues Zeitalter der Energietechnik

Dass es außer elektrischen Leitern und Nichtleitern Materialien gibt, die dazwischenliegen und sich zunächst nicht nachvollziehbar verhalten, war schon im 18. Jahrhundert bekannt. Alessandro Volta bezeichnete sie 1783 als Halbleiter. Seinerzeit zählte man auch Holz oder Seife dazu und untersuchte die elektrischen Eigenschaften vieler Materialien. Einfach nachzuvollziehen war das von Georg Simon Ohm nach Messungen an Metallen 1825 publizierte Ohm’sche Gesetz (I=U/R). Für Halbleiter aber konnte man keine Gesetzmäßigkeit finden, außer, dass manche Anordnungen Strom nur in einer Richtung durchließen.

Bis zur Beschreibung von Kristall-Dioden durch Braun 1874 (siehe oben) kam man damit nicht voran. Doch auch die breite Verwendung von Kristall-Detektoren – den ersten Halbleiter-Bauteilen – in der Frühzeit der Radiotechnik änderte nichts daran, dass man ihre physikalische Wirkungsweise nicht richtig verstand. Während sie wegen ihrer Unzuverlässigkeit dann weitgehend durch die Röhrentechnik ersetzt wurden, kam ab 1930 ein anderes Halbleiter-Bauteil in großen Zahlen zum Einsatz: der Selen-Gleichrichter. Für Netzteile in allen möglichen elektronischen Geräten erwies er sich als langlebiger und kostengünstiger als Röhrendioden, war aber wegen ungünstiger Eigenschaften für andere Zwecke ungeeignet.

Deshalb nahmen ab Ende der Zwanzigerjahre die Bemühungen zu, den Halbleiter-Effekt besser zu verstehen und verschiedene Materialien zu erproben, vor allem Silizium- und Germaniumkristalle. Seit den frühen Dreißigerjahren wuchs zudem das militärische Interesse an schnell schaltenden Halbleiter-Dioden: Für die Entwicklung von Radarsystemen brauchte man hohe Frequenzen im Mikrowellenbereich, die Röhrendioden kaum liefern konnten.

Als erster führte der britische Mathematiker Alan H. Wilson 1931 während seines Aufenthalts am Institut von Werner Heisenberg in Leipzig die quantenmechanische Betrachtungsweise in die Halbleiterphysik ein. Während die Elektronenleitung in Vakuum- und Quecksilberdioden noch mit klassischen Vorstellungen anschaulich erklärbar war, entzogen sich die nanoskaligen Vorgänge an den Kontaktpunkten zwischen Metallen und Halbleiterkristallen den an der Makrowelt geschulten Theorien. Wilson zeigte aufgrund der Quantentheorie, die für Atome entwickelt worden war, dass auch Elektronen in einem Kristallgitter nicht beliebige Energiewerte annehmen können, sondern auf bestimmte Zustandsbereiche, die Energiebänder, beschränkt sind, die in Halbleitern durch Verunreinigungen entscheidend beeinflusst werden können. 1938 gelang Walter Schottky eine weitgehend befriedigende Erklärung der Halbleiter-Metall-Sperrschicht (Schottky-Diode), indem er annahm, dass die Stromleitung in Halbleitern nicht durch überschüssige Elektronen, sondern durch fehlende Elektronen („Defektelektronen“, Löcher) erfolgt.

Russell S. Ohl, der seit 1927 bei den Bell Laboratories arbeitete, war überzeugt, dass die Unzuverlässigkeit der Kristall-Detektoren auf Unreinheiten in den Kristallen zurückzuführen war, und forschte dann für die Radarentwicklung an der Herstellung hochreiner Silizium-Kristalle. Dabei machte er 1940 zufällig eine für die weitere Entwicklung der Elektronik grundlegende Entdeckung. In einer Silizium-Probe fiel ihm ein Bruch zwischen zwei offensichtlich unterschiedlichen Kristallstrukturen auf. Beim Anlegen einer Spannung zeigte dieser Übergang das Verhalten einer Diode. Außerdem bildete sich beim Beleuchten mit sichtbarem Licht an der Grenzschicht eine Spannung aus. Damit hatte er einerseits den Dioden-Effekt eines (später so benannten) p-n-Übergangs und zweitens den photovoltaischen Effekt von Silizium-Dioden entdeckt (siehe auch Folge 10). Die unterschiedlichen Konzentrationen von Unreinheiten in verschiedenen Zonen eines Siliziumkristalls hatten auf einer Seite der Grenze zum Vorhandensein überschüssiger Elektronen (n-Leiter) und auf der anderen zu fehlenden Elektronen, bzw. Löchern geführt (p-Leiter).

Während die Forschung an Silizium-Reinigungs-Methoden und Silizium-Metall-Dioden für Radar-Systeme mit Hochdruck weitergeführt wurde, hielten die Bell Laboratories die Entdeckungen von Ohl bis zur Erteilung von Patenten 1946 geheim. Man war sich im Klaren, dass die militärisch motivierten, in großen Kooperationsnetzen erzielten Fortschritte nach dem Krieg zu erheblichen industriellen Entwicklungen und intensiver Konkurrenz führen würden. Der brillante William Shockley, der schon zuvor bei Bell gearbeitet hatte, konnte nach Kriegsende wieder für Bell gewonnen werden und erkannte sofort die Bedeutung der Entdeckungen von Ohl.

1947 erfanden zwei seiner Mitarbeiter, Brattain und Bardeen, auf der Grundlage der Punktkontakt-Diode den Punktkontakt-Transistor, bei dem, ähnlich wie in einer Verstärkerröhre, mit geringer Spannung an einem dritten Kontakt der Strom in der Diode geregelt werden konnte. Damit war es möglich geworden, auch mit Halbleitern Verstärker zu bauen. Wenige Monate später gelang es Shockley 1948, einen wesentlich zuverlässigeren Transistor auf der Basis von p-n-Flächenkontakten zu bauen (Feldeffekt-Transistor). Shockley, Brattain und Bardeen bekamen für die Erfindung des Transistors 1956 den Nobel-Preis. Ohl geriet weitgehend in Vergessenheit. Erst 1950 gelang Shockley eine vollständige quantenmechanische Erklärung der Vorgänge in den Halbleiterkontakten und damit auch der Photovoltaik. Die erste Solarzelle mit einem Silizium-p-n-Übergang präsentierten die Bell Laboratories 1954 (siehe Folge 10).

Mit diesen Entwicklungen, die erst aufgrund der Quantentheorie möglich geworden waren, standen zunächst neue Bauteile zur Verfügung, die die Funktionen von Elektronenröhren erfüllten, dabei wesentlich robuster, langlebiger und kleiner waren, kein Vakuumgefäß erforderten, keine Stromversorgung für die Glühkathode brauchten und wesentlich weniger Wärme abgaben. Diese Eigenschaften begründeten ihren Siegeszug in der Unterhaltungselektronik und Regelungstechnik, die weitgehend auf bewährten analogen Schaltungen beruhten.

Das Revolutionäre an dieser Technik war jedoch, dass der eigentliche Funktionsmechanismus sich in Grenzschichten abspielt, die in der Größenordnung von Atomen liegen und Gesetzen unterliegt, die nur quantentheoretisch beschreibbar sind. Das eröffnete bis dahin nicht vorstellbare Dimensionen von Miniaturisierung einerseits und Flexibilisierung andererseits – für die Leistungselektronik wird das erst in der nächsten Folge ganz deutlich. Diese neuen Möglichkeiten führten zu zwei Entwicklungssträngen, die mit Vakuumröhren nicht denkbar waren:

die Entwicklung einer „Infosphäre“ auf der Basis digitaler Elektronik

die Entwicklung einer „Elektrosphäre“ fast verlustfrei konvertierbarer Stromformen auf der Basis von Leistungs-Elektronik

Während in der alten mechanischen Welt die prozessbezogene mechanische Informationsverarbeitung noch weitgehend in die Maschinen integriert war (Sicherheitsventile, Webstuhlsteuerung, Drehzahlregler…), oder durch menschlichen Eingriff vermittelt wurde, gehen die digitalisierte Steuerung und die Leistungsströme immer eigenständigere Wege, die aber durch die gemeinsame technische Basis verknüpfbar bleiben:

Informationsverarbeitung und ihre Kopplung an unsere sinnlich erfahrbare Welt

Den ersten Entwicklungspfad, die Entwicklung digitaler Technologien und darauf aufbauend der Informatik habe ich schon in Folge 5 kurz dargestellt: Es wurden immer kleinere Transistoren gebaut, um sie als logische Schalter zu verwenden, die nicht mehr analoge Signale verstärken, sondern abstrakte mathematische Operationen durchführen. Schon die ersten Transistoren waren in ihrem Funktionskern rund tausendmal kleiner als entsprechende Elektronenröhren. In den neuesten Computerchips sind sie rund 10 Millionen mal kleiner. Voraussetzung war die Herstellung immer reinerer Kristalle – das gelang zuerst besser mit Germanium, bald aber dominierte Silizium mit seinen besseren Halbleiter-Eigenschaften. Mit der Miniaturisierung sank der Energieverbrauch pro Schaltung und die Schaltgeschwindigkeit nahm zu. Wie bereits dargestellt, entwickelte sich daraus die Computertechnik und auf dieser Basis die Informatik, die sich – dank der Erfindung von befehlsgesteuerten Mikroprozessoren weitgehend unabhängig von ihrer materiellen Grundlage – mit der Verarbeitung von Informationen beschäftigt. Die Entwicklung in den 75 Jahren seit dem ersten Transistor war nach den bisherigen Maßstäben der Technikentwicklung unvorstellbar: Der Chip in einem neuen Apple-Notebook hat heute 20 Milliarden Transistoren, die jeweils rund 50 Atome breit sind und arbeitet viele parallele Aufgaben mit einer Taktfrequenz von 3,5 Milliarden pro Sekunde (GHz) ab.

Interessant im Zusammenhang mit der Energietechnik ist die Möglichkeit, mit einem solchen Computer nicht nur Informationen zu verarbeiten, sondern diese universale Informationsverarbeitung ohne menschliche Vermittlung auch direkt an technische Prozesse anzukoppeln. Das wurde dadurch möglich, dass Transistoren (Im Gegensatz zu Bleistiften, Büchern, Rechenschiebern) mit elektrischer Energie operieren und sowohl analoge als auch digitale Signale verarbeiten können:

Als man mit Mikroprozessoren immer schneller und billiger rechnen konnte, wurde es attraktiv, analoge Messwerte in Zahlen umzuwandeln und digital zu auszuwerten. So werden zum Beispiel seit den achtziger Jahren Töne vorwiegend digital verarbeitet: Die sich mit der Schallschwingung verändernde Ausgangsspannung eines Mikrophons wird mit einem Analog-Digitalwandler in kleinsten Schritten (Abtastfrequenz) gemessen, und in Zahlenwerte umgewandelt, die im dualen Zahlensystem (das nur Nullen und Einsen kennt), also „digital“ ausgedrückt werden. In dieser Form können sie effizient gespeichert und informationstechnisch verarbeitet werden. Auf ähnliche Weise werden heute alle denkbaren Messgrößen und Signale in informationstechnisch verarbeitbare Codes verwandelt. Die Vielfalt der Sensoren nimmt laufend zu.

Umgekehrt können die Ergebnisse der digitalen Verarbeitung als immer vielfältigere analoge Größen in unserer realen, materiellen Welt ausgegeben werden: Als Töne, Bilder, mechanische Bewegung, Wärme, Strahlung… Dazu werden zunächst die digitalen Signale in elektrischen Strom übersetzt, der dann mit Energiewandlern (Lautsprechern, Bildschirmen, Scheinwerfern, Motoren, Heizungen) ganz reale Veränderungen in unserer sinnlich erfahrbaren Welt bewirken kann. Dabei kommt der zweite Entwicklungsstrang ins Spiel, der sich aus der Halbleitertechnik ergeben hat: die halbleiterbasierte Leistungselektronik.

Leistungselektronik mit Halbleitern

Die Entwicklung der Leistungselektronik mit Halbleiter-Grenzschichten kam deutlich langsamer voran als die der Mikroelektronik. Das hatte erstens einen technischen Grund: Unerwünschte Fremdatome in den Halbleiterkristallen haben wegen der Größe der Bauteile und der hohen Stromstärken wesentlich gravierendere Folgen als in winzigen Logik-Transistoren. Es dauerte einige Jahre, bis man Kristalle ausreichender Reinheit herstellen konnte. Vermutlich wichtiger war der zweite, ökonomische Grund: Die Leistungselektronik wurde viele Jahrzehnte mit wesentlich weniger Aufwand vorangetrieben. Bei der Mikroelektronik schafften Unternehmen aus der Nachrichtentechnik (Bell, Telefunken, RCA, CSF, Sony…) und neue Unternehmen (Fairchild, National Semiconductor, Intel…) ganz neue Märkte mit faszinierenden Aussichten. 1962 wurden allein in den USA 250 Millionen Transistoren produziert, die damit erstmals die Elektronenröhren überholten. Der Umgang mit starken Strömen hingegen war weithin etabliert, von wenigen großen Unternehmen besetzt (General Electric, Brown-Boveri, ASEA, Siemens, Toshiba…), die nur geringe Stückzahlen produzierten. Sie versprachen sich nur überschaubare Vorteile von den neuen Technologien, aber sie waren es, die neue Arbeitsgruppen aufbauten, um mit Halbleitern die Leistungselektronik weiterzuentwickeln – ohnehin expandierten einige von ihnen in die Signal-Elektronik.

1952 präsentierte General Electric die ersten kommerziellen Germanium-Dioden, mit denen Gleichrichter für Leistungen von 25 kW gebaut werden konnten. Bald waren mit Silizium wesentlich höhere Leistungen erreichbar. Ab 1957 wurden in mehreren Ländern Lokomotiven mit Silizium-Gleichrichtern gebaut, ab 1962 serienmäßig, ab 1965 waren Silizium-Dioden den bisherigen Techniken in allen Bereichen überlegen. Aber Dioden konnten den Strom nicht steuern.

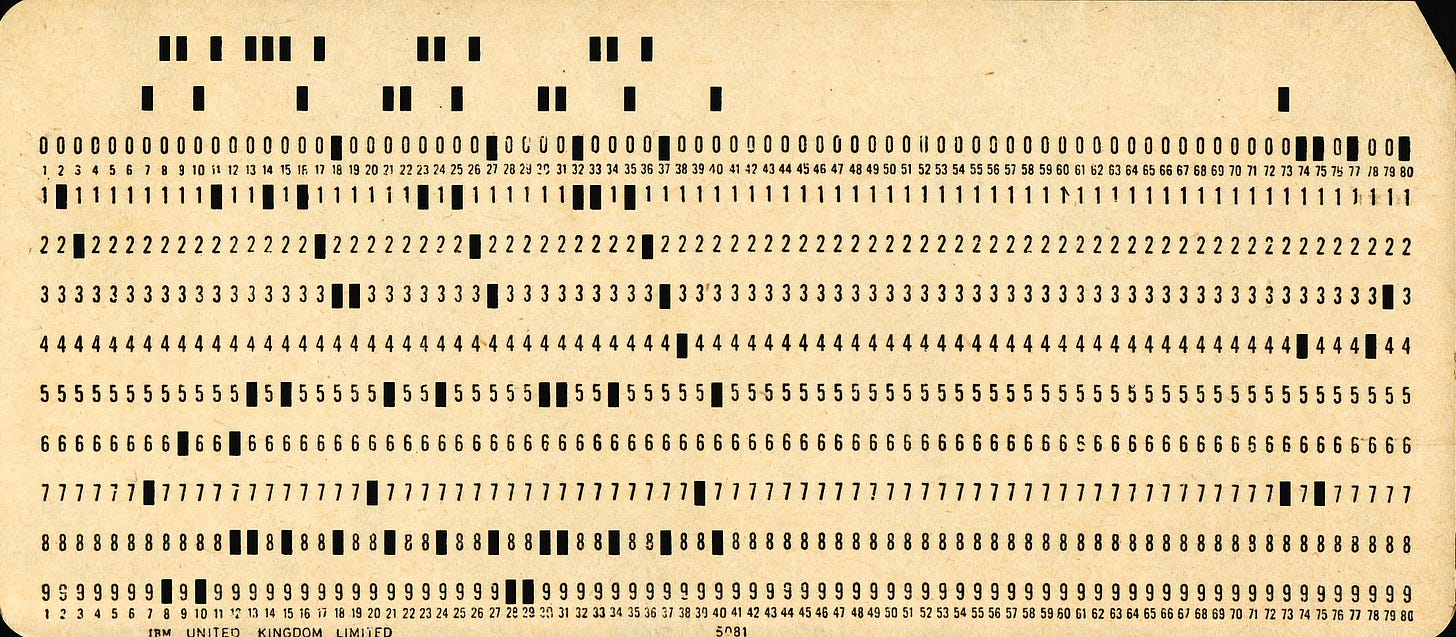

1957, zehn Jahre nach der Erfindung des Transistors, wurde der erste Thyristor gebaut, der – genau wie das Quecksilber-Ignitron – über den verzögerten Start des Stromflusses in jeder Halbwelle des gleichgerichteten Wechselstroms („Phasenanschnitt“ , siehe Abbildung oben) die Leistung steuern konnte. Ein Jahr später konnten damit schon 5 kW geschaltet werden. 1967 wurde die erste Lokomotive mit Thyristoren ausgeliefert. 1967-70 wurde die erste Hochspannungs-Gleichstrom-Übertragung (HGÜ, mehr dazu später) in Schweden damit ausgerüstet.

So ersetzte in den sechziger und siebziger Jahren die Halbleiter-Technik von Silizium-Dioden und Thyristoren weitgehend die Quecksilber-Technik der Quecksilber-Dioden, Thyatrons und Ignitrons. Die Halbleiter-Technik erlaubte es billigere, kleinere und robustere Bauelemente für die gleichen Aufgaben zu bauen. Damit wurde es möglich, immer raffiniertere Schaltungen zu entwickeln. Doch die Anwendungsbereiche der Leistungselektronik blieben die gleichen: Gleichrichten und Leistungssteuerung durch Phasenanschnitt.

Der große Sprung zum universalen Stromwandler

Es dauerte viele Jahre, bis Transistoren, die als Schlüsselbausteine in digitalen logischen Schaltungen und in analogen Signalverstärkern einen beispiellosen Boom erlebten, auch für die Leistungselektronik zur Verfügung standen. Als ab Mitte der siebziger Jahre verschiedenartige Leistungs-Transistoren (erst MOSFETS, dann IGBTS, sowie weitere Varianten) für immer größere Leistungen verfügbar wurden, erweiterte das die Rolle der Leistungselektronik ganz grundlegend.

Mit den Leistungs-Transistoren entstand die Möglichkeit, Strom von mehreren Kilowatt extrem schnell zu schalten und diesen Schaltvorgang mit digitalen Signalen zu steuern. Für sehr hohe Leistungen wurden sie auch mit Thyristor-Varianten kombiniert. Es wurden immer raffiniertere Halbleiter-Bauelemente für unterschiedliche Anwendungen entwickelt, deren Eigenschaften immer weiter verbessert und mit unterschiedlichen Prioritäten optimiert wurden: möglichst hohe Sperrspannung / möglichst hoher Durchlassstrom / möglichst kleiner Innenwiderstand in Durchlassrichtung / möglichst hohe Schaltfrequenz / möglichst kleine Baugröße /möglichst niedrige Kosten.

Damit gelang es endlich, nicht nur Wechselstrom (AC) in Gleichstrom (DC) zu verwandeln, sondern auch aus Gleichstrom fast sinusförmigen Wechselstrom zu erzeugen, und das mit in immer weiteren Grenzen frei wählbaren Frequenzen: Dazu wird – ganz ähnlich wie beim digitalen Abtasten und Wiedergeben von Schallfrequenzen – eine Folge hochfrequenter Rechteckimpulse unterschiedlicher Höhe zu einer Sinuskurve zusammengesetzt. Kurz gesagt, der Gleichstrom wird fein zerhackt und anders wieder zusammengefügt. Damit standen für immer größere Leistungs- und Frequenzbereiche rein auf Halbleiterbasis folgende neue Funktionen zur Verfügung:

digital steuerbare Schalter

Gleichrichter mit digital steuerbarer Leistung (AC/DC-Umrichter)

Wechselrichter mit digital steuerbarer Frequenz und Leistung (DC/AC-Umrichter)

Diese Funktionen lassen sich zu verschiedenen Stromrichtern (power converters) kombinieren, die es erlauben, alle wesentliche Parameter elektrischen Stroms (Stromart, Spannung, Stromstärke, Frequenz) digital gesteuert mit sehr geringen Verlusten den jeweiligen Anforderungen anzupassen.Frequenzwandler z.B. lassen sich dadurch realisieren, dass Wechselstrom zunächst in Gleichstrom und dann wieder in Wechselstrom anderer Frequenz gewandelt wird. Damit können elektrische Systeme in bis dahin ungekanntem Ausmaß effizient und flexibel gestaltet werden.

Die kaum bekannten Wunder der hohen und steuerbaren Frequenzen

Die wohl bedeutendste Neuerung der Leistungs-Transistoren liegt darin, dass damit die Frequenz von Wechselstrom zu einer ganz zentralen Eigenschaft wird: Erstens kann damit auch bei großen Leistungen die Frequenz sehr weit herauf- und auch wieder heruntergesetzt werden, und zweitens sind diese Frequenzen digital steuerbar. Das ist vor allem überall dort von Bedeutung, wo elektrischer Strom in Magnetfelder umgewandelt wird. Ich will hier zwei Anwendungen beleuchten, wo das besonders weitreichende Konsequenzen hat: Transformatoren und Elektromotoren.

Bis zu haushohe Transformatoren spielen seit ihrer Erfindung eine zentrale Rolle in elektrischen Versorgungsnetzen und sind ein wichtiger Kostenfaktor (siehe Folge 12). Sie können Wechselspannung herauf- und gleichzeitig die Stromstärke herabsetzen (und umgekehrt) um in Hochspannungsleitungen Leitungsverluste (die von der Stromstärke abhängen) zu verringern. Der Transformator speichert die Energiemenge einer elektrischen Schwingungsperiode in einem Magnetfeld, bevor er sie wieder abgibt. Deshalb brauchen größere Leistungen größere Transformatoren.

Hier setzt nun die Leistungselektronik an: Je höher die Frequenz des Wechselstroms ist, desto kleiner ist bei gleicher Leistung der Energiegehalt einer Schwingung und es reicht ein kleinerer Transformator. Wenn der Wechselstrom (AC) anstatt mit 50 Hertz mit 50 Kilohertz schwingt, dann beträgt die im Transformator magnetisch zwischengespeicherte Energie nur ein Tausendstel. Dadurch kann die Baugröße nicht nur des Transformators, sondern auch der in den Schaltungen verwendeten Kondensatoren und Spulen, drastisch reduziert werden.

In Elektromotoren muss sich das elektrisch erzeugte Magnetfeld je nach Position der beweglichen Magneten ändern. Dafür wird der Strom beim klassischen Gleichstrommotor mit einem Schleifkontakt mechanisch umgepolt. Beim wesentlich effizienteren Drehstrommotor (siehe Folge 12) erfolgt die Änderung durch die Schwingungen des Drehstroms. Bei einer direkten Versorgung durch das Netz ist er damit auf eine durch die Netzfrequenz bestimmte Drehzahl festgelegt. Mit Leistungselektronik kann nun aber die Frequenz und damit die Drehzahl des Motors und seine Leistung stufenlos und präzise geregelt werden – bis hin zur präzisen Positionierung. (Bei Generatoren wirkt der gleiche Mechanismus umgekehrt: Die Stromschwingung eilt der Bewegung nicht voraus, um sie zu beschleunigen, sondern hinterher, um sie zu bremsen). Zudem sinkt mit hohen Frequenzen (analog zum Transformator) die notwendige Motorgröße. Beide Effekte zusammen ermöglichen in der Praxis – wie wir noch sehen werden – eine erhebliche Flexibilität und Effizienzsteigerung bei der Umsetzung von elektrischer in mechanische Energie – und umgekehrt.

Der Einsatz von Halbleiter-Leistungselektronik ermöglicht also im Vergleich zu vorangehenden Technologien nicht nur eine fast grenzenlose Flexibilität bei der Umwandlung zwischen verschiedenen Arten von Strom, sondern eröffnet auch ganz neue Möglichkeiten für eine drastische Miniaturisierung und erhebliche Verbesserungen der Effizienz.

Mit der Entwicklung der Leistungstransistoren stand somit ab den neunziger Jahren eine Technologie zur Verfügung, die mit immer kleineren Geräten ganz unabhängig von mechanischen Vorrichtungen und digital steuerbar einen äußerst flexiblen Umgang mit elektrischer Energie erlaubt. Ohne sie wäre der Abschied von fossilen Brennstoffen kaum denkbar. In der nächsten Folge werden wir sehen, wie sich diese Neuerungen seither praktisch auswirken. Insbesondere seit der Jahrtausendwende hat die Entwicklung, Miniaturisierung und Verbreitung der Leistungselektronik eine atemberaubende Beschleunigung erfahren. Erzeugung, Transport, Speicherung und Nutzung von Strom werden dadurch wesentlich flexibler und effizienter. Damit wird Elektrizität zur flexiblen Universal-Energie.