Die Anfänge der modernen Materialwissenschaften

Geschichte der Energietechnik – Die Entdeckung der Nanowelten ermöglicht eine erneuerbare Energieversorgung für Alle (17)

Die Entwicklung der Materialwissenschaften hat uns durch diese ganze Serie begleitet. Aber um die Bedeutung neuer Batterien und weiterer neuer Technologien zu verstehen, ist es notwendig, ein wenig tiefer in diese Geschichte einzutauchen.

Am Anfang des zwanzigsten Jahrhunderts erschütterten neue physikalische Erkenntnisse zur Natur der Materie das naturwissenschaftliche Weltbild: Die Phänomene unserer Alltagswelt entpuppten sich als statistisches Ergebnis von seltsamen Vorgängen in einer Welt von Atomkernen, Atomhüllen und ihren Verbindungen. Energie und Materie sind nicht verschiedene Dinge, sondern nur verschiedene Betrachtungsweisen.

Anfangs konzentrierte sich das Interesse auf die Atomkerne, die gewaltigen Kräfte, die dort herrschen und die noch kleineren, sie konstituierenden Teilchen: Mit Atombomben unvorstellbarer Vernichtungskraft rüsteten sich die großen Mächte zur „mutually assured distruction“, mit der Zähmung der Kernkräfte in spektakulären Kraftwerken hoffte man alle Energieprobleme zu lösen, mit riesigen Teilchenbeschleunigern, die letzten Geheimnisse der Natur zu ergründen.

Viel folgenreicher für unsere Welt erwies sich aber, wie die aus Elektronen bestehenden Atomhüllen miteinander in Verbindung treten können: Das genauer zu verstehen, entpuppte sich als Schlüssel zum Erklären der verwirrenden Vielfalt unserer Welt, und zur Entdeckung ganz neuer Möglichkeiten. Neben den klassischen Naturwissenschaften entdeckte eine hybride Materialwissenschaft, die sich mit komplexen, großen Atomverbünden befasst, in den Nanowelten ganz neue Perspektiven für technische Systeme – gerade auch für einen viel nachhaltigeren Umgang mit Energie.

Ausgehend von der Entwicklung der klassischen Batterien haben wir in der letzten Folge gesehen, wie die Elektrochemie und allgemeiner die Chemie im neunzehnten Jahrhundert riesige Fortschritte gemacht und sich immer mehr der Frage genähert haben, wie das makroskopische Verhalten verschiedener Substanzen durch Eigenschaften kleinster Teilchen zu erklären ist. Im Anschluss daran soll es nun um die Entwicklung der quantentheoretisch fundierten Materialwissenschaften gehen – ausführlicher als in früheren Folgen und diesmal aus der Perspektive der Batterieentwicklung. Die besondere Rolle der neuen Wissenschaften von den festen Materialien ist uns schon bei der Photovoltaik, der Mikroelektronik und der Leistungselektronik begegnet. Die erst seit etwa 1980 verstärkt einsetzende Entwicklung neuartiger Batterien ist damit eng verwandt, aber setzte noch weitere Fortschritte in den Materialwissenschaften voraus.

Meine Artikelserie zur Geschichte der Energietechnik:

Die Entdeckung der Nanowelten ermöglicht eine erneuerbare Energieversorgung für Alle

Die bisherigen Folgen:

Kernspaltung: Frühe, verführerische Frucht einer wissenschaftlichen Revolution

Wo die sinnliche Erfahrung versagt: Neue Methoden erlauben die Entdeckung von Nano-Welten

Virtuelle Welten auf Siliziumbasis: Nanowissenschaften revolutionieren die Informationstechnik

Die Entzauberung des biologischen Informationssystems – kein dauerhafter Beitrag zur Energietechnik

Die Geschichte der fossilen Energieversorgung, Grundlage der Industrialisierung

Die Klimakrise stellt die industrielle Zivilisation in Frage: Welche Optionen haben wir?

Dank Nanowissenschaften: Strom direkt aus Sonnenlicht wird unschlagbar günstig

PV: Zunehmende Kostenvorteile durch nanotechnische Dematerialisierung

Big was beautiful — Wie die Dampfkraft unsere Institutionen geprägt hat

Umbau des Stromsystems seit 50 Jahren – Von der Zentrale zum Netzwerk

Emanzipation von der Mechanik – der lange Weg zur modernen Leistungselektronik

Leistungselektronik macht Elektrizität zur flexiblen Universal-Energie

Klassische Batterien und die Entwicklung der (Elektro-)Chemie

In dieser Folge geht es um die Entdeckung der Quantenstruktur der Materie, die Entwicklung der Quantenchemie und die Entwicklung der Materialwissenschaften bis etwa 1970. Die nächste Folge wird dann beleuchten, wie die damit geschaffenen Voraussetzungen zusammen mit den Fortschritten der Computertechnik und den veränderten gesellschaftlichen Anforderungen in der Lage waren, die Quantentheorie für Fragen der Materialwissenschaften nicht nur allgemein konzeptionell, sondern ganz praktisch so brauchbar zu machen, dass ganz neue Materialien und Prozesse entwickelt werden konnten. Erst daraus ergibt sich dann, welch riesigen Schritt die Lithium-Ionen-Batterien darstellen und welche Entwicklungen wir auf dieser Grundlage noch erwarten können.

Elektrizität und Materie: mit der Quantentheorie erschließt sich die Struktur der Atome

Wie in der letzten Folge beschrieben, hatte die Chemie am Ende des neunzehnten Jahrhunderts einen schnell wachsenden Erfahrungsschatz chemischer Messergebnisse und Methoden und mit dem periodischen System der Elemente eine überzeugende Systematik, die die Herstellung vieler neuer Substanzen und den Aufbau einer immer mächtigeren Industrie erlaubten. Warum chemischen Bindungen zustande kommen, war allerdings noch nicht verstanden. Man vermutete, dass sich Atome zu Molekülen verbinden, aber was Atome sind, war unklar.

Aus der Elektrochemie war bekannt, dass viele chemische Bindungen etwas mit elektrischen Ladungen zu tun haben. Maxwell hatte 1864 mit seinen Gleichungen die klassische Elektrodynamik zu ihrem Abschluss gebracht. Aber zunächst ergaben sich daraus noch keine Konsequenzen für die Welt der Atome und Moleküle. Gegen Ende des Jahrhunderts machte man jedoch zunehmend irritierende Beobachtungen bei den Wechselwirkungen zwischen elektromagnetischer Strahlung – zu der auch das sichtbare Licht gehört – und Materie.

Physikalische Experimente mit radioaktiver Strahlung und Röntgenstrahlen führten zu genaueren Erkenntnissen über Atome: 1897 wies Joseph J. Thomson nach, dass negativ geladene Elektronen als eigenständige Elementarteilchen existieren. Ernest Rutherford stellte dann durch Streuexperimente fest, dass der größte Teil der Masse von Atomen in einem kleinen Kern konzentriert ist und entwarf 1911 das Planeten-Atommodell, in dem Elektronen um einen kleinen schweren Atomkern kreisen – Thomson war noch davon ausgegangen, dass Elektronen wie Rosinen in eine Art positiv geladenen Pudding eingebettet sind und gegebenenfalls herausgelöst werden können. Dass die scheinbar solide Materie vor allem aus Zwischenräumen bestand, war eine beunruhigende Vorstellung, denn der Radius der Kerne beträgt nur etwa ein Hunderttausendstel des Radius der entsprechenden Atome. Immerhin, das konnte man sich noch mechanisch vorstellen. Aber es gab einen Widerspruch: kreisende Ladungen müssten nach Maxwells elektrodynamischen Gesetzen zu einer Abstrahlung von Energie und zu einem Kollaps der Atome führen.

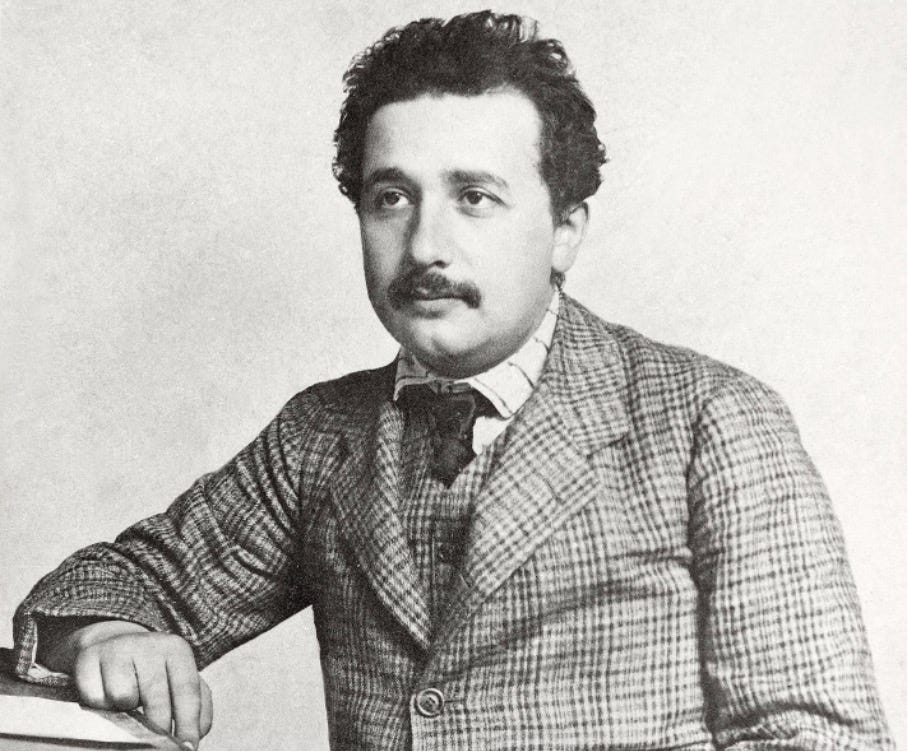

Schon im Jahr 1900 war allerdings Max Planck bei der Beschäftigung mit Spektrallinien der Wärmestrahlung „in einem Akt der Verzweiflung“ zum Schluss gekommen, dass sich die Messergebnisse nur dann mathematisch beschreiben lassen, wenn man voraussetzt, dass die Strahlungsenergie lediglich Werte annehmen kann, die das Vielfache eines „Wirkungsquantums“ betragen. Die Brisanz dieses Ergebnisses wurde erst 1905 klar, als Einstein zur Erklärung des Photoeffekts die Hypothese aufstellte, man könne Licht und allgemeiner elektromagnetische Strahlung auch als Teilchenstrom betrachten. Damit verließ er den Boden der klassischen Elektrodynamik, mit deren abschließender mathematischen Darstellung erst dreißig Jahre früher Maxwell den lange schwelenden Streit, ob Licht aus Korpuskeln oder Wellen bestehe, zugunsten der Wellen beendet hatte. Zudem zeigte Einstein, dass die damals noch nicht erklärte, unter dem Mikroskop in Flüssigkeiten zu beobachtende unregelmäßige Bewegung kleinster Teilchen tatsächlich ein experimenteller Nachweis für die Existenz von Atomen ist. Bis dahin hielten viele Wissenschaftler Atome eher für ein nützliches Konzept als für eine Realität. Mit diesen Erkenntnissen (und der im gleichen Jahr vorgestellten speziellen Relativitätstheorie) hatten Planck und Einstein eindeutig die klassische Physik hinter sich gelassen. Licht schien gleichzeitig Korpuskel und Welle zu sein. Das war allen Beteiligten unheimlich.

Acht Jahre später gelang es Niels Bohr mit seiner Arbeitsgruppe in Kopenhagen, die damals bekannten Eigenschaften des Wasserstoffatoms dadurch zu erklären, dass er in seinem Atommodell annahm, dass Elektronen – in Analogie zur Planck-Einsteinschen Quantelung elektromagnetischer Strahlung – ebenfalls nur bestimmte Energiezustände einnehmen können, und in entsprechenden, klar definierten Bahnen um den Atomkern kreisen. Die beobachtete Emission und Absorption von Licht mit je nach Atom klar unterscheidbaren Wellenlängen (Spektrallinien) wurde den Energieniveaus der Elektronenbahnen zugeordnet.

Der nächste entscheidende Schritt war 1924 Louis de Broglies Theorie der Materiewellen: er stellte die These auf, dass nicht nur die masselosen Photonen (Lichtpartikel) als Wellen dargestellt werden können, sondern auch die massebehafteten Elektronen. Damit leuchtete ein, dass nur bestimmte Elektronenbahnen möglich waren, auf denen sich die Wellen nicht durch Überlagerung auslöschten. Diese Theorie erlaubte es jedoch nicht, die beobachteten Spektren der Atome zu berechnen – es war die letzte der „älteren“ Quantentheorien.

Die Grundlagen der „Quantenmechanik“, die sich grundlegend von der klassischen Mechanik unterschied, diese jedoch als Grenzfall umfasste, wurden dann zwischen 1925 und 1928 in enger Zusammenarbeit eines europäischen Netzwerks von Physikern erarbeitet. Zu diesem Netzwerk, das seine Schwerpunkte in München, Göttingen und Kopenhagen hatte, gehörten vor allem Werner Heisenberg, Erwin Schrödinger, Max Born, Pascual Jordan, Wolfgang Pauli, Niels Bohr und Paul Dirac, die alle außer Jordan in den folgenden Jahren den Nobelpreis für Physik bekamen.

Mit dem Grundsatz, nur beobachtbare Größen zu verwenden, und mit neuen mathematischen Methoden formulierten Heisenberg, Born und Jordan 1925 zunächst die Matrizenmechanik, Schrödinger dann 1926 die äquivalente, aber elegantere Schrödinger-Gleichung. 1927 wurde die bis heute gültige „Kopenhagener Interpretation“ der Quantenmechanik formuliert. Sie umfasst unter anderem die 1926 von Born vorgeschlagene Interpretation der Wellenfunktion als Wahrscheinlichkeit des Aufenthaltsortes eines Teilchens. Diese Sichtweise führte zu intensiven Diskussionen. Einstein konnte sie lange nicht akzeptieren („Gott würfelt nicht“). Schließlich gelang es dann 1928 Paul Dirac, die Schrödinger-Gleichung so zu erweitern, dass sich auch mit Einsteins spezieller Relativitätstheorie vereinbar war (Dirac-Gleichung), und konnte dadurch wichtige Phänomene des Verhaltens von Elektronen und Feinheiten der Wasserstoffspektren erklären.

Damit war die vollständige Basis für die Quantenwissenschaften gelegt. Das Problem war nur, dass die anspruchsvollen Gleichungen mit den damals zur Verfügung stehenden Mitteln nur mit vereinfachenden Annahmen für ganz spezielle Fälle gelöst werden konnten.

Im Schatten der Kernphysik: die Quantenchemie löst das Rätsel der chemischen Bindungen

In einem schnellen Ritt haben wir hier – von chemischen Fragestellungen herkommend – noch einmal die bereits in der ersten Folge unserer Serie beschriebene Entstehung der Quantentheorie skizziert. In den ersten Jahren erregte sie vor allem wegen ihrer tiefgreifenden philosophischen Implikationen Aufsehen: Die gähnende Leere der subatomaren Räume, die Welle-Korpuskel-Dualität, die Unmöglichkeit, Position und Impuls von Teilchen gleichzeitig genau zu bestimmen, die Auflösung der Kausalitäten unserer Makro-Welt in statistische Ergebnisse von Zufälligkeiten im Nano-Bereich… all das widersprach der menschlichen Erfahrung in der Makrowelt, löste Verunsicherung aus und war in seinen Konsequenzen nicht überschaubar.

Schnell wollte man weiter vordringen und die Beschaffenheit des Atomkerns genauer verstehen. Das führte, wie wir gesehen haben, gerade auch vor dem Hintergrund des aufziehenden und dann einsetzenden zweiten Weltkriegs, zur Faszination durch die bis dahin unvorstellbaren Kräfte, mit denen man es im Atomkern zu tun hatte, zur Kernphysik, zum Bau der Atombombe, zum Versuch, die Energieprobleme der Menschheit mit Kernspaltung und Kernfusion zu lösen. Atombombe, Kernenergie, die Erkundung immer seltsamerer Teilchen sowie der Versuch, eine Weltformel zu finden, die alle physikalischen Phänomene in einer einheitlichen Theorie erklären kann, prägten das Bild der modernen Physik in der Öffentlichkeit.

Viel weniger beachtet aber wurden zunächst die Konsequenzen der neuen Physik für die (aus Elektronen bestehende) Atomhülle, für die Bindungen zwischen Atomen, für die empirischen Wissenschaften von Kristallen und Metallen, für die Chemie. Die hier spielenden Kräfte und Energien waren weit weniger spektakulär.

Für das Wasserstoff-Atom, das nur ein Elektron hat, kann die Schrödinger-Gleichung exakt (analytisch) gelöst werden: Aus den anschaulichen Kreisbahnen (orbits), in denen die Elektronen in Rutherfords Atommodell um den Atomkern kreisen, sind in der Quantentheorie sogenannte Orbitale (orbitals) geworden, die man als Aufenthaltswahrscheinlichkeiten interpretiert. Die Orbitale unterscheiden sich durch vier Quantenzahlen und lassen sich damit den Unterschalen und Schalen des Bohrschen Atommodells zuordnen. Weil Mehrfachbesetzungen ausgeschlossen sind, füllen bei größeren Atomen die Elektronen die Schalen systematisch an – auch wenn die exakten Resultate für das Wasserstoffatom bei größeren Atomen nicht mehr ganz stimmen. Trotzdem erklärt die Ordnung in Schalen qualitativ die Eigenschaften des Periodischen Systems der Elemente, woraus sich ergibt, dass vor allem die Elektronen der äußersten Schale (Valenzelektronen) an chemischen Bindungen beteiligt sind.

Die Schwierigkeit, und auch das Unattraktive der Anwendung der Quantentheorie auf chemische Bindungen war, dass die Schrödingergleichung zwar schöne Resultate für das Wasserstoffatom und ganz brauchbare auch noch für größere Atome lieferte, aber für mehrere Atome nicht mit mathematisch-analytischen Methoden zu lösen war. Dafür mussten vereinfachende Annahmen getroffen werden.

Den Anfang machten Walter Heitler und Fritz London in Zürich, indem sie 1927 mit quantenmechanischen Methoden das Wasserstoff-Molekül untersuchten: das denkbar einfachste Molekül mit zwei Atomkernen und zwei Elektronen. Ihr Ansatz wurde von den amerikanischen Chemikern John Slater und Linus Pauling zur Valence-Bond-Methode erweitert.

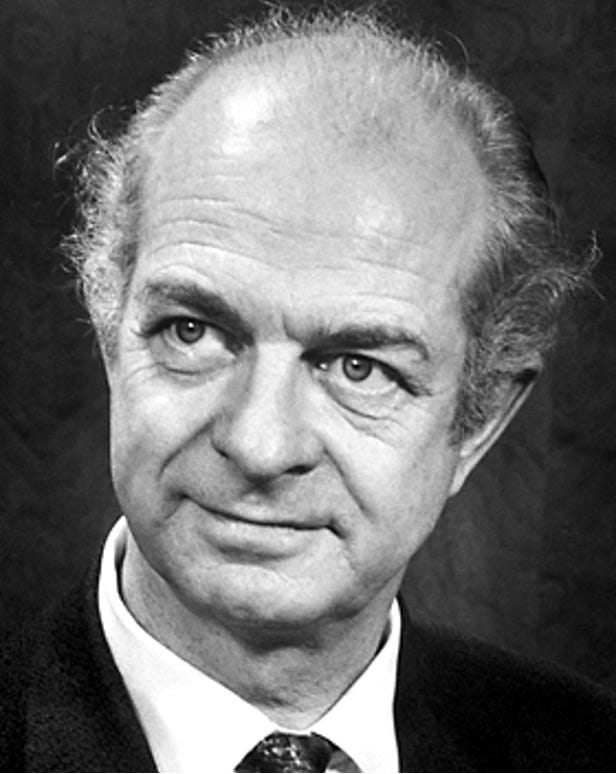

Linus Pauling, der zwei Jahre bei den Pionieren der Quantentheorie in Europa verbracht hatte, zeigte 1931 auch für organische Moleküle, dass mehrere Atomorbitale zu Molekülorbitalen hybridisieren: die abwechselnd einfachen und doppelten Bindungen in Kekulés Benzolring entpuppten sich als ein gleichförmiger Ring. Mit seinem einflussreichen Buch „The Nature of the Chemical Bond and the Structure of Molecules and Crystals” gilt Pauling als der eigentliche Begründer der Quantenchemie. Der in mehreren Gebieten außerordentlich produktive Forscher erhielt für seine Arbeiten zur chemischen Bindung 1954 den Nobel-Preis für Chemie und 1962 für seinen Einsatz gegen Atombombentests den Friedensnobelpreis.

Während die Valence-Bond-(VB)-Methode sich auch in größeren Molekülen auf Bindungen durch Elektronenpaare zwischen je zwei Atomen konzentriert, und damit traditionellen Vorstellungen von chemischer Bindung recht nahe ist, geht die 1929 von Friedrich Hund und Robert Mulliken vorgestellte Molecular-Orbital-(MO)-Methode von Wellenfunktionen über das gesamte Molekül aus. Beide Ansätze sind äquivalent und kommen im Grenzfall zu identischen Ergebnissen, je nach Fragestellung eignen sie sich jedoch mit ihren unterschiedlichen Näherungsansätzen mehr oder weniger gut. Zunächst war die VB-Methode populärer, dann hat die MO-Methode an Bedeutung gewonnen, vor allem seit immer größere Rechenleistungen für die numerische Lösung von Wellengleichungen zur Verfügung standen.

Tatsächlich hat es lange gedauert, bis die Quantentheorie in der Chemie eine wichtige Rolle gespielt hat. Weil man mit anderen Methoden, Daumenregeln und klassischen Theorien begrenzter Reichweite gut zurechtkam, wurden die neuen Theorien vor allem in der organischen Chemie weitgehend ignoriert. In der maßgeblichen Datenbank für wissenschaftliche Publikationen in der Chemie, „SciFinder“, fängt die Zahl der jährlichen Veröffentlichungen mit dem Schlagwort „quantum“ erst in den sechziger Jahren an, signifikant zu steigen: 1960 gut achthundert, 1980 über sechstausend, 2020 fast sechzigtausend. Entscheidend für die Wende waren ab 1965 die quantenmechanische Erklärung von bis dahin rätselhaften Phänomenen bei der räumlichen Konfiguration von komplexen organischen Molekülen (Woodward-Hoffmann-Regeln), und dann vor allem die schnell wachsenden Möglichkeiten, mit Computern numerische Lösungen für die Wellengleichungen zu finden.

Computational Chemistry — der Begriff tauchte erstmals 1970 auf — ist heute zu einem unentbehrlichen quantentheoretisch begründeten Werkzeugkasten der chemischen Forschung geworden. Dazu gehören inzwischen nicht nur numerische Methoden zur Lösung von Wellengleichungen und Dichtefunktionen, sondern auch riesige Datenbanken, die das empirische und theoretische Wissen von zweihundert Jahren chemischer Forschung beinhalten und deren Auswertung mit Hilfe von künstlicher Intelligenz. Wie rasant damit die Forschung beschleunigt wird, illustriert eine der Erfolgsmeldungen der letzten Monate: Die 2020 publizierte Google-Software AlfaFold2 konnte bereits die räumliche Struktur von größeren Proteinen berechnen. Das jetzt veröffentlichte AlfaFold3 kann ausgehend von der Sequenz von Aminosäuren die Struktur von RNA und DNA berechnen, sowie die Interaktion aller bekannten Bio-Moleküle abschätzen – die dazugehörige Datenbank kennt über 200 Millionen Strukturen. Sie wird weltweit vor allem für die pharmazeutische Forschung intensiv genutzt.

Am Horizont erscheint jetzt zudem die Möglichkeit, quantenchemische Berechnungen mithilfe von Quantencomputern extrem zu beschleunigen. Diese sind nicht nur generell bei vielen Problemen wesentlich schneller als herkömmliche Superrechner – speziell für quantentheoretische Probleme ermöglichen sie durch ihre Funktionsweise auch ganz neue, den Problemstellungen besser angepasste Berechnungsmethoden.

Vom Handwerk zur systematischen Werkstoffkunde

Chemiker beschäftigen sich vor allem mit den Eigenschaften und Umwandlungen von gasförmigen und flüssigen Stoffen — damit, wie Atome sich zu Molekülen verbinden und dabei neue Stoffe mit anderen Eigenschaften entstehen. Feststoffe sind größere Verbünde von Atomen oder Molekülen, die den Methoden der Chemie nur teilweise zugänglich sind: Kristalle, Kristallverbünde, nichtkristalline Zusammenballungen von Molekülen wie Glas oder Plastik — großräumigere, oft kompliziertere Strukturen als Moleküle. Deren Eigenschaften mit quantentheoretischen Methoden zu erklären, ist noch einmal deutlich schwieriger als bei Molekülen.

Seit Menschen Werkzeuge verwenden, haben sie sich mit Werkstoffen beschäftigt. Zunächst waren es vorfindbare Materialien: Holz, Steine, Felle, Häute, Knochen… Dann lernten sie mit chemischen Prozessen und Wärmebehandlung aus Rohstoffen raffiniertere Werkstoffe herzustellen: Leder aus Häuten, Ziegel aus Lehm, Glas aus Sand, Keramik aus Mischungen von Mineralien. Dann gelang es, aus Erzen Metalle und Metalllegierungen herzustellen, nach manchen von denen später ganze Zeitalter benannt wurden: Kupfer, Gold, Silber, Zinn, Blei, Bronze. Eisen wurde in Europa ab ca. 800 vor unserer Zeitrechnung hergestellt. Durch Erhitzen, mechanische Bearbeitung (Schmieden) und verschiedene Zusätze gelang es mit zunehmender Erfahrung, immer bessere Eisensorten und Stähle herzustellen. Vor allem seit den Anfängen der Industrialisierung standen Metalle im Mittelpunkt des Interesses an Werkstoffen.

Erst ab Mitte des 19. Jahrhunderts wurden die Eigenschaften und die chemischen Zusammensetzungen von Eisen, Stahl, Leichtmetallen (Aluminium) und Keramik systematisch untersucht. In der damit entstehenden Werkstoffkunde spielte die makroskopisch-empirische Metallurgie eine zentrale Rolle. Für die industrielle Herstellung von Dampfkesseln, verlässlichen Maschinen und immer größeren Stahlkonstruktionen für Brücken und Hochhäuser wurde es unerlässlich, die Qualität von Materialien und insbesondere von Stahl durch Charakterisierung nach einheitlichen Kriterien sicherzustellen. Dazu wurden in vielen Ländern staatliche Materialprüfungsanstalten gegründet — so 1879 in Zürich, 1884 in Stuttgart. Neben Analysen der chemischen Zusammensetzung und der Untersuchung der mechanischen Eigenschaften (Härte, Dichte, Bruchfestigkeit etc.) spielten mikroskopische Untersuchungen von Metallschliffen eine zunehmende Rolle.

Ein Durchbruch zu einem atomistischen Verständnis von Metallen war 1912 die Entdeckung Max von Laues, dass Kristalle Röntgenstrahlen beugen können und die darauf folgende Bestimmung der Struktur vieler einfacher Kristalle durch William und Lawrence Braggs.

Die Erforschung der Struktur von Kristallen und die Hypothese, dass es Atome geben müsse, hatten die Menschen seit dem Altertum beschäftigt und waren eng miteinander verwoben. Schon Demokrit (459 – 370 v. Chr.), der Begründer des Atomismus, schrieb: „Nur scheinbar hat ein Ding eine Farbe, nur scheinbar ist es süß oder bitter; in Wirklichkeit gibt es nur Atome und leeren Raum.“ Er glaubte, dass Atome zu klein seien, um mit menschlichen Sinnen wahrgenommen zu werden. Über die Anzahl unterschiedlicher Atome und ihre Formen gab es unterschiedliche Ansichten. Offenbar angeregt durch die Form von Kristallen nahm Platon an, dass Atome die Form der vier einfachsten geometrischen Körper haben, die sich aus Dreiecken und Quadraten konstruieren lassen. Bis zur Renaissance fand keine weitere Entwicklung der Atomlehre statt. Im Mittelalter dominierten Vorstellungen der Magie. Erst ab Mitte des sechzehnten Jahrhunderts begann sich wieder die antike Atomlehre durchzusetzen, die dann von den frühen Chemikern praktisch weiterentwickelt wurde. Mit der Renaissance fand die Vorstellung von Atomen wieder weite Verbreitung. „It is as easy to count atomies as to resolve the propositions of a lover” hieß es schon 1601 in Shakespeare’s Schauspiel Was ihr wollt.

Die möglichen Kristallstrukturen sind vielfältiger als man als Laie denkt – lange entzogen sie sich einer vollständigen Systematisierung. Erst nachdem in der Mathematik die Gruppentheorie entwickelt worden war, gelang 1890/91 Arthur Schoenflies und Jewgraf S. Fjodorow die Ableitung aller 230 möglichen Raumgruppen – räumlichen Gittern, die durch Spiegelung, Drehung und Verschiebung von Elementen zustande kommen. Bis von Laue durch die Röntgenbeugung experimentell nachwies, dass Kristalle tatsächlich dreidimensional periodisch aufgebaut sind, waren das allerdings nur theoretische Vermutungen.

Mit Einsteins Nachweis, dass die Materie aus Atomen besteht, im Jahr 1905, mit von Laues Analysemethode der Röntgenbeugung seit 1912 und mit dem Abschluss der Quantentheorie durch Dirac 1928 eröffneten sich innerhalb weniger Jahre für die Werkstoffkunde ganz neue Horizonte: Durch die nun vorstellbare Rückführung beliebiger Materialeigenschaften auf atomare Strukturen wurde es denkbar, die erst in Ansätzen systematisierten empirischen Erfahrungen der Werkstoffpraktiker in eine theoretisch fundierte Wissenschaft zu überführen.

Doch das war noch ein langer Weg. Die von den makroskopischen Eigenschaften ausgehenden Praktiker hatten etablierte Berufsstrukturen, Disziplinen, Industrien und Methoden. Die quantentheoretischen Gleichungen auf der anderen Seite konnten noch lange nicht auf komplexe Strukturen von vielen Atomen angewendet werden. Aber neue Konzepte begannen das Denken, und neue Geräte (Röntgenspektrometer, ab 1931 das Elektronenmikroskop) begannen die Arbeitsweise zu verändern. In Spezialfällen erwies sich die Theorie bereits als sehr brauchbar (Theorie der Halbleiter 1939, Folge 5; Theorie der Supraleitung 1957, Folge 15).

Zunächst aber förderten ganz andere Entwicklungen die Materialforschung: die unerwarteten Materialengpässe im unerwartet langen ersten Weltkrieg ließen bei allen großen Mächten vor dem zweiten Weltkrieg eine systematischere Vorsorge ratsam erscheinen. Und Forschung versprach neuartige Lösungen: In Deutschland hatte die die Erfindung der Ammoniak-Synthese (Haber-Bosch-Verfahren) zu einer wesentlichen Verzögerung der Niederlage geführt. Um einerseits die Materialversorgung zu verbessern und im Notfall auf Ersatzmaterialien zurückgreifen zu können, und um andererseits leistungsfähigere Materialien und Methoden zu entwickeln, wurde von staatlicher Seite die Materialforschung intensiviert. In den USA gründete 1916 Präsident Wilson auf Vorschlag der National Academy of Sciences den National Research Council. In Deutschland wurde die das System der Gemeinschaftsforschung verschiedener Institutionen und Industrien perfektioniert, in dem das Materialprüfungsamt (MPA, später BAM) insbesondere für Metalle eine zentrale Rolle spielte. Auch die Gründung der Notgemeinschaft der Deutschen Wissenschaften 1926 (der späteren DFG) wurde vor allem mit den Erfahrungen im ersten Weltkrieg begründet.

Nachdem Deutschland in der Zwischenkriegszeit auf internationalen Austausch und Exporte gesetzt hatte, verfolgten die Nationalsozialisten schon ab den frühen dreißiger Jahren wieder eine Politik der Autarkie und Aufrüstung, die auf die Erfahrungen im Ersten Weltkrieg zurückgriff. Sie entwickelten ein immer dichteres Geflecht von Institutionen für die militärisch motivierte Materialforschung, das ein neuartiges und effizientes Innovationssystem darstellte.

Allerdings zeigte sich in der „Ersatzstoffforschung“, dass der historisch gewachsene, auf jeweils spezifische Bedingungen ausgerichtete Einsatz von zunehmend knappen Materialien kaum systematisch durch neue Materialien ersetzt werden konnte: die Anforderungen und Belastungen von Bauteilen waren oft nicht gemessen und systematisch erfasst, Werkstoffe waren unzureichend charakterisiert, um eine systematische Ersetzung zu ermöglichen. Ausführliche Praxistests einzelner Bauteile blieben unerlässlich. Die neuen wissenschaftlichen Theorien und Methoden waren gegenüber den praktischen Aufgaben weitgehend hilflos.

Die Anfänge der modernen Materialwissenschaften in Zeiten des kalten Krieges

Nach dem Zusammenbruch 1945 beeilten sich sowohl die Sowjetunion als auch die USA, durch Abtransport von Ausrüstungen und Deportation bzw. Abwerbung von Wissenschaftlern die Kompetenzen der deutschen Material- und Rüstungsforschung für sich zu nutzen. Allein von anglo-amerikanischer Seite waren bis zu 12‘000 „investigators“ im Reichsgebiet unterwegs, die 4000 Berichte zur möglichen Kriegsrelevanz von Forschungsaktivitäten anfertigten. Die Zahlenangaben zu deportierten/ abgeworbenen Wissenschaftlern sind uneinheitlich. Am bekanntesten von ihnen ist der Raketenspezialist Wernher von Braun: SS-Mitglied, führender Entwickler der „Wunderwaffe“ V2-Rakete – bei deren Produktion mehr Zwangsarbeiter umkamen als bei ihrem Einsatz – und später für die Entwicklung der Saturn-Rakete verantwortlich, mit der 1969 die Mondlandung gelang.

Mit den Erfahrungen während des Krieges wuchs vor allem in den USA das Interesse, die Eigenschaften von Metallen und anderen Werkstoffen mit den neuen wissenschaftlichen Methoden genauer zu erfassen und über den empirischen, ingenieurtechnischen Ansatz hinaus theoretische Grundlagen für die Entwicklung neuer Werkstoffe zu schaffen.

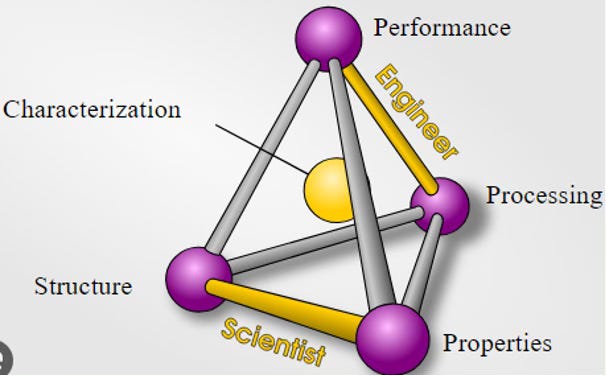

Der Begriff Materialwissenschaften (material sciences) entstand in den frühen fünfziger Jahren in den USA, vorwiegend ausgehend von der Metallurgie. An der Northwestern University entstand 1959 das erste Department of Materials Science. Andere Universitäten folgten dem Beispiel. Metallurgen, Keramikspezialisten, Physiker, Chemiker und Biologen brachten ihr Spezialwissen ein, während die neuen, durch die Quantentheorie ermöglichten Erkenntnisse über den Aufbau und die Wechselwirkung von Atomen, Molekülen und Elementarteilchen, sowie die neuen Methoden zur Analyse von Strukturen und Dynamiken auf der Nanoebene Brücken zwischen bislang getrennten Wissensgebieten schlugen und gemeinsame Methoden etablierten. Wesentlichen Anteil am Entstehen des neuen interdisziplinären Ansatzes hatten auch industrielle Einrichtungen: vor allem die Arbeitsgruppe von William Shockley in den Bell Laboratories, die 1947/48 den Transistor und die Solarzellen erfand, und die Arbeitsgruppe von J.H. Hollomon im General Electric Laboratory, der unter anderem die künstliche Herstellung von Diamanten gelang.

Eine Schlüsselfigur für die Entstehung der Materialwissenschaften war John von Neumann (1903-1957). Aus einer ungarisch-jüdischen Familien stammend, hatte das Wunderkind – mit sechs konnte er im Kopf achtstellige Zahlen dividieren und sich auf Altgriechisch unterhalten – zunächst in Zürich ein Studium als Chemie-Ingenieur abgeschlossen und kurz darauf in Budapest in Mathematik promoviert. Mit vierundzwanzig war er der jüngste Privatdozent an der Universität in Berlin und schrieb mehrere einflussreiche mathematische Publikationen. 1932 zeigte er in seinem Buch Mathematische Grundlagen der Quantenmechanik, dass Paulis Matrizenmechanik und Schrödingers Wellengleichung äquivalent sind und schlug eine mathematisch elegante relativistische Synthese vor, die sich bei den Physikern allerdings nicht gegen den zeitgleich formulierten Ansatz von Dirac durchsetzen konnte. Ab 1929 pendelte er zwischen Europa und den USA und blieb nach der Machtergreifung der Nazis 1933 als Professor für Mathematik am Institute for Advanced Studies in Princeton, wohin auch Einstein emigriert war. Im Manhattan-Projekt war er maßgeblich an der Entwicklung der Plutonium-Bombe beteiligt und saß im Target Committee für die Abwurfziele der Atombomben auf Japan. In den vierziger Jahren entwarf von Neumann wesentliche Aspekte heutiger Computer-Architekturen und Programmiertechniken – er gilt als einer der Begründer der Informatik. Als er 1954 das für die Wissenschaften zuständige Mitglied der fünfköpfigen Atomic Energy Commission (AEC) wurde, entwickelte er mit dem einflussreichen Festkörperphysiker Frederick Seitz von der University of Illinois (der nach seiner Pensionierung ein übler, hochbezahlter Leugner von Tabakschäden, Ozonloch und Klimawandel wurde) die Konzeption für ein von der AEC finanziertes interdisziplinäres Materialforschungszentrum, das Modellcharakter haben sollte. Sein Tod 1957 verhinderte das Zustandekommen, aber bald wurde die Idee wieder aufgegriffen.

Dass es der Sowjetunion am 7. Oktober 1957 gelang, mit dem Sputnik den ersten Satelliten in eine Erdumlaufbahn zu schicken, löste in den USA tiefgreifende Ängste vor einer technologischen Überlegenheit des Rivalen aus. Der Gegner im Kalten Krieg hatte damit nicht nur Aussichten, neue Erdbeobachtungs- und Kommunikationssysteme aufzubauen, sondern hatte vor allem Trägerraketen entwickelt, die mit Atombomben bestückt jedes Ziel auf der Erde treffen konnten. Als Reaktiongründete Präsident Eisenhower 1958 unter anderem die Advanced Research Project Agency (ARPA, ab 1996 DARPA), die die Entwicklung von geeigneten Materialien als einen wichtigen limitierenden Faktor für Raumfahrt- und Militärtechnologien identifizierte. Mithilfe von Grundlagenwissen aus der Physik, deren Ruf als Leitwissenschaft des wissenschaftlich-technischen Fortschritts durch den eindrucksvollen Erfolg des Manhattan-Projekts enorm zugenommen hatte, wollte man die pragmatisch-technisch ausgerichtete Materialkunde auf ein wissenschaftliches Niveau heben. Dazu brauchte es nicht nur eine Zusammenführung von Grundlagenforschung und empirisch begründeten Ingenieurdisziplinen, sondern auch die Ausbildung junger Wissenschaftler, die interdisziplinär denken und verschiedene Ansätze verbinden konnten. Deshalb entschied man sich gegen zentrale Forschungszentren, wie sie im Manhattan-Projekt aufgebaut wurden, und für ein Netzwerk von interdisziplinären Einrichtungen für Forschung und Lehre an Universitäten, wie es von Neumann vorgeschwebt hatte. Bis 1972 hatte die ARPA zwölf solcher Einrichtungen aufgebaut. An vielen Universitäten orientierten sich weitere Departments an diesem Trend.

Eine treibende Rolle für die Materialwissenschaften spielten die nach der Erfindung des Transistors immer intensiveren Bemühungen, leistungsfähige Halbleiter für immer kleinere elektronische Bauteile herzustellen. 1953 gelang bei Siemens die Herstellung des ersten Einkristalls aus Silizium, das wegen seines größeren Bandabstandes (Spannungsdifferenz zwischen den relevanten Elektronenbahnen) für die Mikroelektronik wesentlich geeigneter ist als das bis dahin dominierende Germanium. Hochreine, makellose Kristalle herzustellen, die Wirkung von gezielt eingebrachten Fremdatomen (Dotierung) zu verstehen, und immer kleinere Strukturen zu realisieren, erforderte materialwissenschaftliche und technische Pionierarbeit. 1971 wurde mit dem Intel-4004 der erste industrielle Mikroprozessor erhältlich – die darauf realisierten elektronischen Strukturen war nur 10 Mikrometer groß.

Damit waren am Ende der heißen Phase des kalten Krieges wesentliche konzeptionelle und institutionelle Voraussetzungen für die Entwicklung einer theoretisch fundierte Materialwissenschaft geschaffen, die alle Disziplinen, Sichtweisen und Erfahrungsstränge zusammenbringen könnte, die sich mit Materialien befassen. In der Praxis allerdings war man noch weit davon entfernt: Die Konzepte der Quantentheorie konnten nur als Orientierung dienen, denn die vertrackten Gleichungen ließen sich am Anfang der Computerentwicklung noch nicht für so komplexe Systeme lösen. Verschiedene Disziplinen mit ihren unterschiedlichen Sichtweisen und ganz unterschiedlich strukturierten pragmatischen Erfahrungsschätzen werkelten nebeneinanderher, aber kamen immerhin durch neue gemeinsam genutzte Methoden miteinander ins Gespräch. In der nächsten Folge werden wir sehen, wie sich in den folgenden Jahrzehnten das Bild grundsätzlich wandelte und ganz neue Ansätze entstanden, die nicht zuletzt für die Batterieentwicklung weitreichende Folgen hatten.