Disruptive neue Materialien – Spätfolge der Physik-Revolution vor 100 Jahren

Geschichte der Energietechnik – Die Entdeckung der Nanowelten ermöglicht eine erneuerbare Energieversorgung für Alle (18)

Die Schaffung neuer Materialien, die unerhörte Energie- und Materialeisparungen ermöglichen, beschleunigt sich in einem Ausmaß, das in der Öffentlichkeit kaum wahrgenommen wird. Der enorme Zuwachs an Leistungsfähigkeit der Computer fängt an, auch unseren Umgang mit Materialien ganz grundlegend zu verändern: Endlich kann das Potenzial der Quantentheorie ganz praktisch in der Breite der Materialwissenschaften erschlossen werden. Seit einem halben Jahrhundert sind sowohl die Kosten als auch der Energieaufwand für Rechenleistung alle zehn Jahre um etwa das Zwanzigfache gesunken. Die Geschichte der neueren Materialwissenschaften zeigt, dass dadurch ein Innovationsschub ausgelöst wird, der die Energie- und Materialintensität unserer Zivilisation drastisch senken kann.

Die letzte Folge dieser Serie handelte von der Geschichte der Materialwissenschaften bis etwa 1970, als der Kalte Kriege abflaute. Mit neuen Fragestellungen, neuen Methoden und zunehmender Rechnerleistung setzte anschließend eine sich beschleunigende Entwicklung ein. Nach dem Ende der Blockkonfrontation 1990 mobilisierte die zunächst noch mechanistische Vision der Nanotechnologie neue Ressourcen. Ab der Jahrtausendwende hat insbesondere die Möglichkeit, die quantentheoretischen Gleichungen auch für komplexere Systeme zu lösen, zu schnellen Fortschritten und ganz neuen Materialien geführt. Am Beispiel der Batterieentwicklung lässt sich nachverfolgen, wie die Entwicklung ganz neuer Materialtypen unerwartete neue Horizonte eröffnet.

Ende der Nachkriegszeit: Internationalisierung der Materialwissenschaften mit zivilen Fragestellungen

Um 1970 traten gesellschaftliche und wirtschaftlich-industrielle Fragestellungen gegenüber militärischen Anstrengungen in den Vordergrund. Der Vietnam-Krieg führte zu internationalen Protesten, das Wachstumsmodell der fordistischen Massenproduktion stieß auf Schwierigkeiten, streikende Arbeiter, protestierende Studenten, erste Anfänge der Umweltbewegung forderten andere Prioritäten. Der Kalte Krieg verlor an Bedeutung, abnehmendes Wirtschaftswachstum, Umweltprobleme und dann die Ölkrise sorgten für kleinere Militärprogramme und die Suche nach Antworten auf neue Fragen.

Meine Artikelserie zur Geschichte der Energietechnik:

Die Entdeckung der Nanowelten ermöglicht eine erneuerbare Energieversorgung für Alle

Die bisherigen Folgen:

Kernspaltung: Frühe, verführerische Frucht einer wissenschaftlichen Revolution

Wo die sinnliche Erfahrung versagt: Neue Methoden erlauben die Entdeckung von Nano-Welten

Virtuelle Welten auf Siliziumbasis: Nanowissenschaften revolutionieren die Informationstechnik

Die Entzauberung des biologischen Informationssystems – kein dauerhafter Beitrag zur Energietechnik

Die Geschichte der fossilen Energieversorgung, Grundlage der Industrialisierung

Die Klimakrise stellt die industrielle Zivilisation in Frage: Welche Optionen haben wir?

Dank Nanowissenschaften: Strom direkt aus Sonnenlicht wird unschlagbar günstig

PV: Zunehmende Kostenvorteile durch nanotechnische Dematerialisierung

Big was beautiful — Wie die Dampfkraft unsere Institutionen geprägt hat

Umbau des Stromsystems seit 50 Jahren – Von der Zentrale zum Netzwerk

Emanzipation von der Mechanik – der lange Weg zur modernen Leistungselektronik

Leistungselektronik macht Elektrizität zur flexiblen Universal-Energie

Klassische Batterien und die Entwicklung der (Elektro-)Chemie

In den Jahren des Wiederaufbaus und des kalten Krieges war technischer Fortschritt weitgehend kritiklos befürwortet worden. Auch die Rüstungsforschung stieß auf wenig Skepsis. Allerdings hatten die Kernwaffen zum ersten Mal das Potential der Technik zur Selbstzerstörung der Menschheit demonstriert. Und die Willfährigkeit der Wissenschaftler, die für das Naziregime und den Holocaust gearbeitet hatten, hatte den Mythos der reinen Wissenschaft zerstört. Gesellschaftliche Verantwortung bei der Entwicklung von Wissenschaft und Technik wurden ab den siebziger Jahren vor allem von der jüngeren Generation zunehmend eingefordert. Die Friedens-, Antiatom- und Umweltbewegungen erlangten zunehmend Einfluss auf die gesellschaftliche Diskussion.

In dieser neuen Lage mussten sich auch die in den USA entstandenen Materialwissenschaften neu positionieren. Neben Metallen und Halbleitern kamen zunehmend Keramiken, Kunststoffe und Gläser in den Blick. Die Physik rückte etwas in den Hintergrund, Chemie und Engineering wurden wichtiger. Der Name der Disziplin und der Laboratorien verschob sich von „Material Sciences“ (MS) zu „Material Science and Engineering“ (MSE). Konsequenterweise wechselte 1972 die Verantwortung für die materialwissenschaftlichen Laboratorien von der ARPA zur National Science Foundation (NSF), aus der Verantwortung des Verteidigungsministeriums zu einer unabhängigen Bundesbehörde.

Wie wir in der letzten Folge dieser Serie gesehen haben, war das von der Regierung vorangetriebene und vor allem militärisch motivierte Entstehen der Materialwissenschaften zunächst vor allem eine US-amerikanische Entwicklung. Mit dem Überhandnehmen ziviler Fragestellungen verselbständigte und internationalisierte sie sich. In Westeuropa hatte man sich nach dem zweiten Weltkrieg vor allem um die Grundlagenforschung gekümmert. Die zunächst militärische, und dann auch die zivile Atomtechnik wurden in großen Forschungszentren vorangetrieben. Erst später kamen intensivere Bemühungen um die angewandte Forschung dazu. Zur Internationalisierung der interdisziplinären Materialwissenschaften ab 1970 trugen die zunehmend zivilen Anwendungsgebiete, neue Materialklassen ebenso bei wie die internationale Verbreitung neuer nanowissenschaftlicher Untersuchungsmethoden.

Neue Untersuchungsmethoden: das Beispiel der Mikroskopie

Die Entwicklung der Mikroskopie illustriert die Fortschritte in den Untersuchungsmethoden. Konventionelle Lichtmikroskope mit mehreren Linsen, mit denen schon im siebzehnten Jahrhundert Mikroorganismen entdeckt wurden, können aufgrund der Wellenlänge des Lichts nur Objekte erkennen, die größer als 250 nm (Nanometer = ein Millionstel Millimeter) sind. Das ist bei heutigen, raffiniert digitalisierten Lichtmikroskopen nicht anders, aber sie können automatisch dreidimensional vermessen oder zählen.

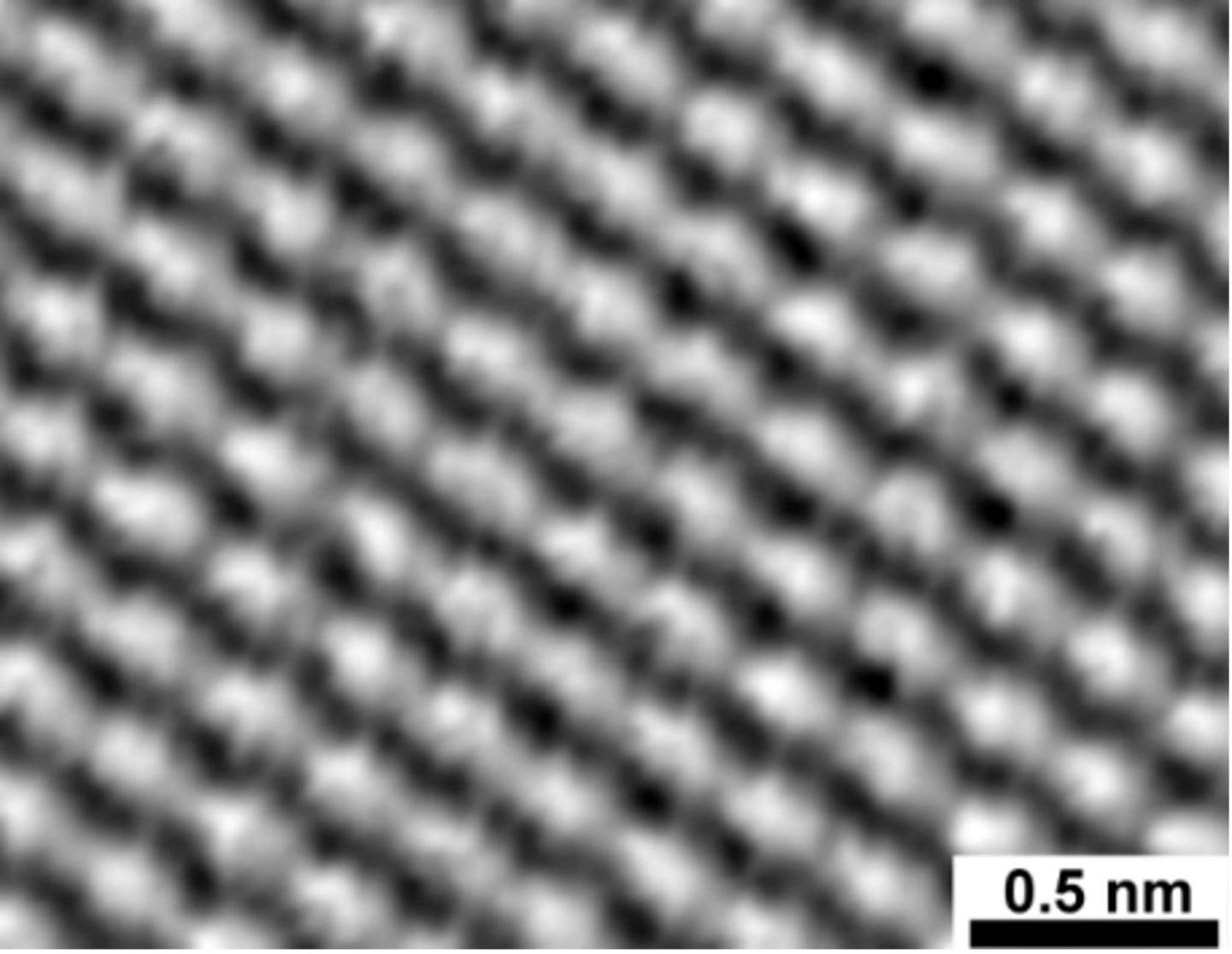

Nachdem die Quantentheorie gezeigt hatte, dass Elektronen auch als Wellen angesehen werden können, war es 1926 gelungen, mit Magnetfeldern „Elektronenlinsen“ zu konstruieren. 1931 bauten Ernst Ruska und Max Knoll bei Siemens das erste Elektronenmikroskop, das Elektronenstrahlen anstatt Lichtstrahlen verwendete, um dünne Proben zu durchleuchten. Es fand bald weite Verbreitung. 1937 baute dann Manfred von Ardenne (1907-1997) das erste Rasterelektronenmikroskop, das undurchsichtige Proben mit einem dünnen Elektronenstrahl abtastete. Die Steuerung und Bildgebung aus den Signalen verschiedenartiger Detektoren war aber mit der damaligen Elektronik noch nicht einfach. Erst 1965 gab es kommerzielle Elektronenmikroskope zu kaufen – bis heute sind sie relativ teuer. Sie schaffen eine Auflösung von bis zu 1 nm – dem dreifachen Durchmesser eines Eisenatoms. Durch spektroskopische Untersuchung der Sekundärstrahlung können spezielle Rasterelektronenmikroskope die lokal in der Probe vorhandenen Elemente identifizieren.

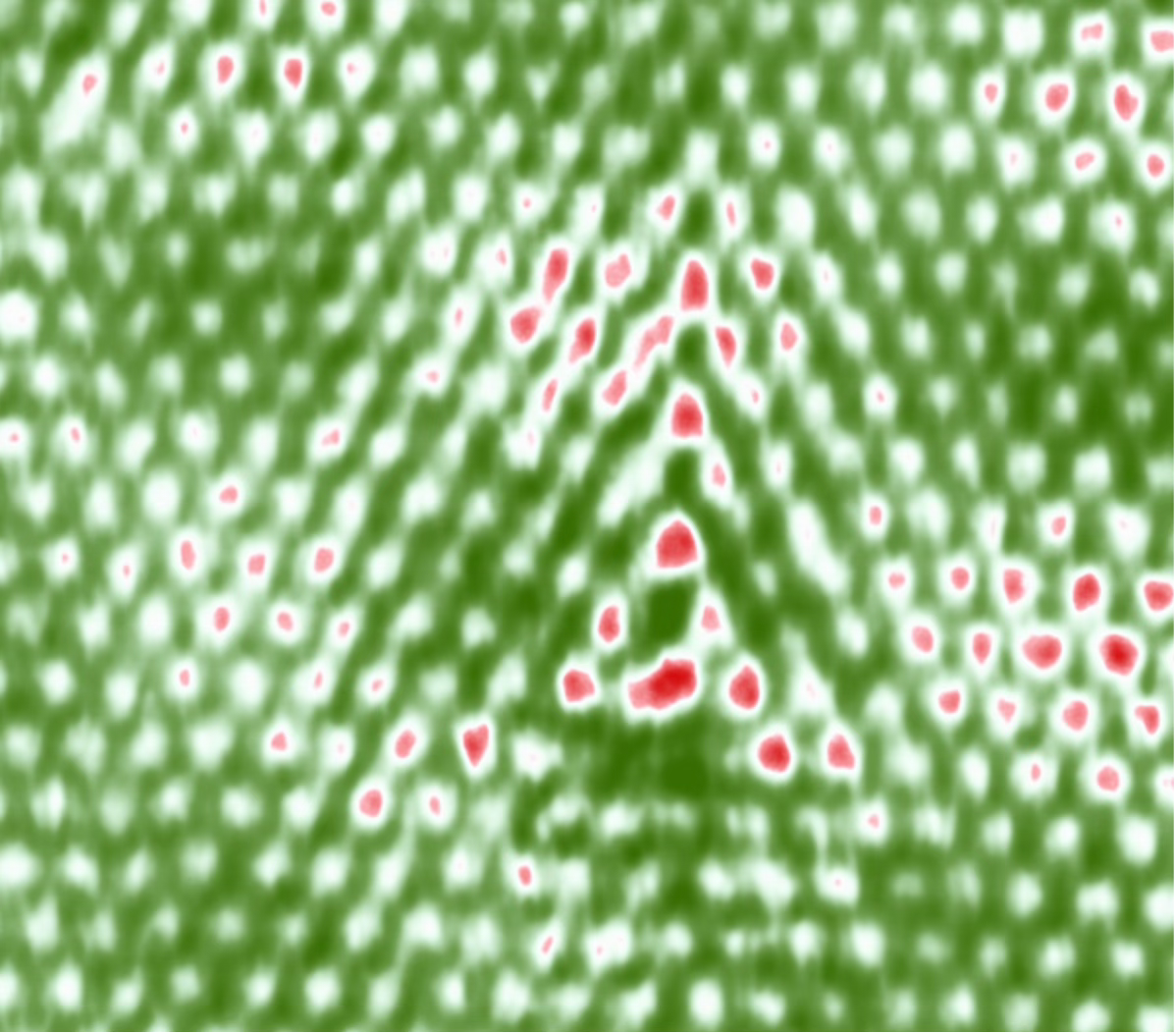

1981 gelang der nächste große Sprung in der Mikroskopie: Gerd Binnig (*1947) und Heinrich Rohrer (1933-2013) erfanden das Rastertunnelmikroskop und bekamen dafür 1984 den Nobelpreis. Nach der klassischen Physik kann bei angelegter Spannung erst dann ein Strom fließen, wenn eine leitende Verbindung besteht. Nach den Gesetzen der Quantenmechanik aber kann ein Elektron dank seiner Welleneigenschaft sehr geringe Abstände mit einer gewissen Wahrscheinlichkeit „durchtunneln“. Diesen Effekt nutzt das Raster-Tunnel-Mikroskop: mit einer feinen Spitze werden Oberflächen berührungslos abgescannt, wobei der „Tunnelstrom“ gemessen wird, der von der angelegten Spannung, dem Abstand und der atomaren Beschaffenheit der Oberfläche abhängt. Damit lassen sich einzelne Atome „sehen“, denn die Auflösung liegt bei 0,1 nm. Die Geräte sind heute kostengünstigund passen auf einen Labortisch.

Das war der Durchbruch zur einzelatomaren Analyse – wenn auch nur auf Oberflächen. Anschließend wurden weitere Rastermikroskope entwickelt, z.B. 1985 das Rasterkraftmikroskop (AFM, atomic force microscope), das die zwischen der Spitze und der Oberfläche wirksame atomare Kräfte misst. Inzwischen lassen sich mit den feinen Spitzen sogar einzelne Atome verschieben. Nicht unwesentlich für diese Entwicklungen war eine zunehmend leistungsfähige Elektronik und Datenverarbeitung, die vor allem nach der Einführung des Mikroprozessors 1971 riesige Fortschritte machte (siehe Folge 5).

Mit dem Ende des kalten Krieges verändert sich der Blick auf die Welt

Als um 1990 mit dem Ende des Warschauer Paktes und dann der Sowjetunion der kalte Krieg zu Ende ging, war die Welt schon eine ganz andere als 1970 – politisch, gesellschaftlich und technologisch. Nach dem Ende der Ost-West-Konfrontation hoffte man auf eine friedliche Entwicklung und diskutierte intensiv darüber, welche Rolle angesichts zunehmender Umweltprobleme neue Technologien in der künftigen Weltgesellschaft spielen sollten.

Mikroprozessoren hatten schon ca. 1 Million Transistoren und Taktraten von 25 MHz. Personal Computer (PCs) standen auf jedem Wissenschaftler-Schreibtisch, die meisten Messgeräte hatten mit Prozessoren und Bildschirmen ihre Leistungsfähigkeit und Handhabbarkeit mächtig gesteigert. Neue Methoden waren dazugekommen. Die im kalten Krieg sehr geschätzten Großgeräte, riesige Beschleuniger für verschiedene Arten von Teilchen, die ursprünglich vor allem für die spektakuläre Jagd nach den Elementarteilchen gebaut worden waren und zunehmend auch für Materialuntersuchungen genutzt wurden, verloren an Bedeutung. Kleine und mittelgroße Geräte eroberten die Labore, dezentrale Forschung in kleineren Teams wurde effizient. Das entsprach auch dem Strukturwandel in der globalen Wirtschaft. Internationale Konzerne ersetzten zentralisierte Strukturen durch weltweite Netzwerke oder lösten sich gleich in mehrere Teile auf, Zentrallabore wurden durch internationale Zusammenarbeit zwischen regionalen Forschungszentren und mit Zulieferern ersetzt.

Die aus verschiedenen Disziplinen kommenden Materialwissenschaften bekamen immer mehr eine gemeinsame Vorstellung davon, wie atomare Strukturen und Prozesse mit makroskopischen Eigenschaften von Materie zusammenhängen. Gemeinsam genutzte Methoden und Geräte schafften Verbindungen, gemeinsame Terminologien, ähnliche Interpretationen. Das Interesse der Forscher konvergierte immer stärker auf eine gemeinsame räumliche Größenordnung zwischen 0,1 und 100 Nanometer.

Was aber war nun ihre übergreifende Aufgabe? Mit der vor allem in den USA wichtigen militärischen Begründung für großzügige öffentliche Forschungsfinanzierung war es mit dem Ende des Kalten Krieges schwierig geworden. Auch die Werbung für neue Technologien im Alltagsleben mit der Ankündigung, sie seien ein Produkt der Raumfahrt – von der Pfannenbeschichtung über Akkubohrer bis zum Material für Matratzen – verlor an Attraktivität, die Mondlandung war gut zwei Jahrzehnte her. Wenn sich die Aufgaben der Materialwissenschaften entsprechend den Interessen der involvierten Industrien aufsplitterten, dann war eine öffentliche Förderung immer weniger zu rechtfertigen. Forscher, Wissenschaftsmanager und Technologiepolitiker erkannten: für einen neuen Schub an staatlicher Förderung brauchte es eine öffentlich vermittelbare, faszinierende Vision.

Nanotechnologie – eine mechanistische Vision mobilisiert neue Ressourcen

Seit Anfang der achtziger Jahre hatte Eric Drexler (*1955) vom Space Systems Laboratory des MIT (Massachusetts Institute of Technology), angeregt von Fortschritten in der Biochemie für „Molecular Engineering“ geworben. Bald schwärmte er von der „Coming Era of Nanotechnology“, in der man mit „nanomachines“, zu „universal assemblers“ kombiniert, Atom für Atom neue Strukturen schaffen könne. „With assemblers we will be able to remake our world or destroy it”.

Dabei berief er sich auf einen 1959 gehaltenen berühmten Vortrag des legendären Physikers Richard Feynman (1918-1988), der 1965 den Nobelpreis für seine Arbeiten zur Quantenelektrodynamik bekommen hatte und für seine anschaulichen Darstellungen berühmt war. „There’s plenty of room at the bottom“ hatte Feynman seinen visionären Vortrag vor der American Physical Society überschrieben. Ausgehend von extrem kleinen biologischen Systemen, die physikalische Prinzipien auf der molekularen Ebene nutzen, fragte er „What would happen if we could arrange the atoms one by one the way we want them“, und malte sich aus, wie leistungsfähig Computer, die Informationen auf atomarer Ebene verarbeiten, oder medizinische Reparaturmaschinen dieser Größenordnung sein könnten. Heute, 65 Jahre später, erstaunt einerseits, wie weitsichtig Feynman damals schon war, und andererseits, wie sehr er noch in mechanischen Kategorien formulierte und sich etwa über die Schmierung von Lagern Gedanken machte. Drexler griff vor allem die Vorstellung einer nanoskaligen Mechanik auf: „To have any hope of understanding our future, we must understand the consequences of assemblers, disassemblers, and nanocomputers”.

Über Jahrzehnte blieb Drexler ein glühender Propagandist der Nanotechnologie, aber nicht alle Materialwissenschaftler teilten seine Visionen. Zurückhaltender war der Maschinenbauingenieur Mihail C. Roco, der 1976 seinen Doktortitel in Bukarest erwarb, Professuren in den USA, den Niederlanden und Japan bekleidete, und ab 1990 bei der NSF (National Science Foundation) arbeitete. Dort begeisterte er sich für die Nanotechnologie und betrieb bald hartnäckig den Aufbau eines ambitionierten behördenübergreifenden Programms für die Nanotechnologie-Forschung.

In der amerikanischen Politik war man überzeugt, dass mit dem Ende des kalten Krieges der wirtschaftliche und technologische Wettbewerb den Rüstungswettlauf ablösen würde, und dass die USA sich dafür neu aufstellen müssten. In „Science in the National Interest“, dem ersten Strategiepapier zur Forschungspolitik der amerikanischen Präsidentschaft seit 15 Jahren, erklärten 1994 Präsident Bill Clinton und Vizepräsident Al Gore Investitionen in die Wissenschaft zur „top priority for building the America of tomorow“. Als Rivalen sah man damals vor allem Japan an. Dessen wachsende Wirtschaftsmacht wurde in den USA zunehmend als Bedrohung empfunden.

Japan hatte 1991 ein Förderprogramm von 225 Millionen US-Dollar für Nanotechnologie aufgelegt. Auch in Europa gab es Programme für nanotechnologische Forschung. Zwischen 1996 und 2001 erschienen weltweit rund 90‘000 wissenschaftliche Publikationen mit Nano-bezug (13% Materialwissenschaften, 10% angewandte Physik, 10% Physikalische Chemie, 8% Festkörperphysik, 6% allgemeine Chemie, dabei hatten Materialwissenschaften und Chemie die größten Wachstumsraten). 40 Prozent der weltweiten Nano-Publikationen kamen aus der EU, 26 Prozent aus den USA, 13 Prozent aus Japan.

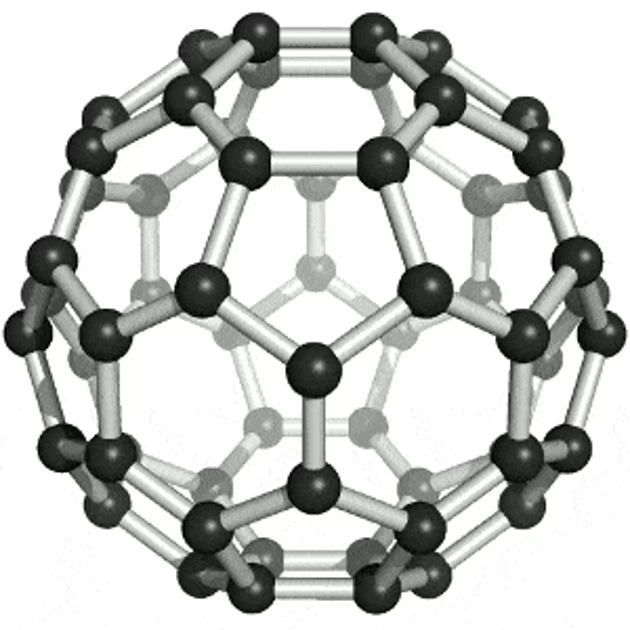

1985 hatte ein britisch-amerikanisches Team die Fullerene entdeckt – geschlossene Hohlkörper aus 60 oder mehr Kohlenstoffatomen, die in geometrischer Regelmäßigkeit aus Fünf- und Sechsecken gebildet sind – wofür die beteiligte Wissenschaftler 1995 den Chemie-Nobelpreis bekamen. Nachdem 1990 nachgewiesen wurde, dass es möglich war, die Fullerene in größeren Mengen zu produzieren, brach eine Welle der Begeisterung für den neuen Stoff aus. Einerseits erhoffte man sich davon neue Horizonte für die Chemie, wie sie Ende des 19. Jahrhunderts die Entdeckung des Benzols eröffnet hatte (siehe Folge 16). Andererseits versprachen die ungewöhnlichen physikalischen Eigenschaften auch über die Chemie hinaus neue Anwendungsmöglichkeiten. Mitte der Neunzigerjahre hatte allerdings schon Ernüchterung eingesetzt. Eine heute immer wichtiger werdende Variante von Fullerenen sind Nanotubes, hohle Röhrchen aus Kohlenstoff-Sechsecken, die extreme Festigkeiten aufweisen. Erst mit der vollständigen quantentheoretischen Beschreibbarkeit wird heute ihr Potential langsam deutlich.

In diesem Umfeld schmiedete Roco geschickt eine breite Koalition von Unterstützern für eine National Nanotechnology Initiative (NNI). Dabei bediente er sich der anschaulichen Visionen Drexlers. Von Anfang an war das Programm als innovative, behördenübergreifende Strategie angelegt, die eine Vielzahl von Universitäten, Institutionen und Firmen umfassen, junge Forscher für die Wissenschaften begeistern und eine vielfältige Innovationsoffensive auslösen sollte. Abgesehen von Zweifeln an diesem organisatorischen Ansatz warnten Kritiker vor allem vor den ungeklärten Folgen der Nanotechnologien. Prominente Skeptiker befürchteten sogar, autonome, selbstvermehrende Nano-Assembler könnten zu einer Gefahr für die Menschheit werden. Im Herbst 2000 bewilligte der US-Kongress 465 Millionen Dollar für die NNI.

Das Programm ist über die Jahre stark gewachsen: 2010 betrug das Budget bereits 1,9 Milliarden, 2024 beantragte Präsident Biden dafür 2,16 Milliarden. Das Forschungsfeld ist – wie der Name sagt – eher technologisch ausgerichtet und wurde als Förderprogramm immer wieder neu abgegrenzt. Nanotechnologie ist keine wissenschaftliche Disziplin, aber ein Begriff, der quer durch die Wissenschaften immer wieder auf die Nano-Dimension und auf die Anwendbarkeit hinweist. Die NNI sagt gamz einfach: “Nanotechnology is the understanding and control of matter at the nanoscale, at dimensions between approximately 1 and 100 nanometers, where unique phenomena enable novel applications”. 2015 wurden weltweit sechsmal so viele wissenschaftliche Artikel zu Nanotechnologie-Themen veröffentlich wie im Jahr 2000. Der Anteil chinesischer Publikationen stieg gleichzeitig von 10% auf 36%.

Maßgeschneiderte Membranen senken den industriellen Energieverbrauch

Die Materialwissenschaftler in aller Welt wussten sich die nanotechnologischen Förderprogramme zunutze zu machen und bauten ihre Institutionen aus. Aber Nanotechnologie und Materialwissenschaften sind nicht deckungsgleich. Inzwischen ist kaum mehr überschaubar, wo überall materialwissenschaftliche Erkenntnisse, die erst aufgrund der Quantenmechanik und neuer Rechenmethoden möglich wurden, von zentraler Bedeutung sind. In allen möglichen Industrien tauchen neue Materialien mit erstaunlichen Eigenschaften auf, die noch vor zwei Jahrzehnten kaum denkbar waren.

Die Elektronik – die inzwischen als Grundlage von Software und künstlicher Intelligenz eine ganz neue Ebene der Informationsverarbeitung und Kommunikation ermöglicht – war gewissermaßen erst der Anfang. Wir haben in vorangehenden Folgen gesehen, wie die neuen Materialwissenschaften Photovoltaik und Leistungselektronik ermöglichen, gleich geht es mehr im Detail um Batterien. Aber damit ist das Potential noch lange nicht ausgeschöpft.

Ein Beispiel sind Membranen: Wir haben in der vorletzten Folge gesehen, wie selektiv durchlässige Barrieren einen großen Fortschritt bei den ersten Batterien ermöglichten. In der Biologie spielen spezialisierte Membranen eine große Rolle. Inzwischen ist es dank detaillierter quantenmechanischer Modellierungen möglich, ganz gezielt Membranen herzustellen, die für bestimmte Moleküle und Ionen durchlässig sind, aber für andere nicht – wobei es nicht nur auf die Größe, sondern auch auf andere physikalische und chemische Eigenschaften ankommt. Damit bahnt sich jetzt eine Revolutionin vielen, vor allem energieintensiven Industrien an, z.B. in der chemischen Produktion. Die Auftrennung von Stoffen macht etwa 15 Prozent des weltweiten Energieverbrauchs aus und rund 75 Prozent der Kosten von Rohstoffen und Chemikalien.

Die wichtigste Methode, um chemische Stoffe zu trennen, ist bisher die Destillation: Dabei wird ein Stoffgemisch so weit erhitzt, dass ein Stoff verdampft, ein anderer aber noch flüssig bleibt. Der ausgetriebene gasförmige Teil wird nach dem Abkühlen (für das oft große Mengen Kühlwasser benötigt werden) wieder flüssig. Um eine hohe Reinheit zu erreichen, ist meist ein mehrstufiger Prozess notwendig. Auf diese Weise wird seit jeher Schnaps „gebrannt“. Chemische Fabriken und Raffinerien bestehen zu einem beträchtlichen Teil aus großen Destillationskolonnen, die die noch vermischten Reaktionsprodukte chemischer Reaktionen in brauchbare Produkte aufgliedern. Auch Entsalzungsanlagen, die aus Meerwasser Trinkwasser gewinnen, funktionieren zum großen Teil noch nach diesem energieaufwändigen Prinzip.

Mit der Möglichkeit, ganz gezielt Membranen zu entwickeln, die einen Stoff durchlassen und einen anderen nicht, wird es interessant, Destillationstürme zumindest teilweise durch Membranen zu ersetzten. Das Aufheizen und das Abkühlen fallen weitgehend weg. Der erhöhte Energieverbrauch der Pumpen ist meist deutlich geringer. Die Energieeinsparung ist je nach Aufgabe und Eignung der Membran unterschiedlich. Für die USA wird geschätzt, dass von den 32 Prozent des gesamten Energieverbrauchs, die auf die Industrie entfallen, etwa die Hälfte für Separationsprozesse aufgewendet werden und davon wiederum etwa die Hälfte – also 8 Prozent des Gesamtenergieverbrauchs – für Destillationsprozesse, die zu 90 Prozent durch Membran-basierte Trennungsprozesse eingespart werden könnten (Daten von 2015). Weitere dreißig Prozent des industriellen Energieverbrauchs entfallen auf thermische Trocknungs- und Verdunstungsprozesse, die ebenfalls mit Membranen wesentlich energieeffizienter gestaltet werden können. Durch die Einsparung von Kühlwasser und die Aufbereitung und Wiedereinspeisung von Abwässern kann auch der Wasserverbrauch drastisch reduziert werden. Zudem kann der Separationsprozess damit vollständig elektrifiziert werden.

Für viele Verfahren steht die Suche nach geeigneten Membranen erst am Anfang, und auch wo schon Membrantechniken zur Verfügung stehen, hat die Umstellung gerade erst begonnen. Fortschritt und Potentiale zu quantifizieren ist nicht einfach – die Chemieverbände gehen davon aus, dass viele Technologien und ihr Einsatz nicht offengelegt werden.

Materialwissenschaften revolutionieren unser Verhältnis zur materiellen Welt

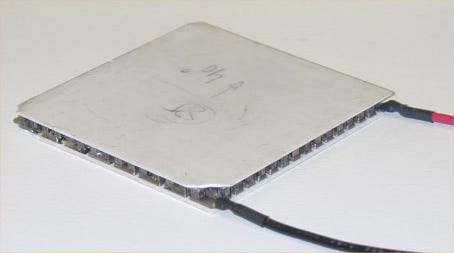

Ein anderes Beispiel für die beginnenden Umwälzungen durch die neuen Materialwissenschaften sind jüngste Fortschritte bei der Konstruktion thermoelektrischer Elemente. Schon im 19. Jahrhundert entdeckte man die thermoelektrischen Effekte, mit denen man entweder Temperaturdifferenzen für die Produktion elektrischer Energie nutzen (Seebeck-Effekt, thermoelektrischer Generator), oder umgekehrt mit Strom Temperaturdifferenzen zum Kühlen oder Heizen herstellen kann (Peltier-Effekt, Festkörper-Wärmepumpe). Für Spezialanwendungen (z.B. als Temperatursensoren, für Camping-Kühlschränke oder für zyklisches Heizen und Kühlen in Laborgeräten) werden solche Thermoelemente bereits vielfach verwendet.

Für die Nutzung von Abwärme oder als Wärmepumpe/Kühlgerät wären sie eine ideale wartungsarme Vorrichtung, die sich für massenhafte Anwendung in der neuen Energiewelt eignen würde – wenn der Wirkungsgrad nicht bisher so gering wäre. So liegt er bei thermoelektrischen Kühlaggregaten bei einem Viertel des Wirkungsgrads von Kompressions-Kühlmaschinen. Das liegt im Wesentlichen daran, dass optimale Wärmeisolation zwischen der heißen und der kalten Seite und optimale elektrische Eigenschaften bei den bisher verwendeten Materialien zueinander im Widerspruch stehen. In den letzten Jahren hat man aber deutliche Fortschritte mit neuen exotischen Materialien erzielen können. Kürzlich scheint nun ein Durchbruch gelungen zu sein, indem eine breitangelegte Suche mithilfe von Datenbanken mit großen Zahlen quantentheoretisch durchgerechneter Verbindungen durchgeführt wurde. Dabei wurden mehrere vielversprechende Material-Kandidaten identifiziert. Es wird angenommen, dass in den nächsten Jahren thermoelektrische Elemente in größerem Maßstab für die Umwandlung bisher kaum nutzbarer Wärme in Strom genutzt werden. Zum Beispiel wird daran gearbeitet, den Wirkungsgrad von Solarzellen deutlich zu erhöhen, indem die unvermeidliche Erwärmung der Solarzellen genutzt wird, da nicht die gesamte Sonnenstrahlung durch den photovoltaischen Effekt eingefangen werden kann.

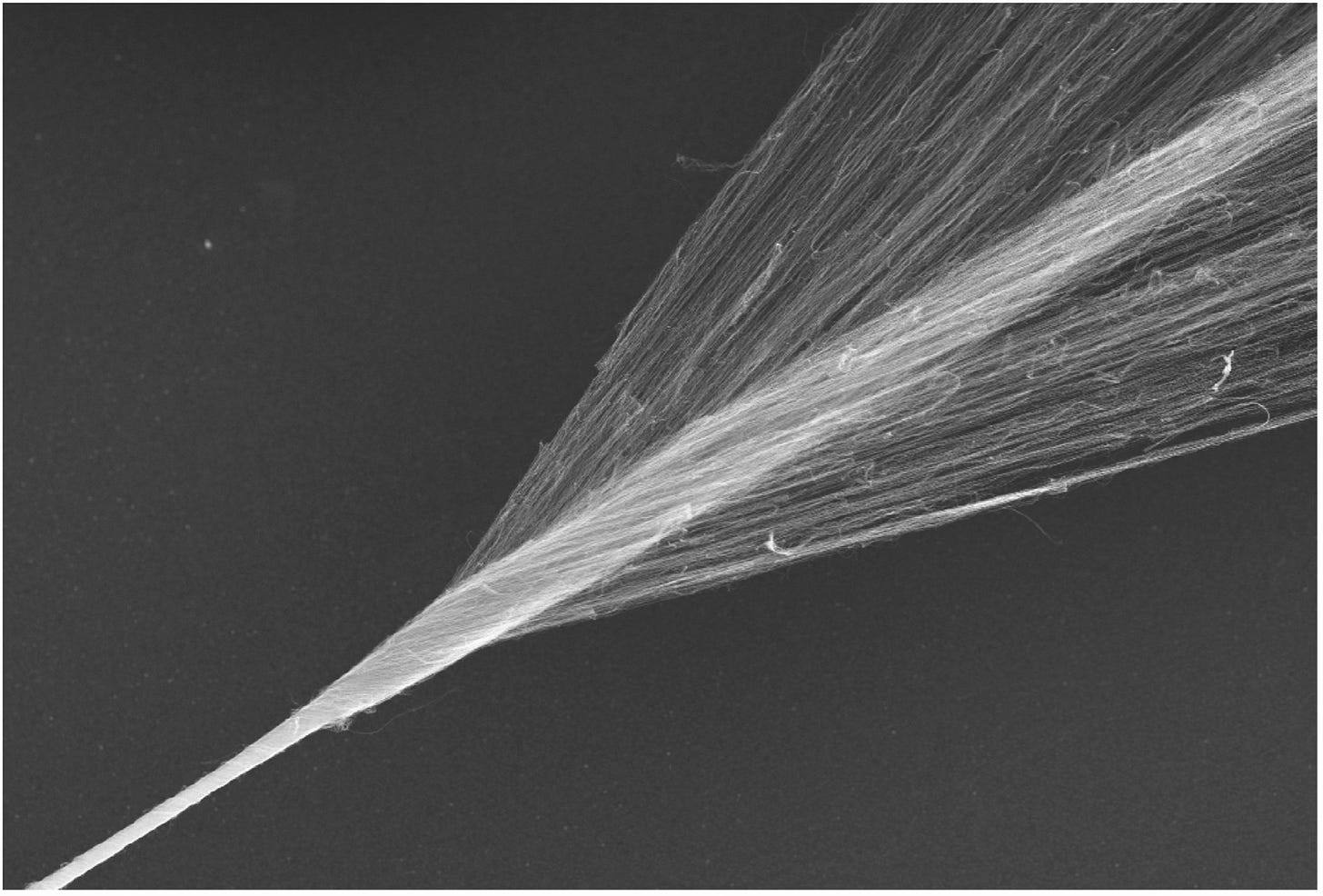

Weitere Beispiele für materialwissenschaftliche Innovationen sind weniger spektakulär aber haben dafür eine größere Breitenwirkung: Kohlenstoff-Fasern werden dank besserer Fehlererkennung, neuer Produktionstechniken sowie Beimengung von Nanotubes oder Graphen immer stärker. Für hocheffiziente, leichte Elektromotoren werden Permanentmagnete immer wichtiger - Quantentheoretische Modellierung hilft dafür neue Materialien zu entwickeln, die nicht mehr auf seltene Elemente angewiesen sind. Nanoporige Aerogele sind extrem wirkungsvolle Isolationsmaterialien, die dank neuer Basismaterialien und Verfahren immer günstiger zu produzieren sind und deshalb zunehmend nicht nur in der Industrie, sondern auch in der Bauwirtschaft verwendet werden. Bei der Suche nach neuen Materialien hilft immer häufiger auch eine Kombination von künstlicher Intelligenz und Quantenmechanik: Die Forschung kannte bisher rund 48‘000 verschiedene Kristalle. Google DeepMind hat kürzlich 2,2 Millionen weitere mögliche Kristalle gefunden. In wenigen Monaten haben Forscher 700 davon synthetisieren können.

Auf diese Weise ermöglichen Nanowissenschaften nicht nur ganz neue Arten von Informationsverarbeitung und Kommunikation oder das Verstehen und Beeinflussen von biologischen Systemen inklusive ganz neuer Möglichkeiten, Nahrung herzustellen. Mit den Materialwissenschaften wachsen auch die Möglichkeiten, die mechanischen, elektrischen, thermischen und optischen Eigenschaften von industriell verwendeten Materialien zu optimieren. Unser Verhältnis zur materiellen Welt ändert sich rapide.

Damit eröffnen sich einerseits ganz neue Anwendungen, andererseits kann es dadurch gelingen, bei gleicher Wirkung mit wesentlich weniger Material und Energie auszukommen. Information kann Material und Energie ersetzen. Ob allerdings mit steigender Effizienz auch der Verbrauch sinkt, hängt davon ab, ob die Menschen mit den neuen Möglichkeiten weise umgehen. Es wäre dringend notwendig: 2024 ist der Earth Overshoot Day schon am 1. August: an diesem Tag hat die Menschheit schon so viele erneuerbare Ressourcen verbraucht, wie die Erde im ganzen Jahr wiederherstellen kann.

Neuartige Batterien dank Quantentheorie in der Materialwissenschaft

Robert A. Huggins und Carl Wagner waren einflussreiche Mitbegründer der modernen Materialwissenschaften. Mit ihren Arbeiten über die Bewegung von Ionen in Festkörpern in den 1960er Jahren schafften sie wesentliche Grundlagen für die spätere Entwicklung der Lithium-Ionen-Batterie.

Der Metallurge Robert A. Huggins (*1929) gründete 1959 an der Stanford University das Department of Materials Science and Engineering und dann das Center for Materials Research. Er war Mitgründer materialwissenschaftlicher Zeitschriften und Gesellschaften, zeitweise auch Direktor der materialwissenschaftlichen Abteilung der ARPA. Dass er 1965/66 bei Carl Wagner am Max-Planck-Institut für biophysikalische Chemie in Göttingen ein Sabbatical verbrachte, bezeichnete er später als entscheidenden Anstoß für seine späteren Arbeiten an Lithium-Ionen-Batterien in den USA und in Deutschland.

Carl Wagner (1901-1977) war einer der Begründer der Feststoffchemie. Früh war er ein außerordentlich produktiver akademischer Forscher an verschiedenen deutschen Universitäten. 1933 wurde er Mitglied der Nazi-Organisation SA. Später lieferte er wichtige Beiträge zur Entwicklung der deutschen Raketenwaffen. Nach 1945 entzog er sich der Entnazifizierung, indem er als Mitglied der Arbeitsgruppe von Wernher von Braun in die USA ging, dort an Raketenbrennstoffen arbeitete und Professor für Metallurgie am MIT wurde. 1958 kehrte er nach Deutschland zurück und wurde Direktor des Max-Planck-Instituts in Göttingen – ausgerechnet als Nachfolger von Karl-Friedrich Bonhoeffer, einem fünfmal für den Nobelpreis nominierten Physikochemiker mit einer ganz andere Vergangenheit: Er stammte aus einer Familie, die im Widerstand gegen die Nazis aktiv war, hatte die Wasserstoff-Forschung aufgegeben, um nicht wie sein Freund Werner Heisenberg an der Entwicklung einer deutschen Atombombe teilzunehmen und hatte vermutlich den englischen Geheimdienst mit Informationen versorgt.

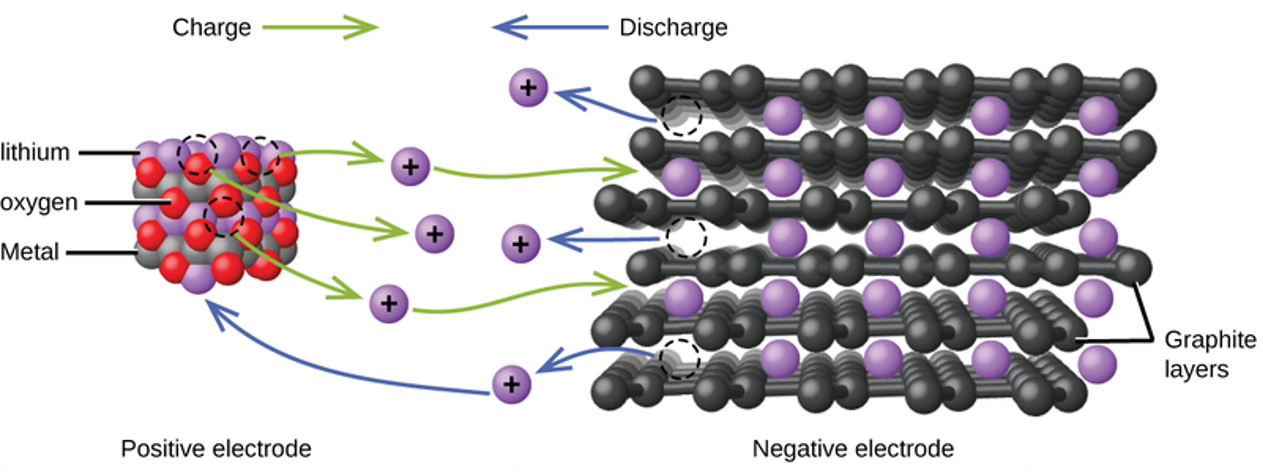

Schon 1841 hatte man entdeckt, dass Schwefelsäure in Graphit eingelagert und auch wieder ausgetrieben werden kann, wobei sich die elektrischen, mechanischen und optischen Eigenschaften des Graphits stark ändern. Offenbar lagerten sich die Fremdmoleküle im Innern der Graphitkristalle zwischen den Kristallebenen ein. Man nannte das Interkalation. Im Laufe der Jahrzehnte entdeckte man weitere solche Einlagerungen, aber konnte sie nicht erklären oder vorhersagen. Erst aufgrund der neuen Erkenntnisse zur Bewegung der eingelagerten Ionen (geladenen Moleküle) begann man die Mechanismen und Effekte besser zu verstehen. Schnell wurde klar, dass das für den Bau von effizienteren Batterien sehr interessant sein konnte: Wenn elektrochemische Ladungsträge nicht nur auf der Oberfläche von Elektroden, sondern auch in ihrem Inneren gespeichert werden konnten, versprach das eine wesentlich höhere Kapazität. Interkalation wurde zum Schlüssel für eine ganz neue Generation von Batterien.

Bis zur konkreten Umsetzung war es allerdings noch ein langer Weg, an dem viele verschiedene Spezialisten beteiligt waren. Erst 2019 wurden John B. Goodenough, M. Stanley Whittingham und Akira Yoshino für ihre entscheidenden Beiträge zur Erfindung der Lithium-Ionen-Batterie mit dem Nobelpreis für Chemie ausgezeichnet.

1976 baute der Chemiker Whittingham (*1941) bei der Ölfirma Exxon die erste Lithium-Ionen-Batterie. Sie beruhte auf der Interkalation von Lithium-Ionen in Titan-Disulfid. Die Ölindustrie war damals sehr interessiert daran, Alternativen zum Erdöl zu entwickeln, von dem man befürchtete, dass es bald zu Ende gehen werde. Whittingham unterstrich die grundsätzliche Bedeutung der Interkalation für die neue Batteriegeneration – weit über Lithium-Ionen-Batterien hinaus. "It’s like putting jam in a sandwich”, sagte er später in einem Interview, “In chemical terms, it means you have a crystal structure, and we can put lithium ions in, take them out, and the structure’s exactly the same afterwards”.

Dem Materialwissenschaftler Goodenough (1922-2023) gelang es dann 1980 an der Universität Oxford, mit einem anderen Kathodenmaterial die Leistung von Lithium-Ionen-Batterien zu verdoppeln. Um das zu erreichen, stützte er sich ausgiebig auf detaillierte quantentheoretische Modellierungen der Interaktion von Lithium-Ionen und Wirtskristallen. Sein Patent wurde vom britischen Atomic Energy Research Establishment an die Firma Sony und andere japanische Firmen lizensiert. Zuvor hatte Goodenough am Massachusetts Institute of Technology (MIT) mit seinen Arbeiten zu magnetischen Eigenschaften von Metalloxiden ganz wesentlich zur Entwicklung von RAM-Speichern (Random Access Memory) beigetragen, die bis heute ein zentraler Baustein von Computern sind. 1970 fing er an, sich mit erneuerbaren Energien zu beschäftigen, um die Abhängigkeit vom Erdöl zu beenden. Sonnenenergie setzte geeignete Energiespeicher voraus. Zu deren Entwicklung wollte er beitragen. In seinem Labor am MIT, das von der Air Force finanziert wurde, war es ihm nicht erlaubt, sich damit zu beschäftigen – so ging er schließlich nach Oxford. Schon früh übte er Hartnäckigkeit und Zielstrebigkeit, denn er schaffte es, aus eigener Kraft seine Dyslexie zu überwinden – über die man damals noch wenig wusste – um von einem schlechten Schüler zu einem brillanten Mathematik- und Physikstudenten zu werden. Er forschte bis ins hohe Alter an neuartigen Batterien und starb 2023 mit über hundert Jahren.

Der japanische Chemiker Akira Yoshino (*1948) schließlich konnte 1985 bei der Firma Kawasaki durch die Vermeidung von reinem Lithium die Sicherheit des neuen Batterietypus so verbessern, dass sie praktisch für Consumer-Produkte eingesetzt werden konnte. 1991 starteten Sony und Asahi Kasei den kommerziellen Verkauf von wiederaufladbaren Lithium-Ionen-Batterien.

Erst die Quantentheorie hatte es im Laufe der Jahre ermöglicht, die Bewegung und Einlagerung von Ionen in Kristallgitter so zu verstehen, dass die Interkalation für Batterien nutzbar wurde, und dann auch gezielt besonders leistungsfähige Materialkombinationen zu finden. Ohne die neuen Materialwissenschaften, in der verschiedene Disziplinen zusammenarbeiten, wäre diese folgenreiche Innovation nicht möglich gewesen.

In der nächsten Folge dieser Serie wird es um den Siegeszug der Lithium-Ionen-Batterie, neuartige Batterietypen und die weitreichenden Veränderungen gehen, die durch kostengünstige Stromspeicher ermöglicht werden.

6.8.2024: Kleinere Präzisierungen

Auch als Physikbanause kann ich diesen gut geschriebenen Beiträgen zur Technikgeschichte viel abgewinnen. Ich staune, was alles dank wissenschaftlich-technischem Fortschritt für eine nachhaltige Energieversorgung möglich wäre. Hoffentlich verstehen es die Politikerinnen, die Weichen richtig zu stellen.